知识增强的神经机器推理是一个前沿但具有挑战性的研究领域,具有广泛的实际应用。近年来,大量研究利用各种形式的外部知识来增强深度模型的推理能力,以应对有效的知识整合、隐式知识挖掘、可处理性和优化问题等挑战。然而,缺乏对现有的跨不同应用领域的知识增强推理技术的全面技术综述。**本文对该领域的最新进展进行了深入研究,提出了一种新的分类法,将现有的知识增强方法分为两个主要类别和四个子类。**系统地讨论了这些方法,并强调了它们的相关性、优势和局限性。最后,阐述了当前的应用领域,并对未来的研究前景进行了展望。

https://www.zhuanzhi.ai/paper/ae0d72adc5ba3100bd3bfbb71e244e2c

引言

**人工智能(AI)一词诞生于上个世纪,其最终研究目标是制造一个能像人类一样推理的智能系统,即感知现有证据,综合与问题相关的信息,并推断出新的知识来解决看不清的任务。**早期的人工智能研究以手工制作和逻辑规则为主,推理能力较强,但系统的可扩展性和泛化性较差。随着深度神经网络的发展,最先进的深度学习模型擅长从大量数据中提取特定任务的预测模式。为了进一步向人工通用智能(AGI)迈进,我们意识到当前的学习系统需要能够在不同的任务中进行更深入和适应性的思考。具体而言,近年来人工智能研究出现了两个主要趋势: 1)超越模式识别,转向逻辑推理,这与人类的互补学习策略(即思维系统I和II[25])相呼应; 2)从特定任务模型转向通用智能,这需要利用外部知识13的能力。 **事实上,类人智能确实需要上述两种趋势之间的协同作用。为了获得更强的决策和逻辑推理能力,人类需要理解和嵌入现有证据的逻辑过程。**另一方面,人类在现有知识的帮助下对任意(看不见的)任务做出预测或构建方法也是必不可少的。尽管有上述强烈的动机,但直到最近,由于近年来几个关键领域的进步,在协同深度推理和知识增强方面的努力才出现爆炸式的快速增长。具体来说,快速发展的高性能计算基础设施能够构建超大型神经网络(例如具有1750亿个参数的GPT-3[6]),通过存储在参数中的隐含知识固有地表现出推理能力。此外,最近发展的各种有组织和结构化的知识库也可以提供丰富的外部信息,包括推理所需的一般知识和特定领域的知识。

**赋予深度模型推理能力具有挑战性,但外部知识可能会提供一个良好的开端。然而,使用外部知识进行艰难的逻辑推理会使系统变得脆弱,因为它只依赖于演绎。另一方面,归纳推理是传统深度学习的核心焦点。**因此,为这两种方法开发一种“协同工作”技术是一个开放的研究问题,它带来了几个挑战,包括但不限于:1)知识集成的困难。显式知识,尤其是基于规则的知识,很难泛化,因为它可以是手工制作的或非常特定于某个领域。另一方面,规则结构的形成需要不同类型的集成(例如几何嵌入)。从结构化的外部知识(如知识图谱)中收集的事实可能是稀疏的,这可能会降低推理性能。此外,每个领域数据都有自己的隐藏特征。因此,外部知识需要具有领域自适应,才能进行适当的整合。在集成过程中,确定外部知识的权重会引发非常特定于任务的问题。由于有效逻辑不足、语义不佳、标记实例不足等原因,外部知识面临稀缺问题。它也可以用隐藏的错误信息加以修饰,阻碍提取知识的过程。此外,广义的外部知识给系统检测和全面理解主观知识和领域知识带来了挑战。2)外部知识与深度模型的衔接问题。为了将外部知识和深度模型结合起来,我们必须填补知识规则的离散性和深度模型的连续性之间的空白。这激发了两个潜在的策略方向:一是使深度模型能够查询外部知识。但它会遇到检索的挑战。为了减少工作量和计算资源,会出现处理并行性、小批训练性能差、内存重用等问题。另一种方法是将知识表示为嵌入参数或模型参数。然而,挑战在于预训练的参数模型可能会由于用于训练这些模型的数据而引入偏差。此外,使用更大的模型需要大量的计算机能力。3)可处理性和优化方面的挑战。深度学习中的逻辑推理涉及常见的方法,如使用规则作为额外的约束。但是使用规则作为约束会导致面向参数模型的非线性和非凸约束问题。另一种常用的方法是使用概率模型。但是采样规则(例如学习广义多跳规则集)是所有方法的共同特征。由于现实世界中的所有基本规则都是难以处理的,可处理性问题是每个问题表述的共同困难。此外,开发端到端可微框架是一项非常具有挑战性的任务,这进一步导致了优化的挑战。 **最近,大量的研究[34,15,64,73,63]致力于在各种知识来源的帮助下开发推理技术,以解决上述挑战。**有大量的研究领域可以受益于知识增强的推理技术,从会话式AI开发中的常识推理到构建逻辑编程系统中的神经符号推理。然而,大多数现有的方法都是为特定的应用程序领域量身定制的,但它们的方法可能足够通用,可以处理其他应用程序中的类似推理问题。此外,为一个实际应用开发的技术可能会使另一个应用的技术发展受益。然而,在服务于完全不同社区的不同应用程序领域之间交叉引用这些技术是具有挑战性的。到目前为止,我们已经看到了一些研究[22,18,8]讨论了特定应用领域的深度推理技术。不幸的是,我们仍然错过了最新的知识增强深度推理技术的技术概述,这些技术跨越不同的知识来源和广阔的应用领域。在知识增强的深度推理技术中,缺乏系统的总结和分类,这使得相关研究人员很难对现有的研究挑战、尚未解决的问题和广阔的未来研究方向有明确的信息。

为克服这些障碍并促进AGI的发展,本文对这个快速发展的主题——知识增强神经机器推理——的当前工作(2020年以后发表)进行了首次全面概述。本调查的主要贡献总结如下:

对现有知识的第一个系统分类增强深度推理技术。根据外部知识的类型对现有技术进行了分类,并阐述了它们的形式化问题定义。总结了不同方法之间的关系和优缺点,以及每个子类别下的技术细节。

**对主要应用领域进行全面的分类和总结。**总结了现有知识增强神经机器推理技术的广泛应用领域。应用领域的分类可以很容易地映射到所提出的技术分类,以便研究人员交叉引用不同的应用领域。

**对知识增强深度推理的现状及其未来趋势进行了深刻的讨论。**在总结现有利用外部知识辅助深度推理技术的基础上,概述了当前知识增强深度推理的研究前沿。最后讨论了未来可能取得丰硕成果的研究方向。

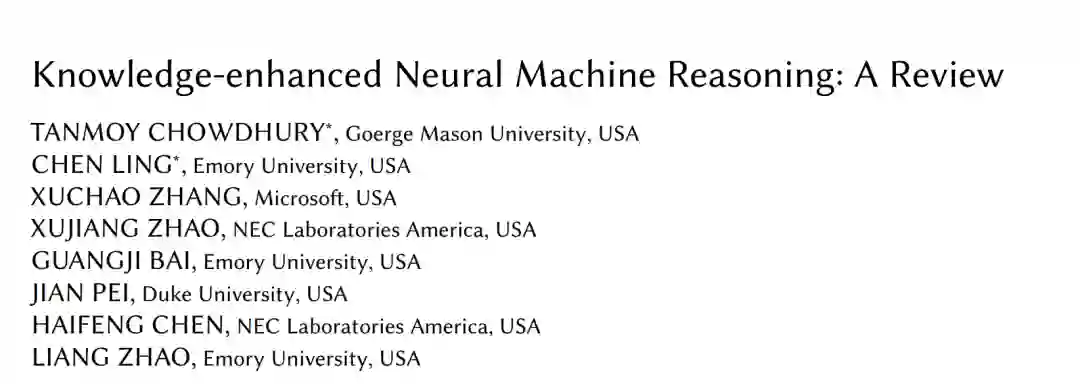

我们提出了一种分类法来显示不同推理技术中的知识利用,如图1所示。对于基于知识的推理技术,重点研究了**1)数据中存储的知识类型,2)知识的形成,3)知识的利用。**基于这三个标准,我们构建了分类法的三个层次

知识的显性取决于组织、结构、解释、可访问性和现实世界的表示。这些属性可以极大地有益于用于推理任务的技术。外部知识的种类繁多,促使我们将其主要分为两类:显性知识和隐性知识。我们分别在第3节和第4节详细讨论了这两组技术。

基于隐性知识的推理

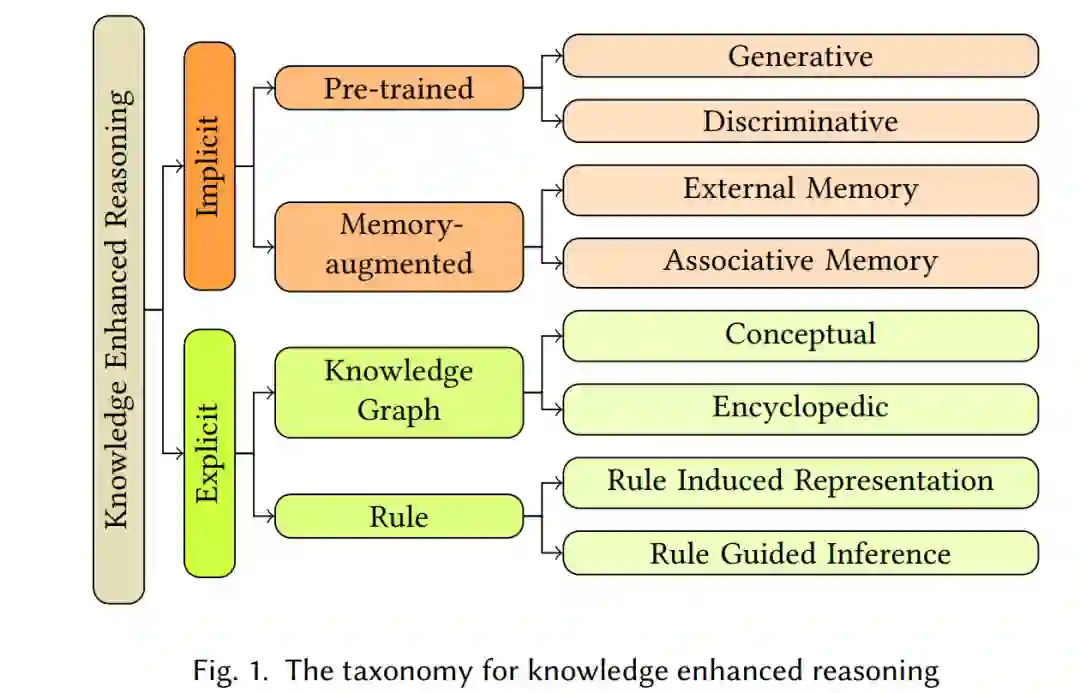

本节回顾了利用隐式知识解决推理任务的最新进展,其中相关知识以基本两种形式隐式表示:大规模预训练模型和记忆增强神经网络。这两种形式都依赖于潜在知识的参数。由于预训练模型具有唯一的参数依赖性,因此必须全部导入,而记忆增强神经网络中的半参数记忆可以从编码的知识索引中进行操作。

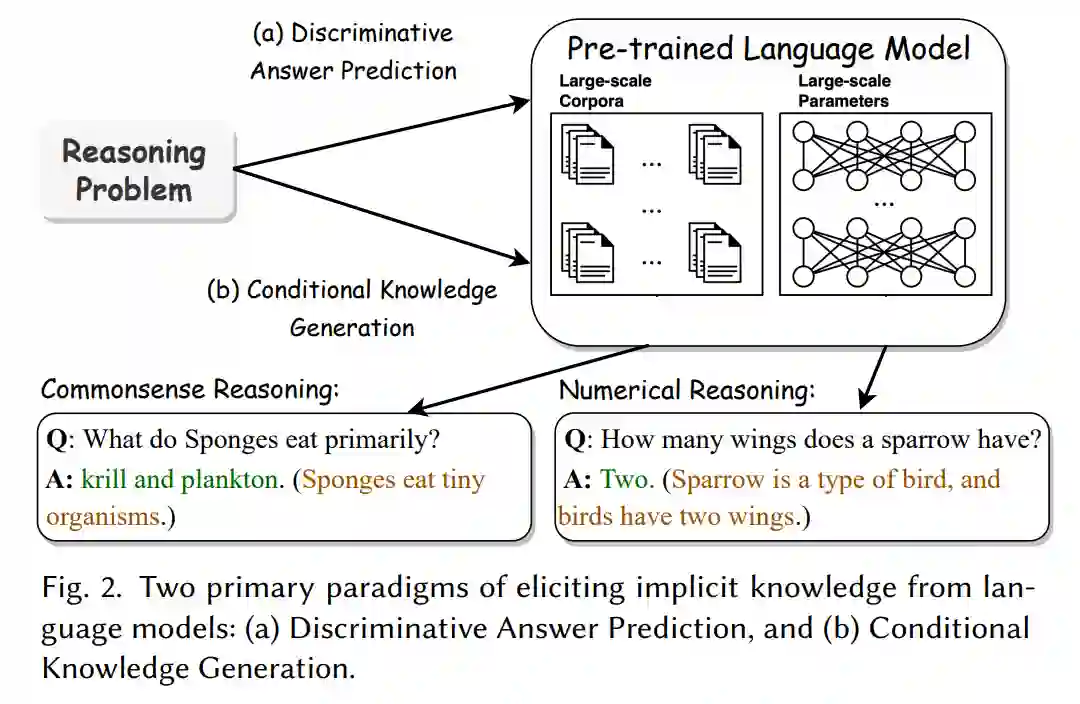

基于显性知识的推理

显性或表达性知识是可以毫不费力地记录、访问和解释的信息。显性知识的本质是逻辑的、客观的和结构化的。在过去的几十年里,人们广泛地从显性知识库中挖掘结构化知识以支持各种与推理相关的任务,包括知识图谱和知识规则。这两类知识清晰定义不同实体之间关系的能力引起了越来越多的共同兴趣。图被大量用于模型的输入层,或者用于从原始数据中收集概念。但该规则具有灵活性,可以在表示层或推理层使用。在本节中,我们回顾了利用不同显性知识形式的最新技术。