论文解读者:北邮 GAMMA Lab 博士生 张梦玫

题目: 对抗攻击鲁棒的异质图神经网络会议: AAAI 2022

异构图神经网络(Heterogeneous Graph Neural Networks, HGNNs)近年来受到越来越多的关注,并在许多任务中取得了突出的性能。然而,尽管它们被广泛使用,我们发现它们对于对抗攻击并不鲁棒。在本研究中,我们首先系统地研究了HGNNs的鲁棒性,并展示了在目标节点和hub节点(节点度高)之间添加对抗边可以很容易地欺骗HGNNs。此外,我们给出了造成HGNNs漏洞的两个关键原因:一种是扰动放大效应,HGNNs没有编码转移概率,因此会放大对抗hub邻居的影响;另一种是软注意机制,即这种机制会给明显不可靠的邻居赋予恒正的注意力值。基于这两个事实,我们提出了一种新的鲁棒HGNNs框架RoHe,通过配置一个注意力净化器,可以根据拓扑和特征对恶意邻居进行剪枝。具体来说,为了解决对抗扰动的放大效应,我们引入基于元路径的转移概率作为净化器的先验,抑制恶意邻居对于对抗hub邻居的信心。然后,净化器会学着mask掉低置信度的邻居,从而消除软注意机制中恶意邻居的负面影响。在不同基准数据集上对多个HGNNs(HAN,MAGNN,GTN)[1,2,3]进行了大量实验,在对抗性攻击下HGNNs的显著改进将证明我们的防御框架的有效性和泛化能力。

1 引言

许多真实世界的数据集都很自然地用异构图(Heterogeneous Graphs, HGs)表示,其中包含了不同类型的对象和关系。图1(a)给出了一个HG引文网络的为例,网络由三种类型的对象(作者(A)、论文(P)、主题(S))和两种类型的关系(P- A和P-S)组成。由于HGs包含丰富的高阶结构信息,元路径(两个节点类型之间的关系类型序列)被广泛用作获取此类信息的基本工具,如P-A-P(同一作者写的论文)和P-S-P(属于同一主题的论文)。近年来,随着深度学习技术的应用,异质图神经网络(HGNN)兴起,HGNN通常采用层次聚合(包括节点级和语义级)从基于元路径的邻居中获取信息,并在许多任务(如节点分类、链接预测、聚类等)上取得了最先进的性能。

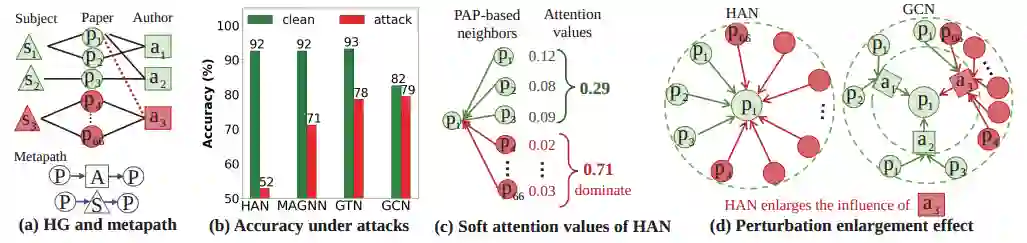

为了回答这个问题,我们测试了HGNNs的对抗鲁棒性,我们发现它们在ACM数据集上对于相同的逃逸拓扑对抗攻击(在测试阶段扰动)下的性能,攻击结果如图1(b)所示。令人惊讶的是,与GCN下降约3个点相比,HGNNs(即HAN、MAGNN和GTN)平均大幅下降约28个点。显然,HGNNs与GCNs的对抗鲁棒性存在显著差异,这促使我们进一步研究GCNs与HGNNs在模型设计上的差异。在对攻击结果的进一步分析中,我们观察到攻击者倾向于恶意地将目标节点链接到度很高的节点(即hub)。以HAN为例,攻击者在图1(a)中注入一个对抗边,这将导致恶意(红色)论文在元路径PAP下成为的直接邻居。即使它们被分配了较小的注意值,它们仍然可以主导HAN中的接受域。

本文认为,HGNNs的这种脆弱性主要有两个原因:

(1)扰动放大效应:我们将证明HGNNs会扩大对抗hub邻居的影响,而GCNs不会扩大,因为HGNNs相比,GCN是通过间接吸收这些恶意的二跳邻居,大量恶意邻居只能通过影响邻居来影响。而HAN直接聚合了基于PAP的所有邻居,从而导致”只加一条对抗边就可以注入大量恶意直接邻居“的效果。具体HAN,MAGNN,GTN的扰动放大程度等以及例子可以参见论文。

(2)软注意力机制:当存在对抗性/噪声/异配邻居时,软注意机制可能会损害GNN的性能。而这种机制在HGNNs中会造成更严重的伤害,如图1 (c)所示,大量的恶意邻居可以累积较小但恒正的注意值,最终控制HGNNs的接受域,误导的分类。基于这一事实,对于HGNNs来说,对明显不可靠的邻居分配零注意力值的能力是重要的。

图1:ACM数据集上针对HGNNs的对抗攻击的示例。(a) 异质图(HG)和元路径 (metapath)的基本概念。(b) HGNNs和GCN的鲁棒性测试。(c)对抗边下HAN中的软注意值的toy example。(d)对抗边对HAN和GCN的影响比较。

2. 模型

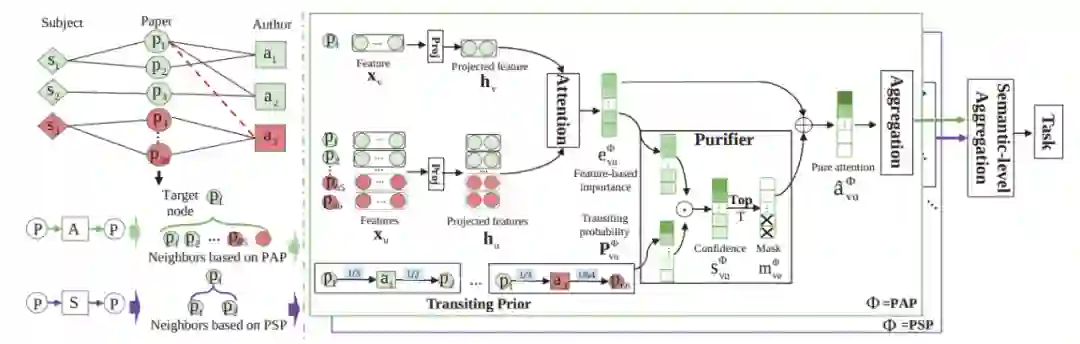

本文描述了我们提出的拓扑对抗攻击鲁棒的HGNNs框架 (Robust Heterogeneous GNNs,RoHe)。HGNNs通常采用分层聚合(包括节点级和语义级),而我们的RoHe是从节点级聚合净化邻居。图2说明了RoHe的总体架构。正如我们所看到的,对于基于每个基于元路径的邻居,我们用注意力净化器来净化被污染的注意力以进行防御。具体来说,为了减少扰动的放大效应,RoHe引入了一个转移概率作为我们的净化器的先验,降低对抗hub邻居的置信度。然后,基于转移概率和特征相似性对感受域进行收缩,mask掉置信度很低的邻居,解决了软注意力机制不能彻底消除对抗边的问题。最后,利用净化后的注意力聚合所有元路径的邻居信息,将这些元路径进行语义级聚合,最终生成下游任务的节点嵌入。注意,RoHe是一个通用的防御框架,可用于保护不同的HGNN方法。为了方便起见,我们展示了基于代表性HGNN模型的框架(HAN)。另外,我们也在实验中探索了RoHe在其他最先进的HGNN(即MAGNN,GTN)上的防御能力。

图2:RoHe的整体框架

节点特征映射:由于不同类型的节点可能具有不相等的特征向量维数或处于不同的特征空间中,HGNNs通常将不同类型节点的特征投影到公共空间中。具体地说,对于类型的目标节点,我们使用特定于类型的转换矩阵来获得投影特征,如下所示:

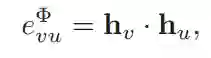

基于特征的相似性:给定一个元路径,基于“特征相似的节点比不相似的节点更有可能重要”的假设,我们通过特征的点积相似性估计了下邻居节点对目标节点的重要性:

在传统的节点级注意机制中,基于特征的重要性将通过softmax函数在上直接归一化,得到最终的软注意值。我们认为HAN中只考虑节点的特征信息,而从拓扑的角度同等对待多跳邻居,这将导致对抗hub邻居的恶意影响被扩大,此外,所有在中的邻居在softmax函数之后都被赋正值。这种软注意机制在反向传播中具有很好的可微分性,但无法对明显的恶意邻居赋零值。为了解决上述问题,我们引入了一个可微的净化器来mask掉中置信度()较低的邻居中的邻居。具体地说,我们首先利用基于元路径的转移概率作为置信度的先验来消除扰动放大问题。

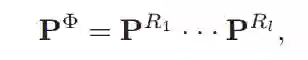

转移概率先验:给定路径,为了编码沿元路径的转移概率作为置信度的先验,我们首先计算关系,中的过渡概率矩阵 。其中,是度矩阵,中每个元素表示与下的从节点到的转移概率。然后依据下式计算基于元路径的转移概率矩阵:

也就是说,给定元路径, 包含两部分信息:(1)基于和之间沿的路径个数的连通性;(2)路径上所有节点的度的信息。

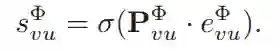

置信度: 基于转移概率先验,为了确定不可靠的邻居,我们可以通过融合 和,计算基于特征和拓扑的置信度向量

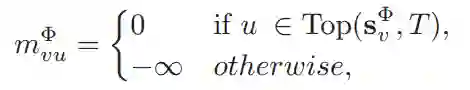

净化mask: 接下来,针对软注意力机制的问题,我们设计了一种mask操作,以可微的方式mask掉低信心的邻居。具体地,我们通过构造一个mask 向量 来建模mask 操作:

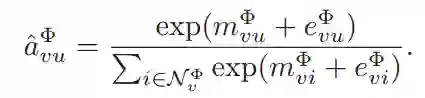

其中是要保留的邻居的数量,基于置信度返回个最可靠邻居的集合,然后将通过将其他邻居的掩码值设置为来移除不可靠邻居。softmax下,时,节点将被有效屏蔽,因为softmax对于的输出为零。 因此,我们可以使用来屏蔽大量的对抗性/噪声邻居,通过softmax函数得到 :

至此,这种方法增强了节点级注意,编码了元路径邻居的转移概率,只聚合top-的可靠邻居,缓解了扰动扩大和软注意机制问题。最后,最终的被纯化的注意力值将用于聚合邻居以实现特定语义的嵌入 :

本文的防御模型focus在节点级别的聚合,语义级聚合仍然和传统的HGNNs类似。

3. 实验

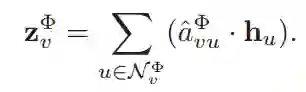

**RoHe在HAN上的对抗防御效果实验:**在三个数据集上的不同程度的攻击实验证明了我们方法的防御能力。由于没有现成的 HGNNs 防御框架, 我们直接将同质图神经网络的防御策略( Jaccard、GGCL和SimP)简单适应到HGNNs中。同时提出两个RoHe的变种方法: (只保留转移概率) and (只保留mask操作用于剪枝)。发现我们的对抗防御效果最好,同时在clean数据集中也获得了comparable的效果。

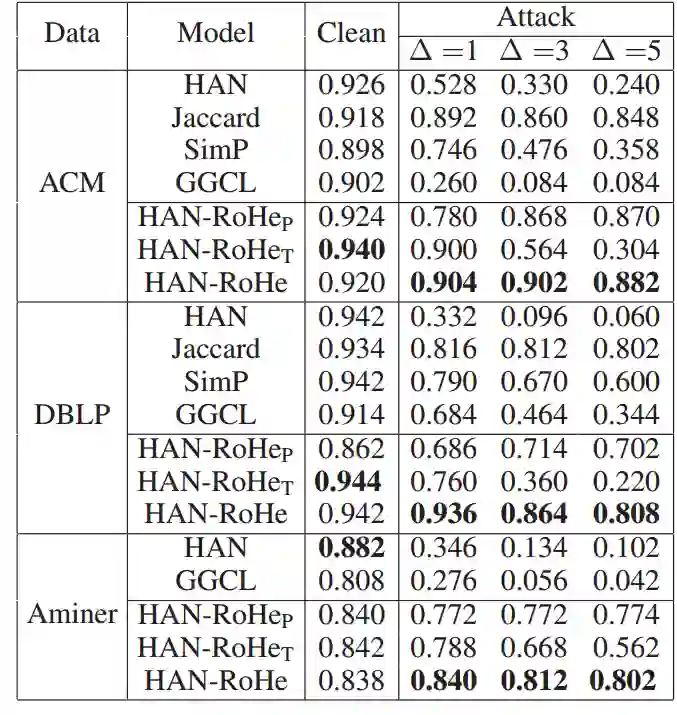

**RoHe在HAN,MAGNN,GTN上的防御实验:**证明了我们方法的泛化性

[1] Wang, X.; Ji, H.; Shi, C.; Wang, B.; Ye, Y.; Cui, P.; and Yu, P. S. 2019b. Heterogeneous Graph Attention Network. In WWW, 2022–2032. [2] Fu, X.; Zhang, J.; Meng, Z.; and King, I. 2020. MAGNN: Metapath Aggregated Graph Neural Network for Heterogeneous Graph Embedding. In WWW, 2331–2341. [3] Hu, Z.; Dong, Y.; Wang, K.; and Sun, Y. 2020. Heterogeneous Graph Transformer. In WWW, 2704–2710.