拿了顶会Best Paper的异质图神经网络是啥样?

WWW-2021最佳论文奖(亚军)-基于属性补全的异质图神经网络新架构

4月23日,万维网顶会WWW-2021 ( The Web Conference 2021: International World Wide Web Conference ) 公布了本届会议的最佳论文奖冠亚军(Winner和Runner-Up),来自天津大学金弟副教授团队的论文《Heterogeneous Graph Neural Network via Attribute Completion》斩获最佳论文奖(Runner-Up)。

WWW(现改名为TheWebConf)会议是万维网领域的顶会,由图灵奖得主Tim创办,被中国计算机协会将其认证为CCF-A类会议,每年举办一次。本届WWW共计收到1736篇投稿,录用357篇论文,录用率为20.6%,其中评出最佳论文奖冠亚军各一篇。

WWW-2021最佳论文奖(亚军)来自天津大学金弟副教授团队。该研究原创性的提出了异构信息网络属性补全问题及其高效求解方案。该方案正交于已有异构图神经网络框架,并在多个真实世界的异质数据集上取得了优秀的结果。

-

题目:Heterogeneous Graph Neural Network via Attribute Completion -

文章链接:https://dl.acm.org/doi/10.1145/3442381.3449914 -

代码链接:https://github.com/jindi-tju/HGNN-AC

1. 内容简介

异质信息网络(HINs)也称为异质图,它是一种由多种类型的节点和边组成的复杂网络,包含了全面的信息和丰富的语义。图神经网络(GNNs)作为处理图结构数据的强大工具,在网络分析任务中表现出了卓越的性能。最近相继提出了许多基于图神经网络的异质图模型,并取得了巨大的成功。图神经网络旨在通过节点属性间的传播和聚合操作来完成图表示学习任务,因而完备的节点属性是算法运行的必要前提。

然而,大多数真实世界的场景通常存在信息不完备的问题,表现在异质信息网络中即为:常存在某些类型节点的属性完全缺失的现象,比如在包含三种类型节点的引文网络ACM中,只有paper节点含有原始属性,author和subject节点没有属性。不同于同构网络中某些结点的属性缺失或节点属性在某些维度上的缺失,异质网络中的属性缺失程度更大、更为复杂。已有的一些异质网络表示学习方法主要针对模型的改进来提高算法性能,对于属性的缺失采用一些简单的手工插补方法(例如平均插补、one-hot向量插补)进行补全。这些方法将属性补全与图表示学习过程分开,忽略了准确的属性对于下游任务的重要性,因此很难使用简单插补后的属性来保证模型的性能。实际上,准确的输入是任何模型实现性能提升的基础,在异质网络更为复杂的属性缺失情况下,准确的属性变得更为重要。

因此,本文认为与设计新的模型相比,科学准确地补全缺失的属性应该成为异质网络分析任务的另一个重要研究方向,并且属性补全和模型设计可以相互增强。基于此,本文提出以可学习的方式来补全缺失的属性,并通过采用属性补全与图神经网络模型相互增强的模式来构建一个针对属性缺失异质网络的异质图神经网络通用框架(HGNN-AC)。

HGNN-AC共包含四个关键设计:基于拓扑结构的先验知识预学习、基于注意力机制的属性补全、弱监督重构损失的设计和端到端模型的构建。本文在三个真实世界的异质网络上进行了大量的实验,结果表明所提出的框架优于最新的基准。

2. 方法

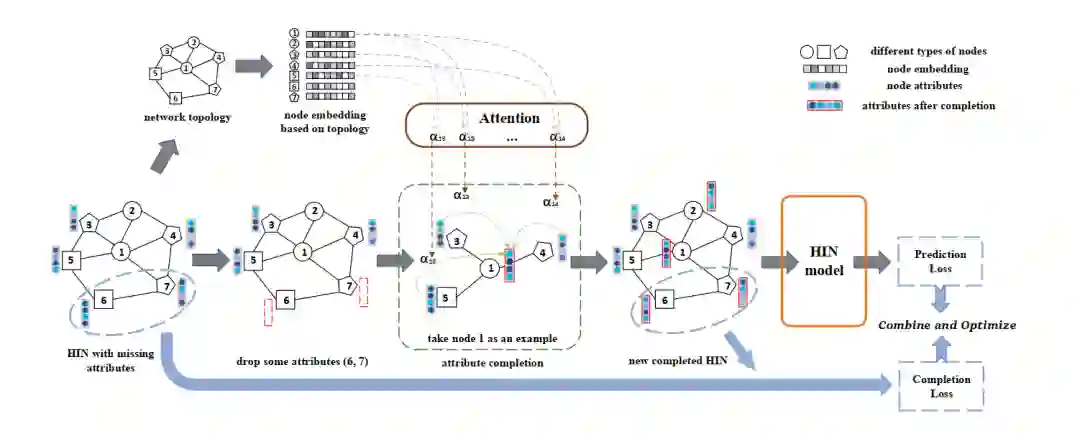

本文提出的框架主要由四部分组成(如下图所示)。首先,采用经典的异质网络表示学习方法,利用拓扑结构来获取节点的拓扑表示,以此捕获节点之间高阶的拓扑关系作为属性补全的先验知识。其次,基于节点的拓扑表示计算无属性节点与直接相连的已有属性节点之间的关系,通过对已有属性节点的属性进行加权聚合来为无属性节点进行属性补全。然后,通过随机删除部分已有属性节点的属性,并使用所提出的属性补全方法为这些节点重构属性以构建弱监督损失。最后,设计属性补全与基于图神经网络的异质模型相结合,使整个系统实现端到端,完成任务导向的属性补全。

1) 节点拓扑表示的预学习

由于网络中拓扑结构和属性携带的语义信息往往具有很强的相似性,本文认为网络拓扑中的高阶异质关系有助于属性补全,因此本文采用经典的异质网络表示学习方法(例如metapath2vec)利用拓扑结构捕获节点之间的关系来学习节点的表示 ,并将其作为指导属性补全的先验知识。

2) 基于注意力机制的属性补全

为带有属性的节点集合, 为属性缺失节点的集合。本文利用上述获得的先验知识 ,使用注意力机制计算缺失属性的目标节点的一阶邻居节点对其的重要性程度,并根据重要性系数来聚合已有属性的一阶邻居节点( 中的结点)的属性,为目标节点( 中的节点)进行属性补全。

具体来说,给定节点对 和其对应的节点表示 和 (其中节点 为没有属性的目标节点,节点 属于节点 的一阶邻居中带有属性的节点集合 ), 计算 节点对于 节点的重要性系数:

进行归一化:

根据归一化的系数聚合 中的节点的原始属性为目标节点 进行属性补全:

为了稳定学习过程并减少高方差,本文最终采用多头注意力机制进行属性补全:

3) 删除原始属性以构建弱监督损失

为了确保属性补全过程是可学习的,同时补全的属性是准确的,本文将带有原始属性的节点随机划分为 和 ,将 中节点的属性删除,并采用上一步中属性补全机制来重构删除的属性:

通过计算原始属性和重构属性之间的欧氏距离得到属性补全的弱监督损失:

4) 与异质图神经网络模型结合构建端到端系统

通过提出的属性补全机制,本文对已有的属性和补全的属性进行组合,得到完整的属性矩阵:

将完整的属性矩阵连同拓扑结构一同输入图神经网络模型中,得到模型的标签预测损失:

为了实现任务导向的属性补全,本文将标签预测损失和属性补全损失组合,构建端到端的系统去联合优化二者:

3. 实验

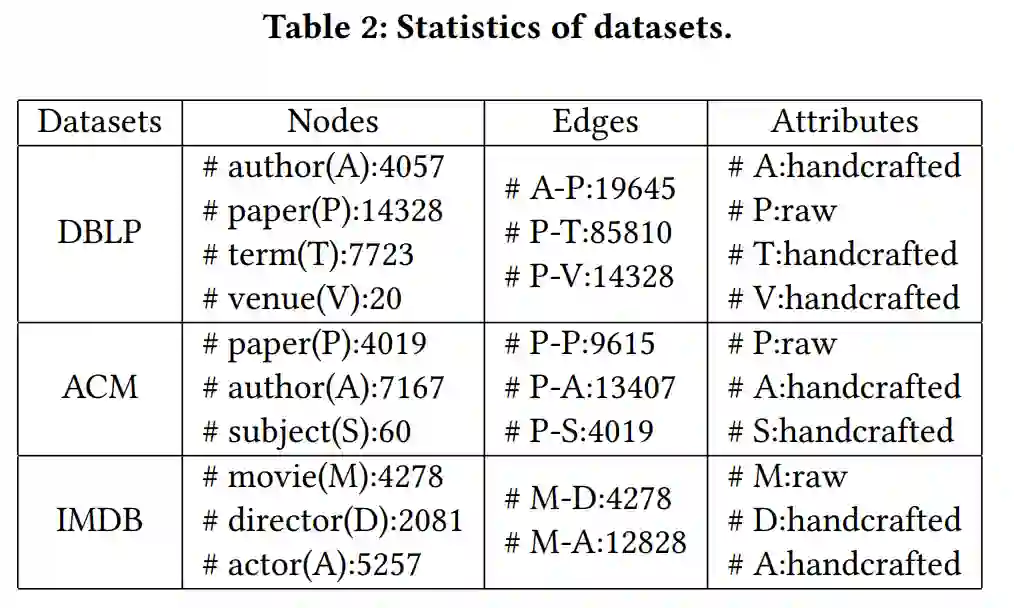

本文在三个真实的异质网络数据集上进行了实验。数据集的统计信息如下:

-

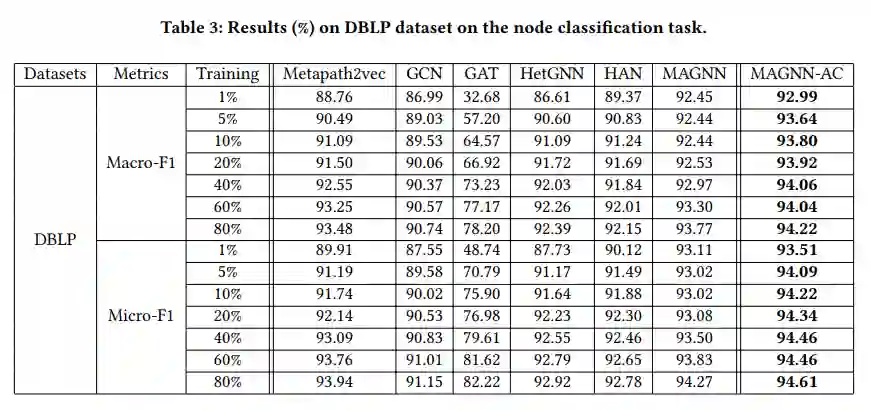

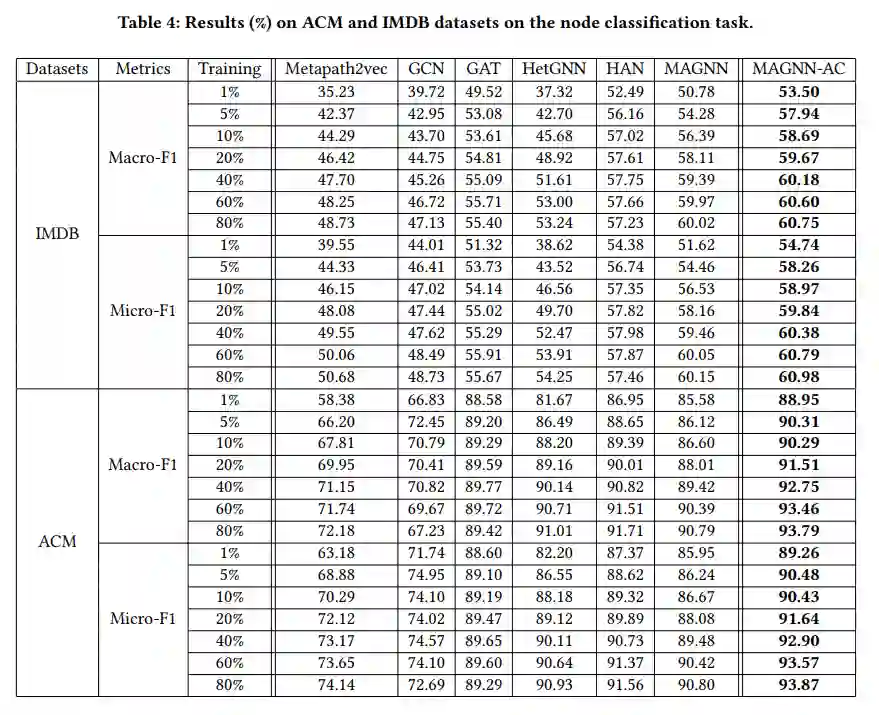

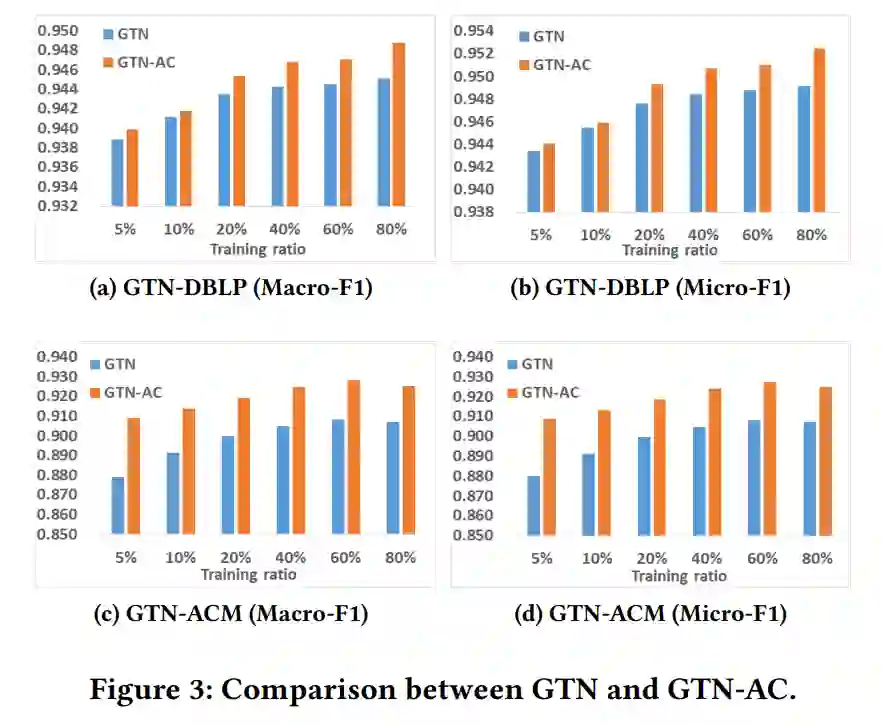

节点分类结果-将本文提出的框架与两个异质图神经网络的SOTA模型(MAGNN,GTN)相结合来对HGNN-AC框架进行评估:

-

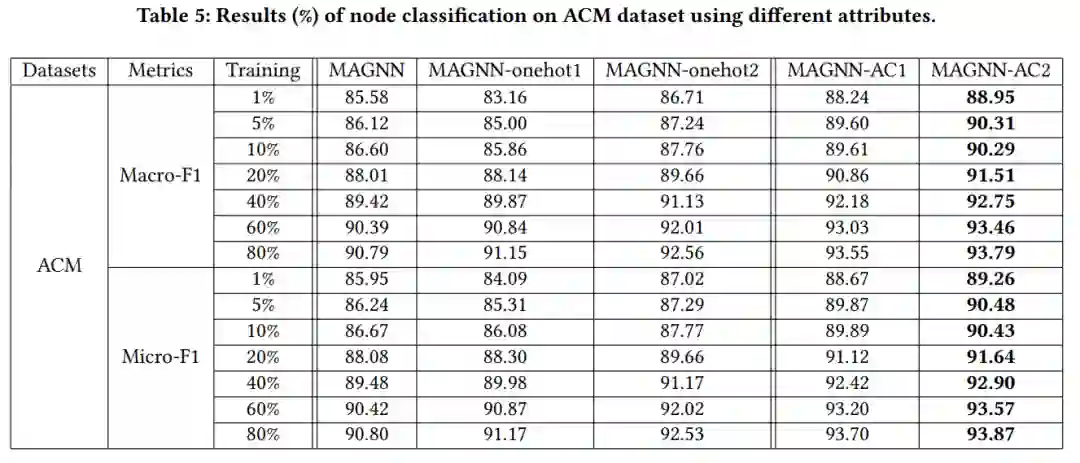

案例分析-采用不同的属性补全方式进行实验对比,ACM数据集中paper节点有属性,author和subject节点没有原始属性,下表中从左到右采用的属性补全方式依次为:paper和subject节点的属性向量来源于与其直接相连的paper节点的属性向量的平均值;author节点的属性向量为one-hot向量,subject节点的属性向量为与其直接相连的paper节点的属性向量的平均值;author和subject节点的属性均为one-hot向量;author节点的属性通过本文提出的方法进行补全,subject节点的属性为one-hot向量;author和subject节点的属性均通过本文提出的方法进行补全。

4. 总结

本文发现,面对异质网络中复杂的属性缺失情况,与专注于设计新模型的传统研究方向相比,属性补全变得尤为重要,并且可以成为一个全新的、更有效的提升性能的方向。本文首次科学地对异质网络中的缺失属性进行了补全,并提出了通用的框架来解决异质图神经网络模型中面对的属性缺失问题。具体地,在该框架中,首先基于面向元路径的高阶拓扑信息来挖掘节点间关系,并将其作为节点之间语义关系的先验知识。接着为节点属性的补全提供了一种具有先验信息指导的、有效的注意力机制,并通过随机删除属性来实现弱监督损失的定义,从而使属性补全成为在先验知识指导下合理的可学习过程。最终在同一图神经网络框架下定义了属性补全过程和目标任务,以构建任务导向的端到端框架,实现两者的相互增强。该框架可与多数异质图神经网络模型正交,为这些模型带来稳定的性能提升。本文也希望这种新观点能够为现有的基于图神经网络的异质网络研究提供一个新的、有效的方向。