01 研究背景

一图胜千言,一件艺术品可以讲述整个故事。艺术风格描述了艺术品的外观,是艺术家描绘主题以及表达愿景的主要方式。风格取决于描述艺术品的特征,不同艺术家可能使用不同的形式、颜色和构图的方式等。

艺术风格迁移,作为一种将自然图像的内容与现有绘画图像的风格相结合来创造新绘画的有效方式,是计算机图形学和计算机视觉领域的热点研究课题。

风格表征是艺术风格迁移中最重要的问题之一。尽管近年来任意图像风格迁移领域取得了显著进展,但二阶特征统计(Gram 矩阵或均值/方差)风格表示限制了艺术风格迁移方法进一步的发展和应用。 在本文中,我们重新审视了基于神经网络风格迁移方法的核心问题,即合理、真实的艺术风格表示。我们的出发点:对于没有艺术知识的人,如果只给出一张艺术图片,他很难定义风格,但当大量艺术图片被同时展示时,识别不同风格之间的差异就相对容易。

因此,我们使用对比学习方法来改进风格表示并用于艺术图像风格迁移任务。具体来说,我们提出了一个新颖的对比风格迁移 (CAST)框架,用于图像风格表示和风格迁移。CAST 由一个基于编码器-转换器-解码器结构的主干网络、一个多层投影器模块(MSP)和一个域增强(DE)模块组成。我们引入对比学习来考虑风格之间的相对关系,使用 DE 来学习整体艺术图像域的分布。为了捕捉各种尺度的风格特征,我们的MSP模块将风格图像每一层的特征投影到相应的风格编码空间。

02 研究内容

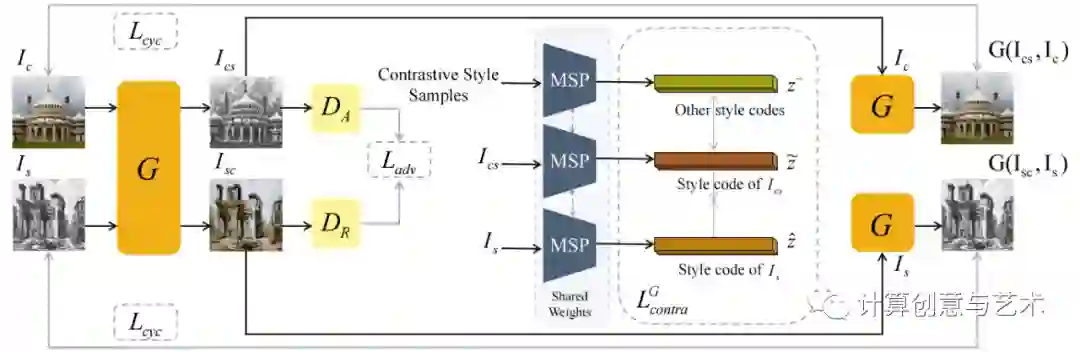

如图所示,CAST的框架由三个关键组件组成:(1)多层风格投影模块,经过训练可将艺术图像投射为合适的风格编码;(2)对比风格学习模块,用于指导多层风格投影模块的训练和风格图像的生成;(3)域增强模块,帮助学习艺术图像域的分布。所有这些组件都用于学习风格表示,度量输入绘画和生成结果之间的差异,因此,它们可与各种主流的的风格转移网络融合。

2.1 多层风格投影 MSP

MSP模块包括一个风格特征提取器和一个多层编码器。我们的 MSP 不是使用来自特定层的特征或多个层的融合,而是将不同层的特征投影到单独的潜在风格空间中,以编码局部和全局风格提示。 经过训练,MSP可以将艺术图像编码成一组潜在风格代码,可以插入现有的风格迁移网络作为风格化的指导。接下来,我们将描述如何使用对比学习策略联合训练 MSP 和风格迁移网络。

2.2 对比风格学习

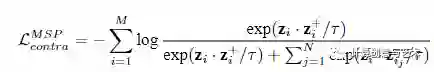

我们采用对比学习并设计了一种新的对比风格损失作为网络训练的隐式测量。在训练 MSP 时,将图像I及其增强版本I+(随机调整大小和裁剪、旋转)输入MSP,并将风格特征映射到一组K维向量{z}。对比表示通过最大化I和I+之间的互信息来学习图像的视觉风格,而数据集中的其他艺术图像被视为负样本{I-}。具体来说,图像I、I+和N个负样本分别映射到M组K维向量z,z+和{z-}。向量被归一化以防止崩溃。我们定义对比损失函数为:

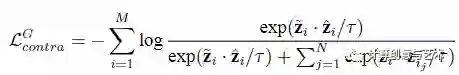

对比表示还为生成器G 在图像之间传输风格提供了适当的指导。我们采用与上式中用于学习MSP相同形式的对比损失,但使用输出图像 Ics和参考图像Is的对比表示来计算损失,那么Ics将具有类似于Is的风格:

2.3 域增强 DE

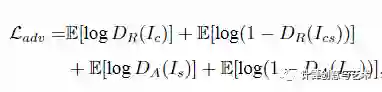

我们引入具有对抗性损失的DE,以使网络能够学习风格分布。最近的风格迁移模型采用GAN将生成的图像的分布与特定的艺术图像对齐。对抗性损失可以增强风格化结果的整体风格,同时它强烈依赖于分布数据集。即使有特定的艺术风格损失,生成过程通常也不够鲁棒,无法避免伪影出现。 与之前的这些方法不同,我们将训练集中的图像划分为现实域和艺术域,并使用两个鉴别器分别对其进行增强。在训练过程中,我们首先从现实域中随机选择一张图像作为内容图像Ic,从艺术域中随机选择一张图像作为风格图像Is。Ic和Is分别作为真实感图像域与艺术图像域的真实样本。生成的图像Ics=G(Ic, Is)用作艺术图像域的假样本。然后,我们交换内容和样式图像以生成图像Isc=G(Is, Ic)作为真实感图像域的假样本。

该项表示为:

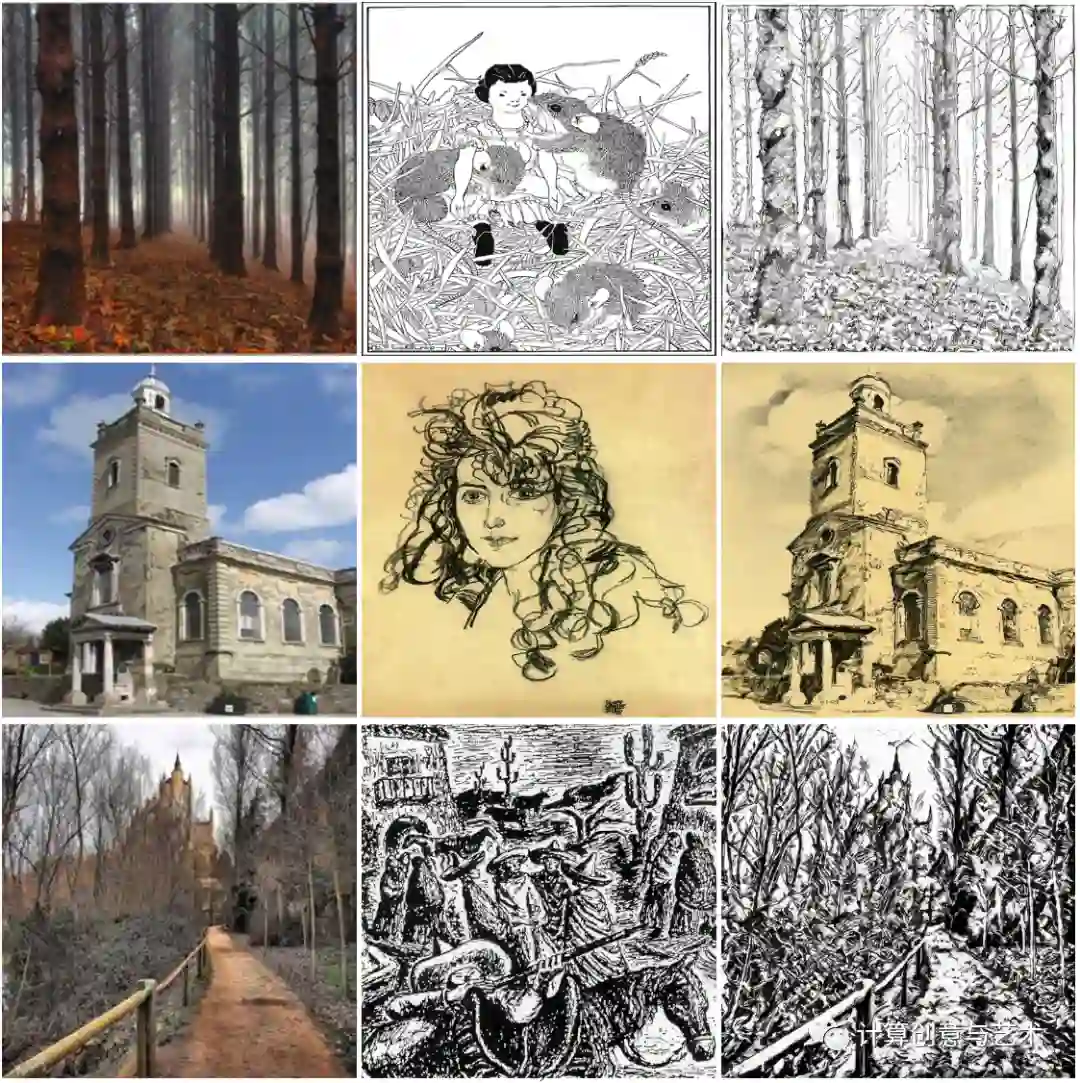

为了在两个域之间进行风格迁移的过程中保持内容图像的内容信息,我们还添加了一个循环一致性损失:

03 部分结果

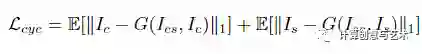

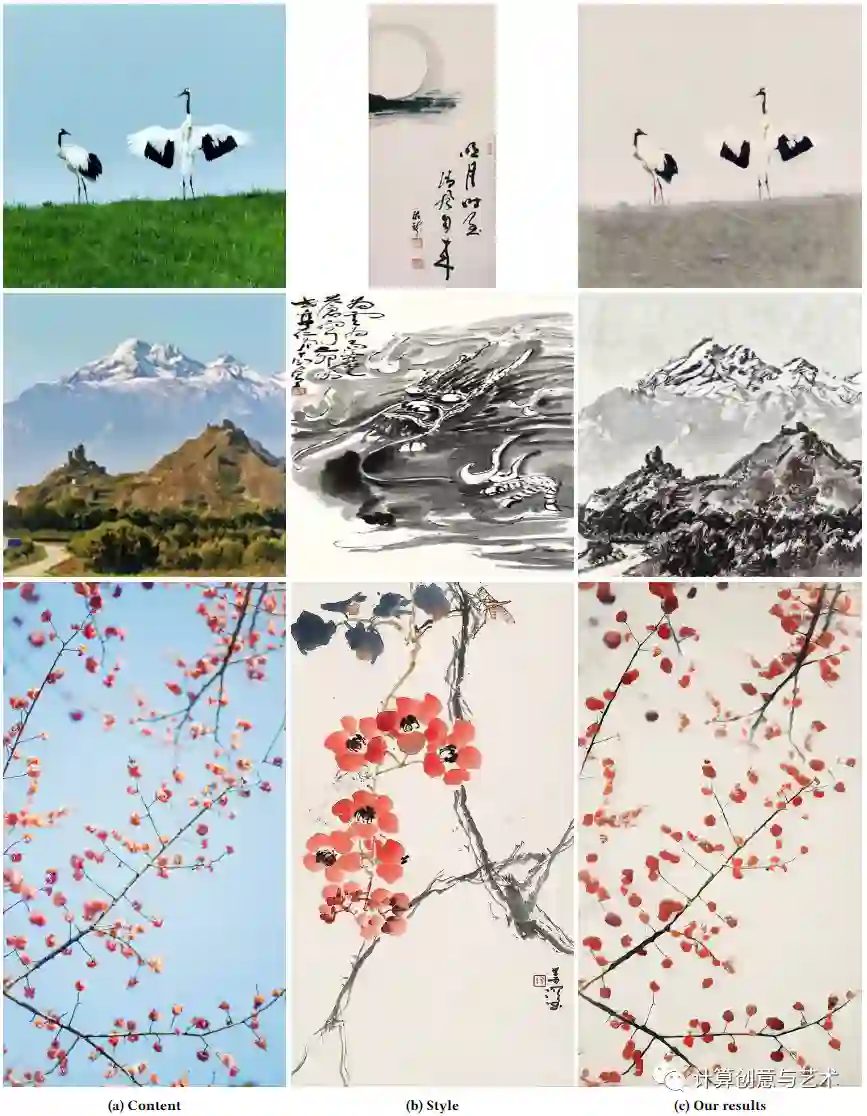

使用CAST方法的风格转换结果可以稳健有效地处理各种绘画风格。下图展示了使用同一张自然图像,变化不同风格参考图的结果。CAST可以很好地捕捉每幅画的风格特征,并生成具有独特艺术视觉外观的结果。

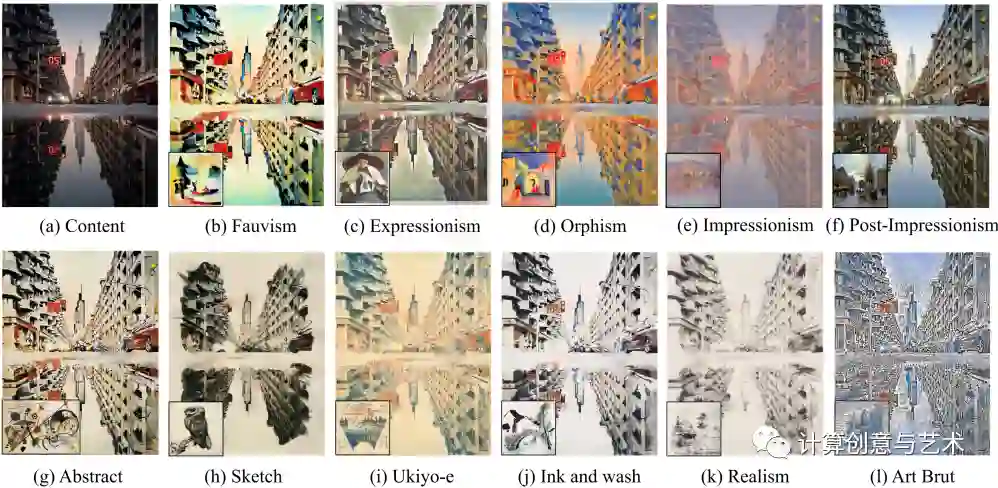

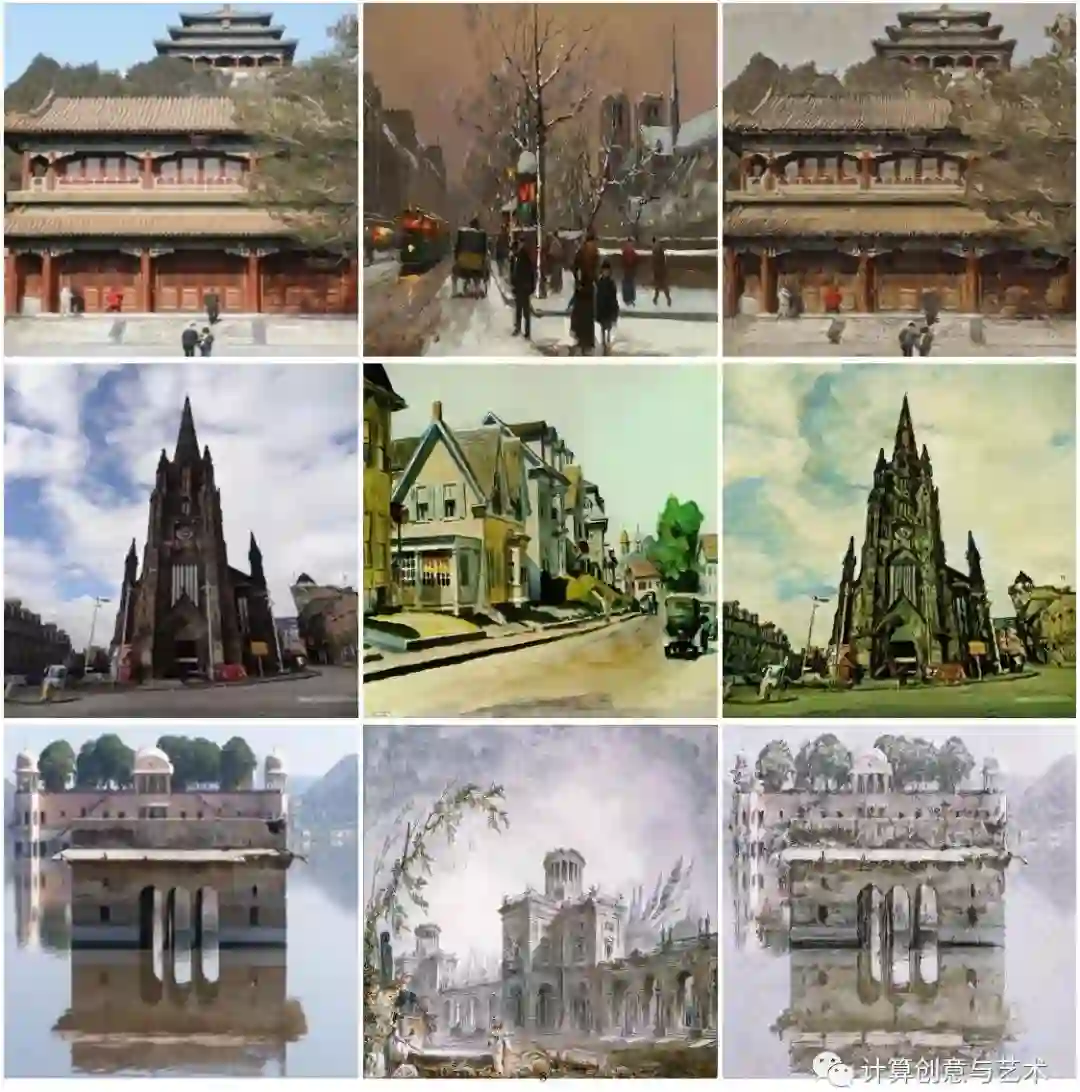

更多风格迁移结果如下。

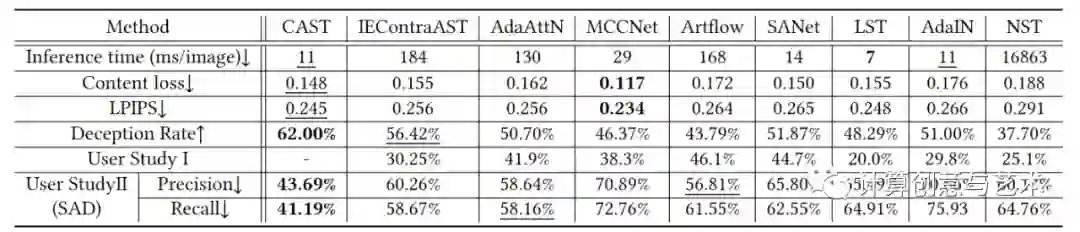

此外,我们与主流的任意图像风格化方法进行了系统的定量分析,并设计了两个用户参与的调查问卷。结果表明,CAST取得的结果在推理速度、内容及风格保持等方面均取得了很好的结果。特别的,用户调查问卷表明,CAST是目前唯一一个可以在真实/合成画作挑选任务中迷惑用户的方法。更多实验结果见论文原文。

04 主要贡献

- 我们提出了用于风格表征的MSP模块和用于基于编码器-转换器-解码器的任意风格迁移的新型CAST模型,而不使用二阶统计作为风格表示。

- 我们通过考虑风格正负示例之间的关系以及的全局分布来引入对比学习和领域增强,解决了现有风格迁移模型无法充分利用大量风格信息的问题。

- 实验表明,我们的方法在视觉质量上达到了最先进的风格迁移结果。此外,受“图灵测试”启发,我们进行了一项具有挑战性的主观调查,以表明CAST 可以输出以假乱真的艺术作品。

- 计算机辅助艺术作品生成是一项很艰难的任务,无论是对艺术或者对计算机辅助分析的感兴趣小伙伴,可以多多关注我们的文章,一起交流进步!

本工作发表于计算机图形学顶级会议SIGGRAPH 2022,由中科院自动化所、吉林大学、快手和台湾成功大学共同完成:****

Yuxin Zhang, Fan Tang, Weiming Dong, Haibin Huang, Chongyang Ma, Tong-Yee Lee, and Changsheng Xu: ****Domain Enhanced Arbitrary Image Style Transfer via Contrastive Learning