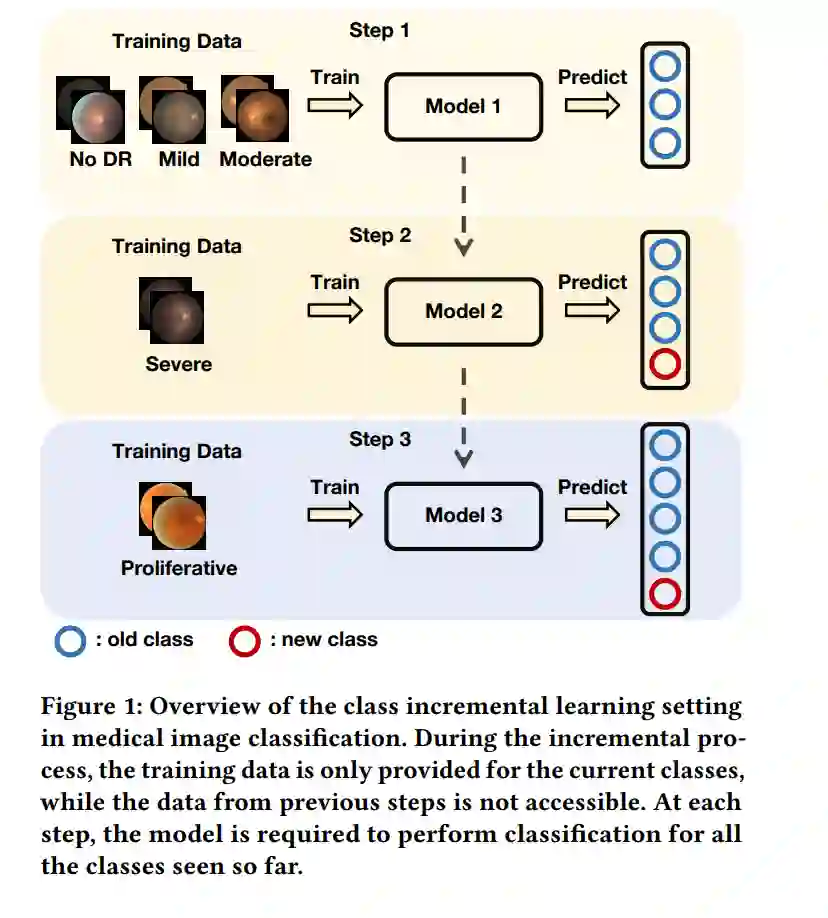

深度卷积神经网络在医疗图像分类中取得了显著突破,假设所有类别的训练样本可以同时获得。然而,在现实世界的医疗场景中,通常需要不断学习新的疾病,这催生了医疗领域中类增量学习(Class Incremental Learning,CIL)的新兴领域。通常,CIL在训练新类别时会遭遇灾难性遗忘。这种现象主要是由于新旧类别之间的不平衡引起的,在不平衡的医疗数据集中这一问题尤为严重。在这项工作中,我们引入了两个简单但有效的插件方法来减轻不平衡的负面影响。首先,我们提出了一种CIL平衡分类损失,通过对logit调整来减轻分类器对多数类别的偏见。其次,我们提出了一种分布边界损失,不仅缓解了嵌入空间中的类间重叠,还加强了类内紧凑性。我们在三个基准数据集(CCH5000,HAM10000,和EyePACS)上进行了广泛的实验,以评估我们方法的有效性。结果表明,我们的方法优于最新的状态-of-the-art方法。

成为VIP会员查看完整内容

相关内容

ACM 国际多媒体大会(英文名称:ACM Multimedia,简称:ACM MM)是多媒体领域的顶级国际会议,每年举办一次。

Arxiv

224+阅读 · 2023年4月7日

Arxiv

20+阅读 · 2023年3月21日