【图神经网络多模态检索】Multi-Modal Retrieval using Graph Neural Networks

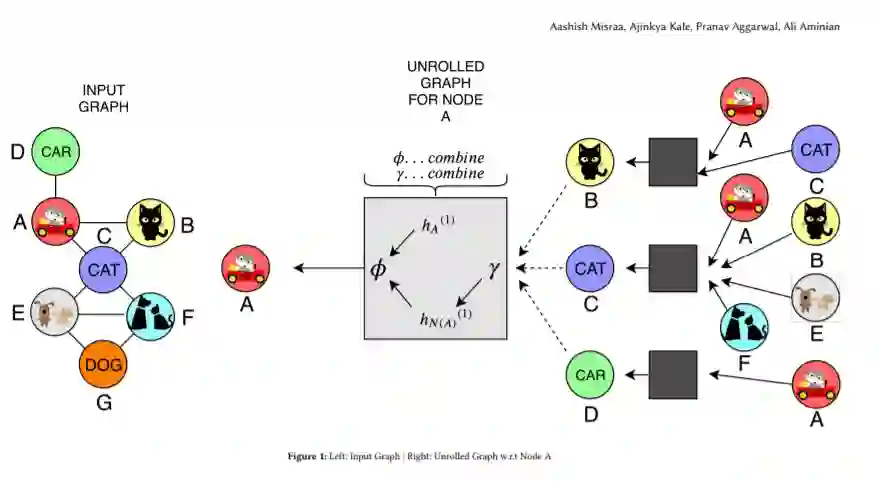

大多数真实世界的图像检索应用程序,如Adobe Stock,这是一个存储图片和插图的市场,需要一种方法让用户找到图像,这些图像在视觉上(即美学上)和概念上(即包含相同的突出对象)作为查询图像。从图像中学习视觉-语义表征是图像检索研究的一个热点问题。基于图像概念或属性的过滤通常通过基于索引的过滤(例如文本标签)或在最初的基于视觉嵌入的检索后重新排序来实现。在本文中,我们学习了一个嵌入在同一高维空间中的联合视觉和概念。这个联合模型为用户提供了对结果集语义的细粒度控制,允许他们更快速地浏览图像目录。我们将可视化和概念关系建模为图形结构,通过节点邻域捕获丰富的信息。这种图结构帮助我们使用图神经网络学习多模态节点嵌入。我们还引入了一种新的基于选择性邻域连接的推理时间控制,允许用户控制检索算法。我们对MS-COCO数据集图像检索下游相关任务进行定量评估,对MS-COCO和Adobe库存数据集进行定性评估。

https://arxiv.org/abs/2010.01666

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“MMRGNN” 可以获取《【图神经网络多模态检索】Multi-Modal Retrieval using Graph Neural Networks》专知下载链接索引

登录查看更多

相关内容

专知会员服务

137+阅读 · 2020年7月29日

专知会员服务

99+阅读 · 2020年7月3日

Arxiv

3+阅读 · 2018年2月13日