论文作者:高君宇,陈孟沅,相良玉,徐常胜 作者单位:中国科学院自动化研究所 论文链接:https://arxiv.org/abs/2409.04720 主页链接:github.com/MengyuanChen21/ Awesome-Evidential-Deep-Learning

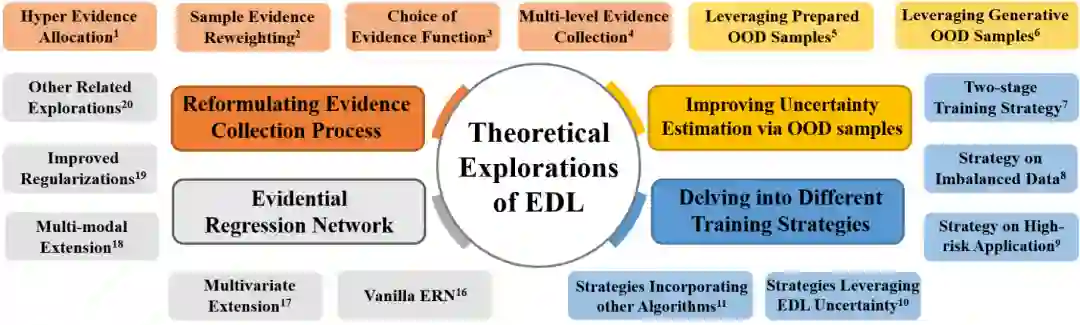

可靠的不确定性估计已成为深度学习算法在工业部署中的关键需求,尤其是在自动驾驶和医疗诊断等高风险应用中。然而,主流的不确定性估计方法,如基于深度集成或贝叶斯神经网络的方法,通常会带来大量的计算开销。为应对这一挑战,一种名为“证据深度学习”(EDL)的新范式应运而生,它在单次前向传播中提供可靠的不确定性估计,而无需额外的大量计算。本综述为读者提供了EDL当前研究的全面概述。**具体来说,我们首先介绍了EDL的理论基础——主观逻辑理论,并讨论了它与其他不确定性估计框架的区别。我们进一步从四个角度展现了EDL的理论进展:重新制定证据收集过程,提升不确定性估计方法,深入研究不同的训练策略,以及证据回归网络。**此后,我们详细说明了EDL在各种机器学习范式和下游任务中的广泛应用。最后,提供了EDL未来发展的展望,突出了潜在的研究方向。

在过去的十年中,深度学习为人工智能领域带来了革命性的变革[1, 2]。得益于有效的训练技术如 Dropout[3]和残差连接[4],以及卓越的网络架构如 Transformer[5],现代神经网络在机器学习的几乎所有应用中都取得了前所未有的成功[6, 7]。然而,随着现实世界应用范围的扩展,尤其是在自动驾驶[8]、医疗诊断[9]和军事应用[10]等高风险领域,对神经网络的安全性和可解释性的需求日益增长。因此,可靠的不确定性估计已成为深度学习中一个至关重要且热议的话题[1, 11-15]。

如图1所示,主流的不确定性量化方法,如深度集成[16-17]和贝叶斯神经网络[11, 18, 19],通常涉及多次前向传递或额外的参数,带来巨大的计算负担,阻碍了其在工业中的广泛应用。为了规避这一困境,新兴的单次前向传递不确定性估计范式得以发展,这种范式能够在最小化额外计算的情况下获得可靠的不确定性,即证据深度学习(EDL)[14]。EDL广泛地开发了主观逻辑理论[20, 21],这是著名的 Dempster-Shafer 证据理论[22, 23]在深度神经网络领域的一个高级变体。与传统的概率逻辑不同,主观逻辑将信念分配给可能的类别以代表真实命题,并显式包含不确定性质量来传达“我不知道”的含义。为了建模后验预测分布,构建了一个与主观意见一一对应的狄利克雷分布,包括上述的信念质量和不确定性质量。随着不确定性质量的增加,狄利克雷分布逐渐回归到一个预设的先验分布。利用主观逻辑的这些属性,EDL采用深度神经网络作为证据收集器,生成适当的信念质量和不确定性质量。然后通过最小化整合相应狄利克雷分布的传统损失函数来进行模型优化[14, 24, 25]。

本综述深入探讨了证据深度学习的最新发展,旨在无需先验知识的情况下全面介绍该领域。我们首先介绍EDL的理论,着重于主观逻辑理论的原则,并与其他不确定性估计框架进行对比。随后详细讨论了EDL的最新理论进展,这些进展分为四个关键领域:重新制定证据收集过程、通过OOD样本改进不确定性估计、探讨各种训练策略以及证据回归网络。

此外,我们阐述了EDL在不同机器学习范式和各种下游任务中的广泛适用性。综述以一种前瞻性的视角结束,旨在增强EDL的能力和促进其更广泛的应用,指出值得进一步研究的有希望的领域。

目前已有两篇关于证据学习的综述文章[26, 27]。与它们相比,我们工作的主要区别如下:(1) [26] 提供了一系列用于参数化狄利克雷先验的方法的广泛概述,而 [27] 关注于基于额外证据的贝叶斯更新过程中的证据推理和假设学习。与这两篇主要关注于被其他机器学习范式(例如,先验或后验分布,贝叶斯学习)广泛采用的公式化的综述不同,我们特别关注 EDL 方法本身及其最新的理论进展;(2) 我们深入探讨了 EDL 的内在理论基础、主观逻辑理论的几个关键概念,并进一步阐述了主观逻辑与其他不确定性推理框架之间的联系和差异。然而,[26] 缺乏对由主观逻辑理论指导的证据学习构建过程的关注;(3) 与这两篇综述相比,我们还额外全面地总结了 EDL 在各种机器学习范式和下游任务中的广泛应用。

本综述内容的组织方式如下:我们首先提供了深度学习中现有不确定性量化技术的概述,包括单一确定性方法、贝叶斯方法、集成方法和事后方法(第2节)。接下来,我们深入探讨了EDL的理论基础,特别是主观逻辑理论(第3.1节),并将其与其他不确定性推理框架进行比较(第3.2节)。然后我们关注标准EDL方法的机制(第4.1节),并探索围绕重新构建证据收集过程(第4.2节)、通过分布外(OOD)样本改进不确定性估计(第4.3节)、研究各种训练策略(第4.4节)和深度证据回归(第4.5节)的几个理论进展。此外,我们介绍了在机器学习中增强的EDL(第5.1节)以及EDL在下游应用中的应用(第5.2节)。如上图所示,在机器学习领域,EDL已经在弱监督学习、迁移学习、主动学习、多视角分类、多标签学习、强化学习、图神经网络上取得了一定进展。从下游任务的角度,EDL已广泛应用于计算机视觉、自然语言处理、跨模态学习、自动驾驶、开放世界任务、科学研究等领域。 最后,在第6节和第7节中,我们呈现了我们的结论并讨论了潜在的未来发展方向,包括:

**EDL的理论增强与分析 **主观逻辑理论是深度证据学习的基石。在主观意见(例如,二项式、多项式[14]和超几何[66])与狄利克雷分布之间的双射关系下,已开发了一系列EDL方法。随后,专注于改进主观逻辑理论将是EDL发展的可行路径。例如,探索主观逻辑与其他概率模型和推理框架(如模糊逻辑[63]和不精确狄利克雷模型[62])的融合方法。开发由主观逻辑指导的新运算符,如复数主观意见的融合[115],也是一个可行的途径。此外,EDL的理论保证是一个值得研究的方向。先前的工作已部分探索了使用PAC学习理论[37, 193]对EDL的泛化误差界限。此外,值得研究的还包括不确定性估计界限[26, 27]、对抗性示例的鲁棒性界限、模型训练的收敛和稳定性界限以及信息损失和压缩界限。最后,EDL的优化目标与流行损失函数(如交叉熵和MSE)[24]之间的基本区别是什么?进一步阐述这些优化目标的具体效果以及更全面的比较分析,如梯度分析和偏差-方差分析,仍将是有益的。该分析可以进一步阐释EDL的潜力,并为优化提供见解。

更有意义的证据收集 尽管“证据”一词是证据深度学习的核心,但现有方法常常忽视了神经网络收集的证据分数的物理意义。鉴于神经网络是难以解释的黑盒模型,获得的证据分数与主观逻辑所要求的显式信念之间存在认知差距。目前,一些工作[70, 99]已经超越了仅使用模型输出的逻辑值作为证据的做法,采用了更复杂的证据收集方法或探索了更广泛的证据来源,但这一领域仍有很大的潜力等待进一步探索。例如,整合额外的外部先验知识(如知识图谱和因果推理)或借鉴认知心理学的原则增强EDL范式。

更好的不确定性估计 当前,大多数现有的分类体系将不确定性分类为认知的或偶然的[194]。具体来说,认知不确定性(即模型不确定性)与学习模型直接相关,通常可以通过收集新数据或优化模型来减少。偶然不确定性(即数据不确定性)源于数据噪声,大多数情况下无法被降低。在EDL中,计算认知不确定性最简单的方法是将其与证据总量相关联。然而,这种方法在某种程度上是任意的,因为它既不源于主观逻辑的基本原则,也很少在实际应用中取得显著效果[24, 37]。对于偶然不确定性,尚无成熟的方法来描述这种固有的数据属性,唯一可行的方法是通过分析模型输出间接估计。我们承认,从模型输出中得到的偶然不确定性无可避免地会受到认知(模型)不确定性的影响,但如何获得“纯粹”的偶然不确定性仍是一个未解决的问题。未来,在EDL中如何根据主观逻辑理论的原则估计各种形式的不确定性是一个值得探索的方向。此外,尽管EDL只需要最小的额外计算开销,但它经常因性能较弱而受诟病,与主流不确定性估计算法相比较差。将EDL与现有的强大不确定性量化算法(如深度集成[16])融合,可能会显著推动该领域的发展。

使用EDL增强预训练基础模型 预训练的大型模型在各种任务中已展示出优异性能[195, 196]。根据scaling law[195],影响基础大模型性能的关键因素包括模型大小、数据量和计算能力。即使如此,我们也不能忽视通过改进优化目标来增强大型模型性能的潜力。实际上,EDL可以无缝集成到大型模型的优化过程中。例如,在自回归token预测中,整合EDL可以使模型考虑更高阶的概率分布和不确定性预测。到目前为止,可能由于研究团队相关的计算能力等限制,EDL的研究主要集中在小模型上,其应用于大模型的探索尚未展开,这一差距鼓励了进一步研究。此外,除了直接训练和微调大型模型外,利用EDL策略进行蒸馏[56]和大型模型的压缩也是可行的方向。最后,一个有价值的研究方向是探索EDL范式是否能在不增加计算开销或不牺牲性能的情况下,使大模型具备不确定性估计能力,尤其是在工业和高风险应用中。

更广泛的应用 如前节所述,EDL已在多个领域进行了探索,包括计算机视觉、自然语言处理、跨模态学习和科学研究。鉴于EDL在不确定性感知和效率方面的优势,进一步探索其在大规模实际应用中的价值是非常有意义的。例如,在具身智能中,据我们所知,目前的研究才刚刚开始[113]。此外,EDL在内容生成中也有发展潜力,如基于概率论的Diffusion模型[197],以提高生成质量。

论文作者:高君宇,陈孟沅,相良玉,徐常胜 作者单位:中国科学院自动化研究所 论文链接:https://arxiv.org/abs/2409.04720 主页链接:github.com/MengyuanChen21/ Awesome-Evidential-Deep-Learning

可靠的不确定性估计已成为深度学习算法在工业部署中的关键需求,尤其是在自动驾驶和医疗诊断等高风险应用中。然而,主流的不确定性估计方法,如基于深度集成或贝叶斯神经网络的方法,通常会带来大量的计算开销。为应对这一挑战,一种名为“证据深度学习”(EDL)的新范式应运而生,它在单次前向传播中提供可靠的不确定性估计,而无需额外的大量计算。本综述为读者提供了EDL当前研究的全面概述。具体来说,我们首先介绍了EDL的理论基础——主观逻辑理论,并讨论了它与其他不确定性估计框架的区别。我们进一步从四个角度展现了EDL的理论进展:重新制定证据收集过程,提升不确定性估计方法,深入研究不同的训练策略,以及证据回归网络。此后,我们详细说明了EDL在各种机器学习范式和下游任务中的广泛应用。最后,提供了EDL未来发展的展望,突出了潜在的研究方向。

在过去的十年中,深度学习为人工智能领域带来了革命性的变革[1, 2]。得益于有效的训练技术如 Dropout[3]和残差连接[4],以及卓越的网络架构如 Transformer[5],现代神经网络在机器学习的几乎所有应用中都取得了前所未有的成功[6, 7]。然而,随着现实世界应用范围的扩展,尤其是在自动驾驶[8]、医疗诊断[9]和军事应用[10]等高风险领域,对神经网络的安全性和可解释性的需求日益增长。因此,可靠的不确定性估计已成为深度学习中一个至关重要且热议的话题[1, 11-15]。

如图1所示,主流的不确定性量化方法,如深度集成[16-17]和贝叶斯神经网络[11, 18, 19],通常涉及多次前向传递或额外的参数,带来巨大的计算负担,阻碍了其在工业中的广泛应用。为了规避这一困境,新兴的单次前向传递不确定性估计范式得以发展,这种范式能够在最小化额外计算的情况下获得可靠的不确定性,即证据深度学习(EDL)[14]。EDL广泛地开发了主观逻辑理论[20, 21],这是著名的 Dempster-Shafer 证据理论[22, 23]在深度神经网络领域的一个高级变体。与传统的概率逻辑不同,主观逻辑将信念分配给可能的类别以代表真实命题,并显式包含不确定性质量来传达“我不知道”的含义。为了建模后验预测分布,构建了一个与主观意见一一对应的狄利克雷分布,包括上述的信念质量和不确定性质量。随着不确定性质量的增加,狄利克雷分布逐渐回归到一个预设的先验分布。利用主观逻辑的这些属性,EDL采用深度神经网络作为证据收集器,生成适当的信念质量和不确定性质量。然后通过最小化整合相应狄利克雷分布的传统损失函数来进行模型优化[14, 24, 25]。

本综述深入探讨了证据深度学习的最新发展,旨在无需先验知识的情况下全面介绍该领域。我们首先介绍EDL的理论,着重于主观逻辑理论的原则,并与其他不确定性估计框架进行对比。随后详细讨论了EDL的最新理论进展,这些进展分为四个关键领域:重新制定证据收集过程、通过OOD样本改进不确定性估计、探讨各种训练策略以及证据回归网络。

此外,我们阐述了EDL在不同机器学习范式和各种下游任务中的广泛适用性。综述以一种前瞻性的视角结束,旨在增强EDL的能力和促进其更广泛的应用,指出值得进一步研究的有希望的领域。

目前已有两篇关于证据学习的综述文章[26, 27]。与它们相比,我们工作的主要区别如下:(1) [26] 提供了一系列用于参数化狄利克雷先验的方法的广泛概述,而 [27] 关注于基于额外证据的贝叶斯更新过程中的证据推理和假设学习。与这两篇主要关注于被其他机器学习范式(例如,先验或后验分布,贝叶斯学习)广泛采用的公式化的综述不同,我们特别关注 EDL 方法本身及其最新的理论进展;(2) 我们深入探讨了 EDL 的内在理论基础、主观逻辑理论的几个关键概念,并进一步阐述了主观逻辑与其他不确定性推理框架之间的联系和差异。然而,[26] 缺乏对由主观逻辑理论指导的证据学习构建过程的关注;(3) 与这两篇综述相比,我们还额外全面地总结了 EDL 在各种机器学习范式和下游任务中的广泛应用。

本综述内容的组织方式如下:我们首先提供了深度学习中现有不确定性量化技术的概述,包括单一确定性方法、贝叶斯方法、集成方法和事后方法(第2节)。接下来,我们深入探讨了EDL的理论基础,特别是主观逻辑理论(第3.1节),并将其与其他不确定性推理框架进行比较(第3.2节)。然后我们关注标准EDL方法的机制(第4.1节),并探索围绕重新构建证据收集过程(第4.2节)、通过分布外(OOD)样本改进不确定性估计(第4.3节)、研究各种训练策略(第4.4节)和深度证据回归(第4.5节)的几个理论进展。此外,我们介绍了在机器学习中增强的EDL(第5.1节)以及EDL在下游应用中的应用(第5.2节)。如上图所示,在机器学习领域,EDL已经在弱监督学习、迁移学习、主动学习、多视角分类、多标签学习、强化学习、图神经网络上取得了一定进展。从下游任务的角度,EDL已广泛应用于计算机视觉、自然语言处理、跨模态学习、自动驾驶、开放世界任务、科学研究等领域。 最后,在第6节和第7节中,我们呈现了我们的结论并讨论了潜在的未来发展方向,包括:

EDL的理论增强与分析 主观逻辑理论是深度证据学习的基石。在主观意见(例如,二项式、多项式[14]和超几何[66])与狄利克雷分布之间的双射关系下,已开发了一系列EDL方法。随后,专注于改进主观逻辑理论将是EDL发展的可行路径。例如,探索主观逻辑与其他概率模型和推理框架(如模糊逻辑[63]和不精确狄利克雷模型[62])的融合方法。开发由主观逻辑指导的新运算符,如复数主观意见的融合[115],也是一个可行的途径。此外,EDL的理论保证是一个值得研究的方向。先前的工作已部分探索了使用PAC学习理论[37, 193]对EDL的泛化误差界限。此外,值得研究的还包括不确定性估计界限[26, 27]、对抗性示例的鲁棒性界限、模型训练的收敛和稳定性界限以及信息损失和压缩界限。最后,EDL的优化目标与流行损失函数(如交叉熵和MSE)[24]之间的基本区别是什么?进一步阐述这些优化目标的具体效果以及更全面的比较分析,如梯度分析和偏差-方差分析,仍将是有益的。该分析可以进一步阐释EDL的潜力,并为优化提供见解。

更有意义的证据收集 尽管“证据”一词是证据深度学习的核心,但现有方法常常忽视了神经网络收集的证据分数的物理意义。鉴于神经网络是难以解释的黑盒模型,获得的证据分数与主观逻辑所要求的显式信念之间存在认知差距。目前,一些工作[70, 99]已经超越了仅使用模型输出的逻辑值作为证据的做法,采用了更复杂的证据收集方法或探索了更广泛的证据来源,但这一领域仍有很大的潜力等待进一步探索。例如,整合额外的外部先验知识(如知识图谱和因果推理)或借鉴认知心理学的原则增强EDL范式。

更好的不确定性估计 当前,大多数现有的分类体系将不确定性分类为认知的或偶然的[194]。具体来说,认知不确定性(即模型不确定性)与学习模型直接相关,通常可以通过收集新数据或优化模型来减少。偶然不确定性(即数据不确定性)源于数据噪声,大多数情况下无法被降低。在EDL中,计算认知不确定性最简单的方法是将其与证据总量相关联。然而,这种方法在某种程度上是任意的,因为它既不源于主观逻辑的基本原则,也很少在实际应用中取得显著效果[24, 37]。对于偶然不确定性,尚无成熟的方法来描述这种固有的数据属性,唯一可行的方法是通过分析模型输出间接估计。我们承认,从模型输出中得到的偶然不确定性无可避免地会受到认知(模型)不确定性的影响,但如何获得“纯粹”的偶然不确定性仍是一个未解决的问题。未来,在EDL中如何根据主观逻辑理论的原则估计各种形式的不确定性是一个值得探索的方向。此外,尽管EDL只需要最小的额外计算开销,但它经常因性能较弱而受诟病,与主流不确定性估计算法相比较差。将EDL与现有的强大不确定性量化算法(如深度集成[16])融合,可能会显著推动该领域的发展。

使用EDL增强预训练基础模型 预训练的大型模型在各种任务中已展示出优异性能[195, 196]。根据scaling law[195],影响基础大模型性能的关键因素包括模型大小、数据量和计算能力。即使如此,我们也不能忽视通过改进优化目标来增强大型模型性能的潜力。实际上,EDL可以无缝集成到大型模型的优化过程中。例如,在自回归token预测中,整合EDL可以使模型考虑更高阶的概率分布和不确定性预测。到目前为止,可能由于研究团队相关的计算能力等限制,EDL的研究主要集中在小模型上,其应用于大模型的探索尚未展开,这一差距鼓励了进一步研究。此外,除了直接训练和微调大型模型外,利用EDL策略进行蒸馏[56]和大型模型的压缩也是可行的方向。最后,一个有价值的研究方向是探索EDL范式是否能在不增加计算开销或不牺牲性能的情况下,使大模型具备不确定性估计能力,尤其是在工业和高风险应用中。

更广泛的应用 如前节所述,EDL已在多个领域进行了探索,包括计算机视觉、自然语言处理、跨模态学习和科学研究。鉴于EDL在不确定性感知和效率方面的优势,进一步探索其在大规模实际应用中的价值是非常有意义的。例如,在具身智能中,据我们所知,目前的研究才刚刚开始[113]。此外,EDL在内容生成中也有发展潜力,如基于概率论的Diffusion模型[197],以提高生成质量。