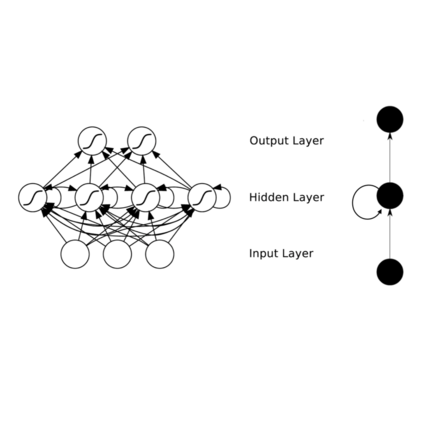

摘要:在这次演讲中,我将带领听众回顾我在建立神经序列模型方面的早期和近期经历。我从早期使用循环网络进行seq2seq学习的经验出发,讨论了注意机制。我讨论了这些早期方法成功背后的因素,以及这些方法是如何被社区所接受的,甚至是在它们还没有成型之前。然后,我会转向讲非常规神经序列模型的最新研究方向以及该模型可以自动学习确定生成的顺序。

报告人简介:Kyunghyun Cho是纽约大学计算机科学和数据科学副教授,也是Facebook人工智能研究中心的研究科学家。在2015年夏之前,他一直是蒙特利尔大学的博士后研究员,在yobengio教授的指导下,并于2014年初在Juha Karhunen教授、Tapani Raiko博士和Alexander Ilin博士的指导下获得了阿尔托大学的博士和硕士学位。

成为VIP会员查看完整内容

相关内容

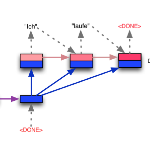

Attention机制最早是在视觉图像领域提出来的,但是真正火起来应该算是google mind团队的这篇论文《Recurrent Models of Visual Attention》[14],他们在RNN模型上使用了attention机制来进行图像分类。随后,Bahdanau等人在论文《Neural Machine Translation by Jointly Learning to Align and Translate》 [1]中,使用类似attention的机制在机器翻译任务上将翻译和对齐同时进行,他们的工作算是是第一个提出attention机制应用到NLP领域中。接着类似的基于attention机制的RNN模型扩展开始应用到各种NLP任务中。最近,如何在CNN中使用attention机制也成为了大家的研究热点。下图表示了attention研究进展的大概趋势。

专知会员服务

26+阅读 · 2019年11月7日