作者:张文、朱渝珊、陈名杨、陈华钧

1. 引言

知识是人类社会发展沉淀下来的精华,其表示形式多种多样,知识可以被表示于文本、图片、视频、音频等众多形态中,随着这两年预训练语言模型以及大语言模型的成功,大语言模型的知识表示和推理能力被广泛关注和讨论,其中被讨论较多的是以语言(即文本序列)形式表示的知识,也就是我们常说的非结构化知识,近期,结构化知识如代码、表格、图等在大语言模型中的处理与应用逐渐受到关注和讨论,本文将探讨面向结构化知识的预训练语言大模型前沿趋势,主要尝试探索以下两个问题: 1)对比其他形式的知识如文本序列等,结构化知识的核心特色是什么?结构化知识应该如何被有效地学习?2)目前广受关注的大语言模型作为基于序列数据训练而得的模型,在利用结构化知识方面表现如何?本文将以知识图谱为例,对这两个问题展开讨论。针对第一个问题,本文将以我们在WWW2023上发表的论文KGTransformer为例进行介绍,说明结构知识的核心特色在于广泛存在于结构表示中的可迁移的模式。针对第二个问题,本文将介绍我们用GPT-3.5对知识图谱数据进行推理的初步验证,说明大语言模型在结构数据学习方面尚有欠缺。

2. KGTransformer-知识结构预训练与提示调优(WWW2023)

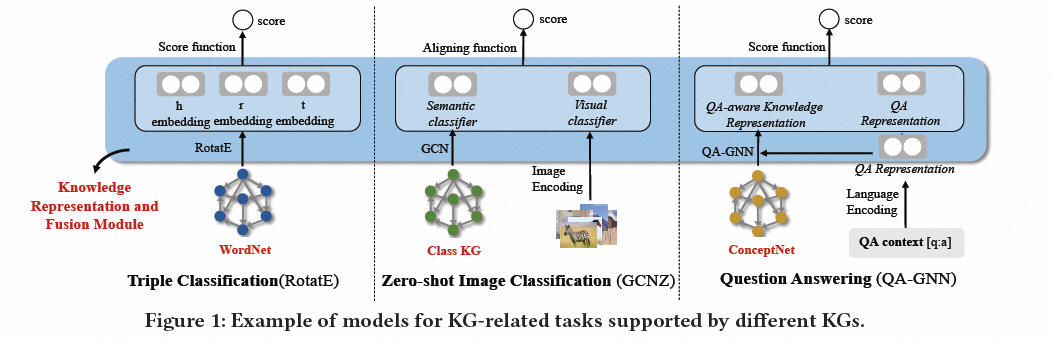

为了解决这个问题,预训练的KG模型被提出来学习实体和关系的通用嵌入表示,可以应用于许多任务。这些嵌入被认为包含实体相似性、层次结构和关系等信息,可用于推荐系统、实体对齐、问答等任务,有助于隐式访问知识图谱中的知识。然而,这种方式面临两个挑战:(1)第一个挑战是,如果任务知识图谱与预训练知识图谱包含不同的实体和关系,则基于嵌入的方法由于嵌入缺失而无法将有价值的信息传递给下游任务模型。(2)第二个挑战是知识图谱和任务数据之间缺少基本的交互和融合,使得融合模块的设计成为下游任务模型设计的一部分。因此,基于嵌入的知识图谱模型并不是KRF模块跨知识图谱相关任务的理想解决方案。KGTransformer通过对KG结构进行预训练,并将与特定实体和关系无关的参数转换到下游任务来解决第一个挑战。本文通过提示调优机制解决第二个挑战,以实现KGs和任务数据之间的统一和灵活融合。

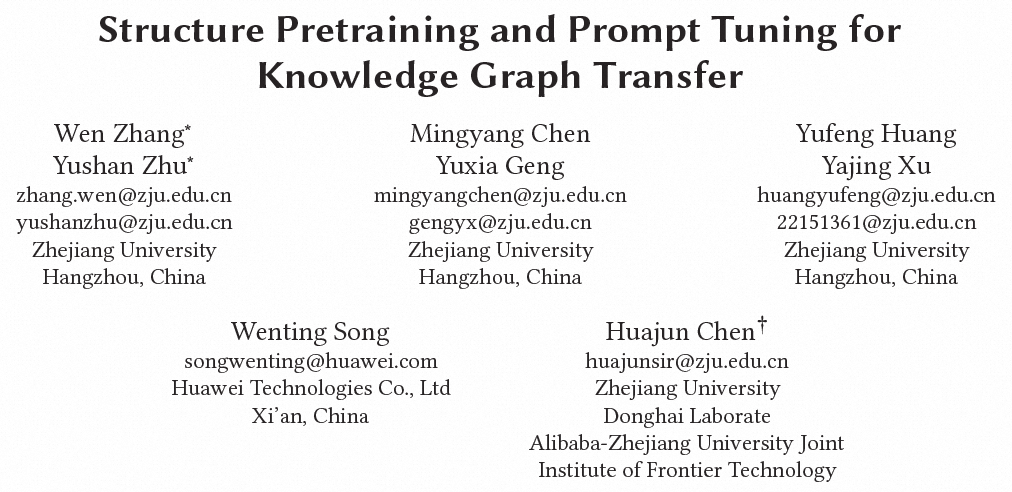

2.2 方法KGTransformer由多个KGTransformer层组成。该模型以采样的子图的三元组序列作为输入。在KGTransformer层中,根据三元组元素之间的邻接矩阵,允许序列中不同元素进行有限的交互,即具有相同元素(实体或关系)的三元组,在Transformer结构中是可见的。在训练阶段,本文提出一种具有三个自监督任务的子图预训练方法,即掩码实体建模、掩码关系建模和实体对建模。

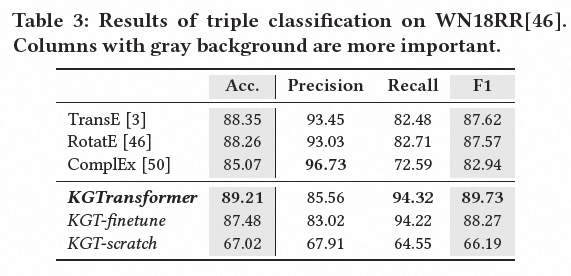

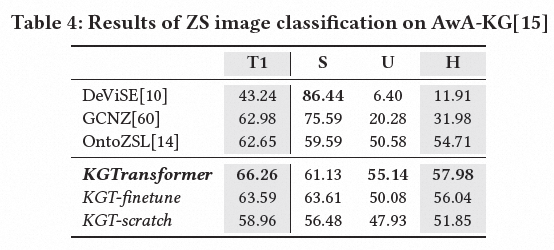

2.3 实验验证我们在由wn18rr, fb15k-237,codex组成的WFC数据集上对KGTransformer层进行了预训练,并将其应用于三种任务中,包括三元组分类、零样本图片分类、问答,每种任务所使用的任务图谱均不一样。下面为三种任务的实验效果实验1:三元组分类实验效果

3. 总结和展望:结构化知识大模型本文以知识图谱为例,说明了在结构化数据中广泛存在着可迁移的模式,而LLM挖掘结构化数据模式的能力尚有欠缺,其性能显著弱于传统的知识图谱嵌入模型。LLM基于结构化数据进行推理的难点有以下几个:(1)缺乏结构数据全局视野,受限于输入的长度,LLM无法感知全局的结构数据;(2)难以捕捉结构复杂关联,结构数据的依赖和关联关系复杂,相距较远的节点之间可能有巨大的影响,一个节点可能受到多个多阶邻居的综合影响;(3)受到线性输入输出制约,结构数据的推理具有显著的非线性性,具有一定的层次性和组合性,LLM线性的序列输入输出难以捕捉这类信息。因此,我们认为有必要研究结构化知识大模型,通过结构化知识指令等方式提升LLM的结构知识感知能力,通过结合外部工具捕捉结构知识的复杂关联,借助联合微调增强LLM的非线性思考能力等。最终实现可以理解多种知识表示方式并具有基于多种知识表示方法进行推理的大模型。