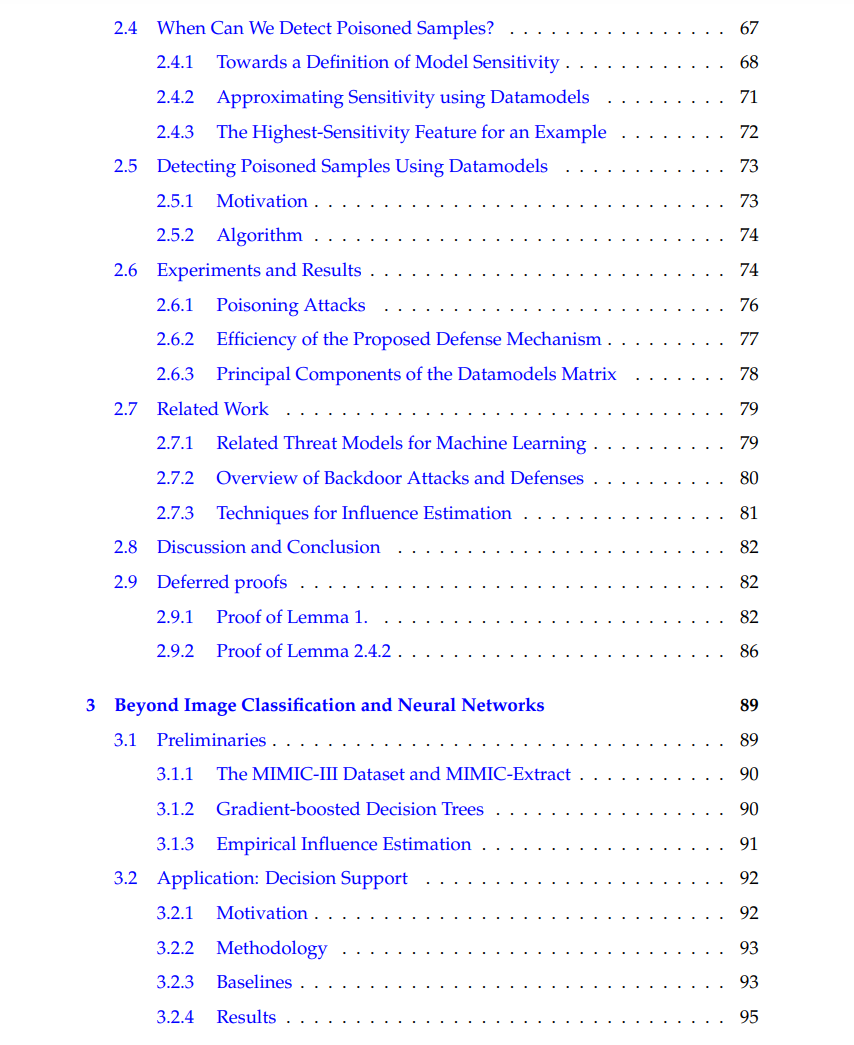

在过去的十年中,机器学习在许多具有挑战性的基准上取得了惊人的成功。然而,我们的机器学习模型是否准备好离开这个实验室环境,并安全地部署在高风险的现实世界应用程序中?本文通过开发和应用新的框架,使现代机器学习系统更鲁棒,从而采取措施使这一愿景成为现实。特别是,我们在这类系统的两种主要脆弱性模式:对抗性示例和后门数据中毒攻击方面取得了进展。具体来说,在本文的第一部分中,构建了一种对抗样本的防御方法,这是第一个在自适应对手面前提供非平凡的对抗鲁棒性的方法。在第二部分中,开发了一个后门数据投毒攻击框架,并展示了在自然假设下,我们的理论结果如何激励算法标记和删除经验上成功的潜在投毒示例。最后,简要探索了初步证据,表明该框架也可以应用于其他数据模态,如表格数据,以及其他机器学习模型,如决策树的集成。近年来,机器学习,特别是深度学习,在具有挑战性的人工智能基准上取得了巨大的进步,从计算机视觉[KSH12]到玩游戏[SHS+18],从自然语言处理[BMR+20]到机器人[ABC+20],再到自动驾驶汽车,都取得了令人印象深刻的结果。这些成功给我们带来了希望,在未来,普适的ML系统将乏味的体力和脑力任务自动化,甚至增强和改善我们的健康、智能和社会。然而,这些令人印象深刻的研究成果和演示是否准备在一个混乱、异构、有时是对抗的世界中转化为同样令人印象深刻和有影响力的应用?虽然我们最先进的机器学习模型普遍在各个领域和模态中取得了伟大的结果,但它们在训练数据中同样普遍地易受变化的影响——无论是良性的还是对抗的。这篇论文是关于开发原则性的方法来防御特定类型的这种脆弱性。在以下部分中,我们给出了论文的路线图和我们的主要贡献。

成为VIP会员查看完整内容

相关内容

麻省理工学院(Massachusetts Institute of Technology,MIT)是美国一所研究型私立大学,位于马萨诸塞州(麻省)的剑桥市。麻省理工学院的自然及工程科学在世界上享有极佳的盛誉,该校的工程系曾连续七届获得美国工科研究生课程冠军,其中以电子工程专业名气最响,紧跟其后的是机械工程。其管理学、经济学、哲学、政治学、语言学也同样优秀。

Arxiv

0+阅读 · 2023年5月19日

Arxiv

0+阅读 · 2023年5月17日

Arxiv

20+阅读 · 2023年3月21日

Arxiv

18+阅读 · 2019年9月25日