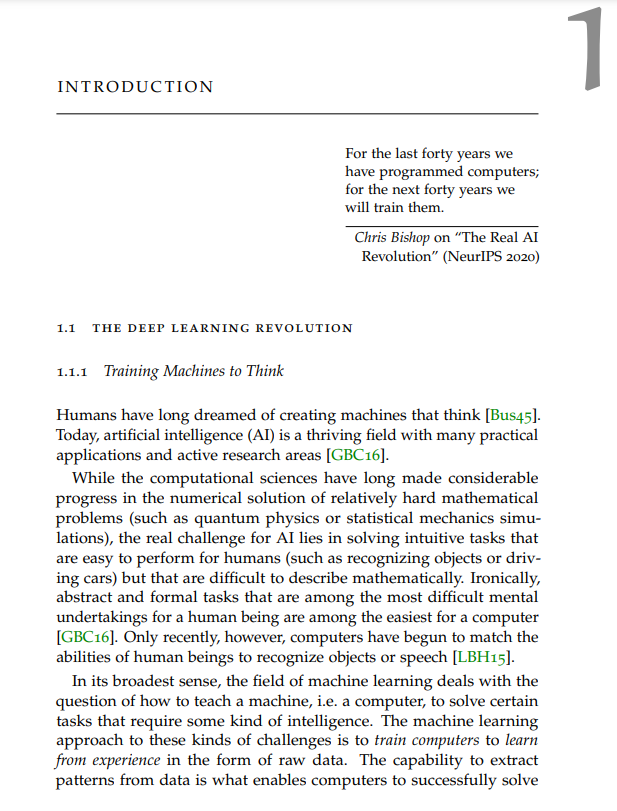

![]() 深度学习经历了巨大的增长,这主要得益于更强大的计算机、更大数据集的可用性和软件基础设施的进步,而深度神经网络在机器学习中考虑的几乎每一项任务中都设置了新的最先进的技术。深度神经网络在经验上的成功是无可争议的,但我们对这些模型为什么有效(当它们有效时)的理解仍然有很大的差距,而且它们可能以令人惊讶的方式失败(当被篡改时)。本文研究了为什么强大的深度神经网络有时会失败,以及可以做什么来防止这种情况。虽然深度神经网络对随机噪声具有很强的鲁棒性,但已有研究表明,在面对所谓的对抗性例子时,它们的准确性会急剧下降,即输入信号的专门设计的小扰动,通常是人类无法察觉的,足以导致模型输出的大变化。这种明显的脆弱性令人担忧,因为深度神经网络开始在现实世界中激增,包括在安全关键部署中。最直接和流行的鲁棒化策略称为对抗训练,它在训练过程中使用对抗例子作为数据增强。本文在深度神经网络的对抗性训练和算子范数正则化之间建立了理论联系。证明了ℓp -范数约束的投影梯度上升对抗性训练,在干净和扰动输入的logits上具有ℓq -范数损失,与数据依赖(p, q)算子范数正则化等价。这种基本联系证实了长期存在的论点,即网络对对抗性样本的敏感性与其谱特性有关,并暗示了增强和抵御对抗性攻击的新方法。我们还提出了一种利用对抗性攻击引入的某些异常的检测方法。具体来说,我们提出了一种测量特征表示和对数概率在噪声下如何变化的方法:如果输入是对位摄动的,噪声诱导的特征变化倾向于有一个特征方向,而如果输入是自然的,它倾向于没有任何特定的方向。我们评估了针对强迭代攻击的方法,并表明即使对手意识到防御也无法躲过我们的检测器。

深度学习经历了巨大的增长,这主要得益于更强大的计算机、更大数据集的可用性和软件基础设施的进步,而深度神经网络在机器学习中考虑的几乎每一项任务中都设置了新的最先进的技术。深度神经网络在经验上的成功是无可争议的,但我们对这些模型为什么有效(当它们有效时)的理解仍然有很大的差距,而且它们可能以令人惊讶的方式失败(当被篡改时)。本文研究了为什么强大的深度神经网络有时会失败,以及可以做什么来防止这种情况。虽然深度神经网络对随机噪声具有很强的鲁棒性,但已有研究表明,在面对所谓的对抗性例子时,它们的准确性会急剧下降,即输入信号的专门设计的小扰动,通常是人类无法察觉的,足以导致模型输出的大变化。这种明显的脆弱性令人担忧,因为深度神经网络开始在现实世界中激增,包括在安全关键部署中。最直接和流行的鲁棒化策略称为对抗训练,它在训练过程中使用对抗例子作为数据增强。本文在深度神经网络的对抗性训练和算子范数正则化之间建立了理论联系。证明了ℓp -范数约束的投影梯度上升对抗性训练,在干净和扰动输入的logits上具有ℓq -范数损失,与数据依赖(p, q)算子范数正则化等价。这种基本联系证实了长期存在的论点,即网络对对抗性样本的敏感性与其谱特性有关,并暗示了增强和抵御对抗性攻击的新方法。我们还提出了一种利用对抗性攻击引入的某些异常的检测方法。具体来说,我们提出了一种测量特征表示和对数概率在噪声下如何变化的方法:如果输入是对位摄动的,噪声诱导的特征变化倾向于有一个特征方向,而如果输入是自然的,它倾向于没有任何特定的方向。我们评估了针对强迭代攻击的方法,并表明即使对手意识到防御也无法躲过我们的检测器。

量化对抗脆弱性的首选策略是针对特定的攻击算法评估模型。然而,这种方法本身就有局限性,因为它很少提及模型对不包括在评估中的更强大攻击的鲁棒性。我们开发了一个统一的数学框架来描述基于松弛的鲁棒性认证方法,它超越了对手特定的鲁棒性评估,而是提供了可证明的鲁棒性保证,以抵御任何对手的攻击。

我们还提出一种新的正则化方法来稳定生成对抗网络(GANs)的训练。我们证明了使用噪声或卷积密度的训练等价于基于梯度的鉴别器正则化,这产生了一个更平滑的鉴别器家族,而不必显式地添加噪声。由此产生的正则化器是一种简单而有效的GAN目标修改,计算成本低,产生稳定的GAN训练过程。 我们还研究了贝叶斯神经网络(BNN),它学习模型参数的分布,或者等效地对可能模型的集合进行抽样,而不是优化单个网络。尽管贝叶斯神经网络有望获得更好的泛化性能(无过拟合)和原则性的不确定性量化(稳健预测),但是,贝叶斯神经网络的使用仍然受到限制。

我们通过仔细的MCMC抽样证明,与SGD获得的点估计等更简单的方法相比,贝叶斯后验预测诱导的后验预测系统地产生了更糟糕的预测。另一方面,我们证明了贝叶斯预测性能可以通过使用夸大证据的“冷后验”显著提高。这种冷后验严重偏离贝叶斯范式,但通常被用作贝叶斯深度学习中的启发式。我们的研究结果对目前对贝叶斯深度学习的理解提出了质疑,并表明现在是时候关注理解冷后视表现改善的起源了。 ![]()

![]()

![]()