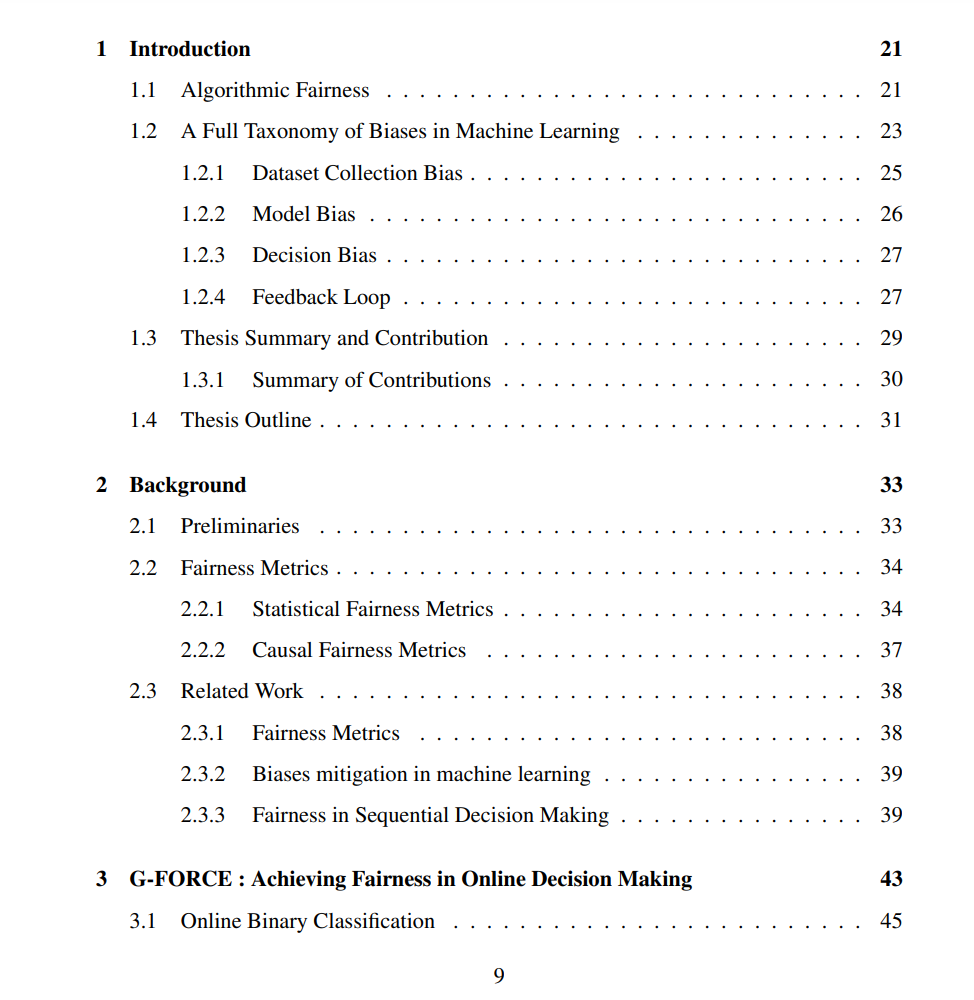

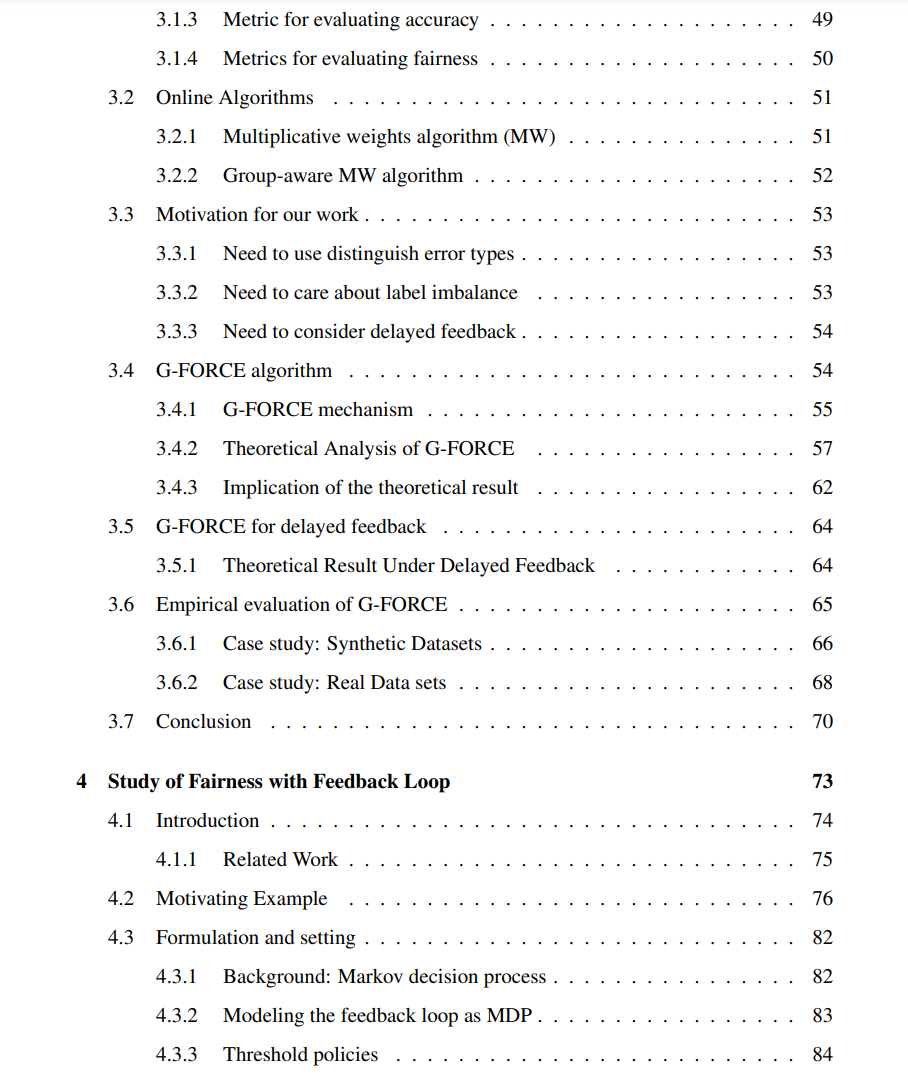

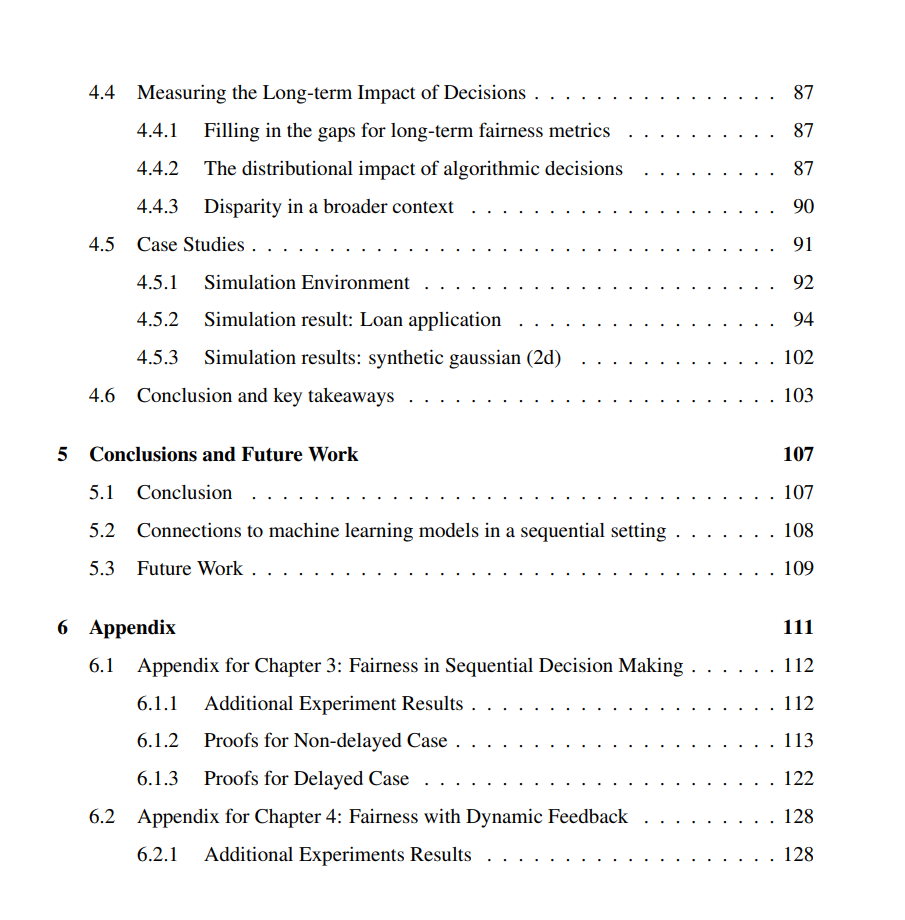

机器学习算法已被广泛应用于多种领域,人们对这些算法可能存在的偏见越来越关注。虽然已有许多解决算法预测偏见的方案,但在将预测转化为合理决策的过程中仍存在空白。此外,即使一个公正且公平的决策也可能在决策产生反馈效应时导致不可预期的后果。尽管已经有许多方案提出实现一次性决策的公平性,但在研究连续算法决策的长期效果方面仍有空白。在这篇论文中,我们专注于在连续决策环境中研究算法的公平性。我们首先研究如何将模型预测转化为公平的决策。具体而言,给定黑箱模型(机器学习模型或人类专家)的预测,我们基于经典的学习自专家方案提出了一个算法,将预测结合起来生成公平且准确的决策。我们的理论结果表明,可以在不牺牲太多遗憾的情况下实现近似等化的机会。我们还展示了这个算法在公平社区常用的真实数据集上的表现。

在论文的第二部分,我们研究在连续设定中强制执行静态公平决策是否能在反馈循环下导致弱势群体的长期平等和改善。特别地,我们使用具有一般过渡函数的马尔可夫决策模型来模拟算法决策和基本分布之间的互动。我们提出了一个新的度量标准,通过衡量分布的中心、扩散和形状的变化来衡量算法决策的分布影响。这个度量将影响划分为群体内影响和群体间影响,其中群体内影响度量政策如何影响组内分布,群体间影响则度量政策如何对两个人口群体的分布产生不同的影响。我们的结果显示,阈值策略的效用和群体间影响之间通常存在权衡,常见的公平约束可能会导致“反作用效应”,即对各群体的影响可能存在差异。

成为VIP会员查看完整内容

相关内容

麻省理工学院(Massachusetts Institute of Technology,MIT)是美国一所研究型私立大学,位于马萨诸塞州(麻省)的剑桥市。麻省理工学院的自然及工程科学在世界上享有极佳的盛誉,该校的工程系曾连续七届获得美国工科研究生课程冠军,其中以电子工程专业名气最响,紧跟其后的是机械工程。其管理学、经济学、哲学、政治学、语言学也同样优秀。