![]()

虽然深度神经网络(DNNs)已经成功地部署在各种真实的应用场景中,但最近的研究表明,DNNs非常容易受到对抗性攻击。通过在良性输入中引入视觉上难以察觉的扰动,攻击者可以操纵DNN模型来提供错误的预测。对于正在将DNN应用于现实问题的从业者来说,了解不同类型攻击的特征,不仅可以帮助他们提高模型的鲁棒性,还可以帮助他们对DNN的工作机制有更深入的了解。在本教程中,我们将全面概述对抗性学习的最新进展,包括攻击方法和防御方法。具体来说,我们首先详细介绍了各种类型的规避攻击,然后介绍了一系列具有代表性的规避攻击的防御方法。然后我们讨论了不同的中毒攻击方法,然后介绍了几种针对中毒攻击的防御方法。此外,除了介绍在数字环境中工作的攻击方法外,我们还介绍了针对威胁物理世界系统而设计的攻击方法。最后,我们提出了一个PyTorch对抗性学习库DeepRobust,旨在建立一个全面的、易于使用的平台来培养这个研究领域。通过我们的教程,观众可以掌握对抗性攻击和防御的主要思想,并对DNN的鲁棒性有深入的了解。

本教程由六个主要部分组成,包括(1)介绍,(2)规避攻击和防御,(3)投毒攻击和防御,(4)物理世界中的对抗性攻击,(5)DeepRobust:一个用于对抗性学习的简单PyTorch存储库(6)总结和未来方向。接下来,我们将描述每个组件的细节

。

首先,我们简要介绍了什么是对抗性攻击现象,以及为什么它可以成为DNN应用的一个巨大关注

。我们展示在各种真实应用场景中出现的对抗性攻击的几个案例。这些场景包括自动驾驶汽车、欺诈者检测、对话系统和版权检测。这些插图可以强调对抗性攻防相关主题的重要性,并引起观众的广泛兴趣。此外,我们还介绍了对抗性学习的主要组成部分的必要概念,包括逃避/中毒攻击、白盒/黑盒攻击、有目标/无目标攻击。

规避攻击与防御

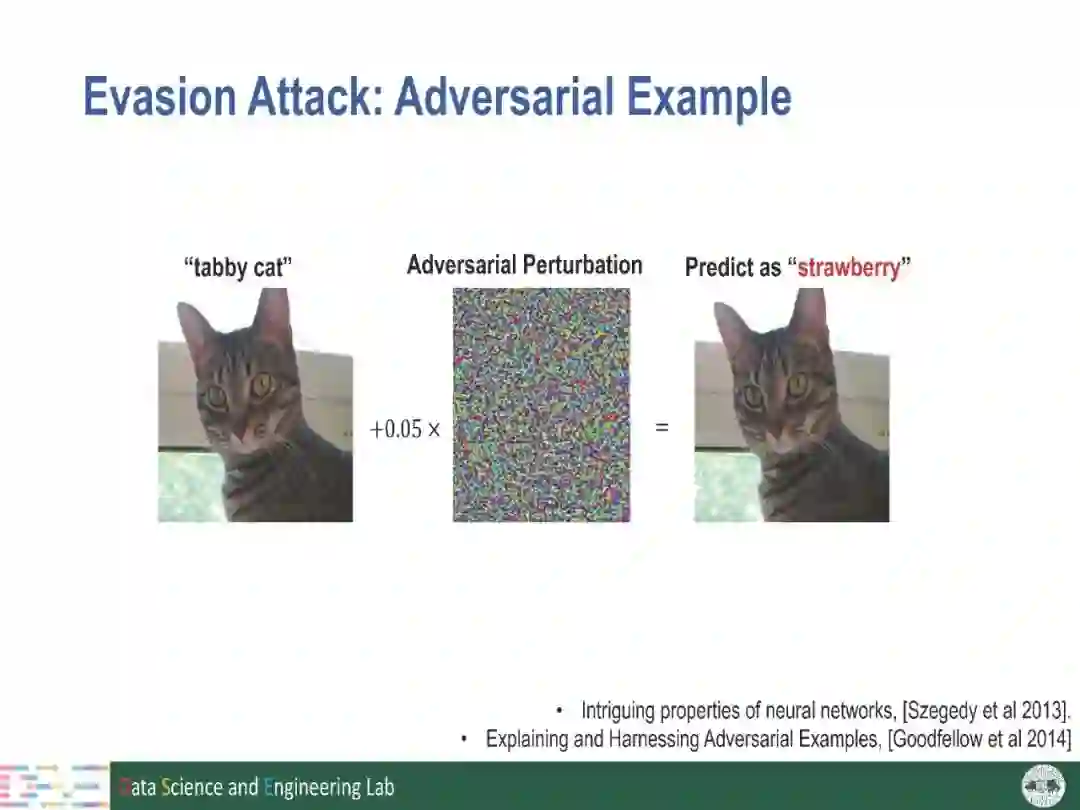

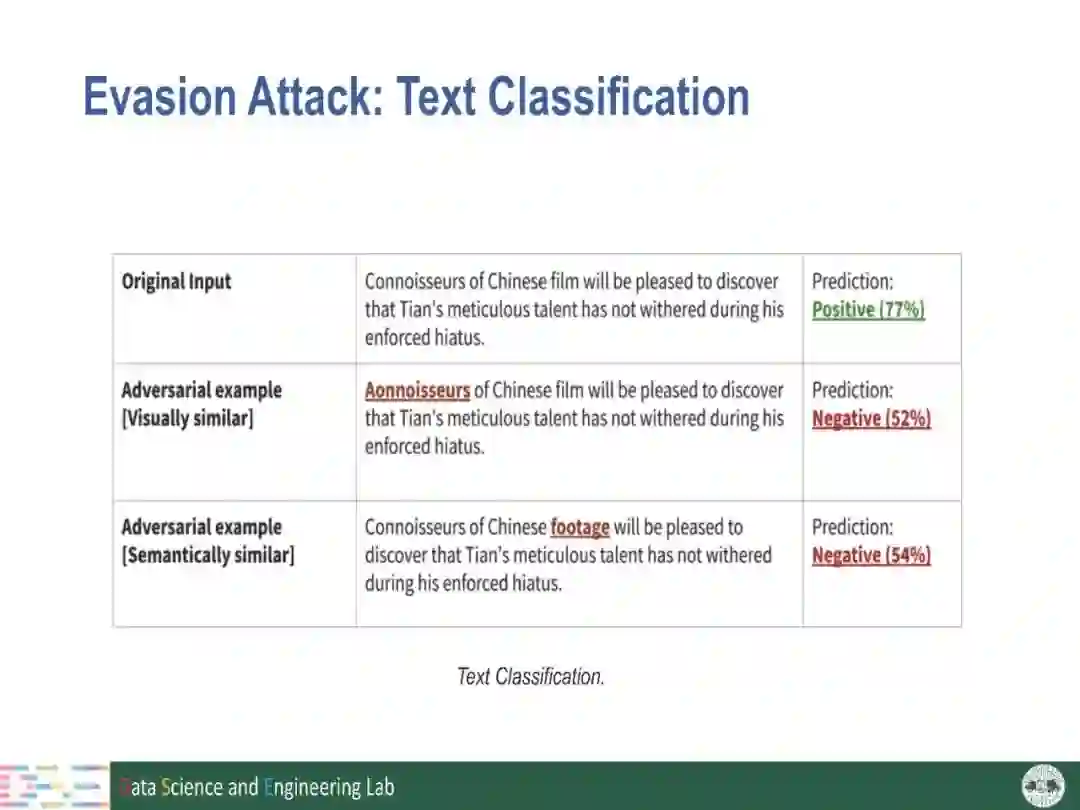

在本节中,我们将重点介绍模型推断阶段发生的攻击方法,即规避攻击,以及相应的对策。具体来说,我们首先总结了几种具有代表性的白盒/黑盒攻击设置的规避攻击方法,如FGSM[3]、CW[1]和ZOO[2]。然后,我们将现有的针对规避攻击的防御方法分为四组,即(1)梯度掩蔽/混淆,(2)对抗性训练,(3)对抗性实例检测和(4)认证防御,并为每组引入一些知名的方法。在介绍每种防御方法的主要思想的同时,还讨论了它们的应用场景和弱点。

中毒攻击与防御

在本节中,我们将讨论发生在DNN模型训练阶段的另一种重要的对抗性攻击类型,即中毒攻击及其对策。我们首先介绍几种经典的有针对性/无针对性的中毒攻击方法,如毒蛙[6]和BlackCard[4]。然后,我们讨论一种特定类型的对抗性攻击:后门攻击,它操纵DNN模型的训练阶段和推断阶段。特别地,将详细介绍两种常见的后门攻击类型,即模型不可知攻击和特定于模型的攻击。针对中毒攻击的防御方法,我们也将现有的方法分为三组:(1)中毒数据/模型检测,(2)中毒模型修复和(3)鲁棒训练,并为每组介绍了几项具有代表性的方法。

物理世界中的对抗性攻击

前面介绍的攻击方法是针对数字空间设置提出的,其中生成的对抗示例可以直接输入DNN模型。然而,对抗性攻击也可能发生在物理世界中,其中DNN模型的输入是由摄像机获得的,攻击者只能向摄像机展示对抗性示例。在本节中,我们讨论了几个相关的作品,让观众了解对抗性攻击在物理世界中的机制和效果。

在本节中,我们将介绍一个流行的、用户友好的用于对抗攻击和防御的PyTorch存储库-DeepRobust[5]。该知识库为用户提供了图像领域10多种流行的攻击算法和10多种防御算法,以及图神经网络对抗学习中的15多种算法的快速访问。该存储库是为想要实现攻击/防御算法的即时用户以及对抗性学习领域的研究人员和开发人员构建的,他们可以基于现有的灵活和可扩展的代码构建新的算法。该存储库基于Pytorch平台,可以在https://github.com/DSE-MSU/DeepRobust上找到该平台。

![]()

![]()

![]()

![]()

![]()

![]()

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

专知,专业可信的人工智能知识分发

,让认知协作更快更好!欢迎注册登录专知www.zhuanzhi.ai,获取100000+AI(AI与军事、医药、公安等)主题干货知识资料!

欢迎微信扫一扫加入专知人工智能知识星球群,获取最新AI专业干货知识教程资料和与专家交流咨询!

点击“

阅读原文

”,了解使用

专知

,查看获取100000+AI主题知识资料