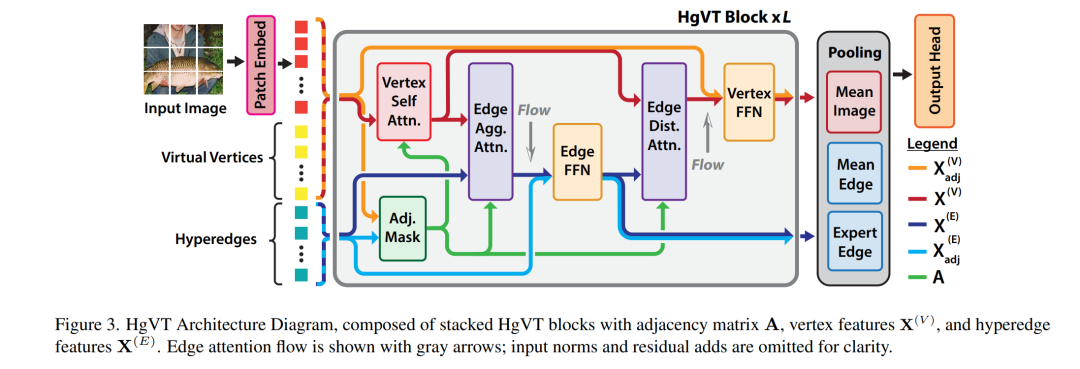

近年来,计算机视觉领域的发展凸显了视觉Transformer(ViT)在多种任务中的可扩展性,然而在适应性、计算效率以及建模高阶关系的能力之间,仍存在权衡挑战。视觉图神经网络(ViG)作为一种替代方案,通过图结构方法进行建模,但其在边生成过程中依赖的聚类算法带来了计算瓶颈。 为了解决上述问题,我们提出了一种超图视觉Transformer(Hypergraph Vision Transformer, HgVT),该方法将层次化的二分超图结构引入视觉Transformer框架中,从而在保持计算效率的同时捕捉高阶语义关系。HgVT利用种群与多样性正则化动态构建超图,无需依赖聚类操作,并引入专家边池化机制以增强语义信息提取能力,并促进基于图的图像检索。 实验结果表明,HgVT在图像分类与检索任务中均表现出色,展示了其作为高效语义视觉任务框架的潜力。

成为VIP会员查看完整内容

相关内容

Arxiv

224+阅读 · 2023年4月7日