【ICLR2021】通过多种自监督方式提升GAT中注意力

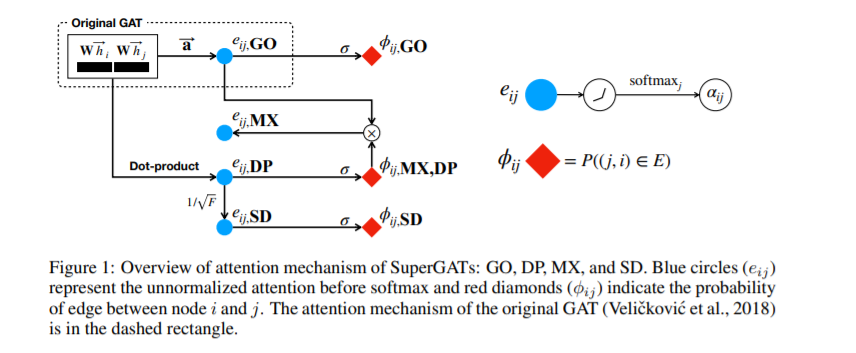

图神经网络中的注意力机制旨在将较大的权重分配给重要的邻居节点,以实现更好的表示。但是,人们对图的学习了解得不好,尤其是当图嘈杂时。在本文中,作者提出了一种自监督图注意力网络(SuperGAT),这是一种针对noisy图改进的图注意力模型。自监督的关键是找到数据中存在的监督信息,其中预测边存在和不存在是一个能够编码节点之间关系的监督信息,也被广泛的使用。本文利用这个与自监督任务兼容的两种注意力形式来预测边的存在和缺失。提出的SuperGAT通过对边进行编码,在区分错误link的邻居时会获得更多的表达注意。另外本文发现两个图上的基本属性会影响注意力的形式和自监督的有效性:同构和平均度(homophily and average degree)。这两个图的属性,可为使用哪种注意力设计提供指导。本文对17个现实世界数据集进行的实验表明,该方法可以泛化到其中的15个数据集,并且得到比基线更高的性能。

http://www.ipam.ucla.edu/abstract/?tid=16856&pcode=DLC2021

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“SGAT” 可以获取《【ICLR2021】通过多种自监督方式提升GAT中注意力》专知下载链接索引

登录查看更多

相关内容

Arxiv

6+阅读 · 2019年7月17日

Arxiv

4+阅读 · 2018年12月28日

Arxiv

21+阅读 · 2018年12月25日