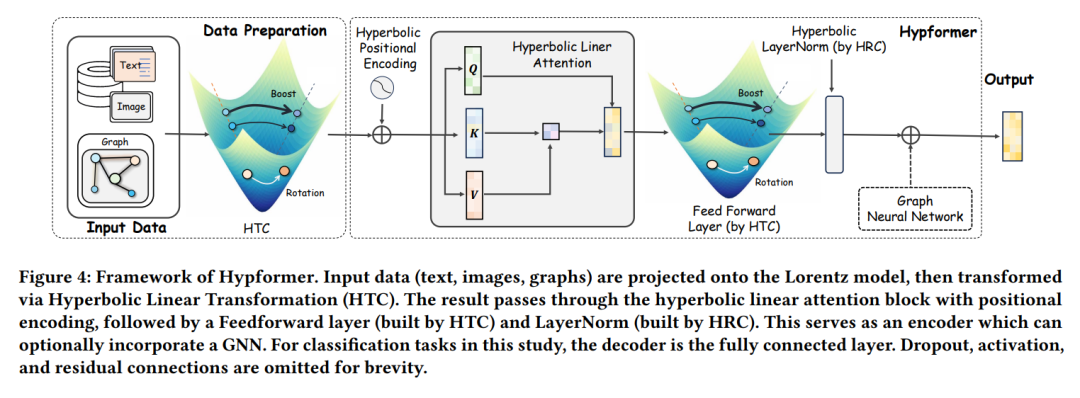

双曲几何在建模复杂结构数据(特别是具有树状和层次结构的数据)方面显示出了显著的潜力。尽管各种双曲神经网络在众多领域表现出色,但将Transformer适应于双曲空间的研究仍然有限。先前的尝试主要集中在修改Transformer中的自注意力模块。然而,这些努力未能开发出完整的双曲Transformer。这主要源于以下原因:(i) 双曲空间中缺乏定义明确的模块,包括线性变换层、LayerNorm层、激活函数、dropout操作等。(ii) 现有双曲自注意力模块相对于输入标记数量具有二次时间复杂度,限制了其可扩展性。为了解决这些挑战,我们提出了一种基于双曲几何洛伦兹模型的新型双曲Transformer,称为Hypformer。在Hypformer中,我们引入了两个基础模块,定义了双曲空间中Transformer的基本模块。此外,我们在双曲空间中开发了一种线性自注意力机制,使双曲Transformer首次能够处理亿级图数据和长序列输入。我们的实验结果证实了Hypformer在各种数据集上的有效性和效率,展示了其作为大规模数据表示和大模型的有效且可扩展解决方案的潜力。

成为VIP会员查看完整内容

相关内容

Arxiv

223+阅读 · 2023年4月7日