【导读】Transformer如何用于信息检索?橡树岭实验室最新SIGIR2022《Transformer信息检索效率和鲁棒性》教程非常值得关注!

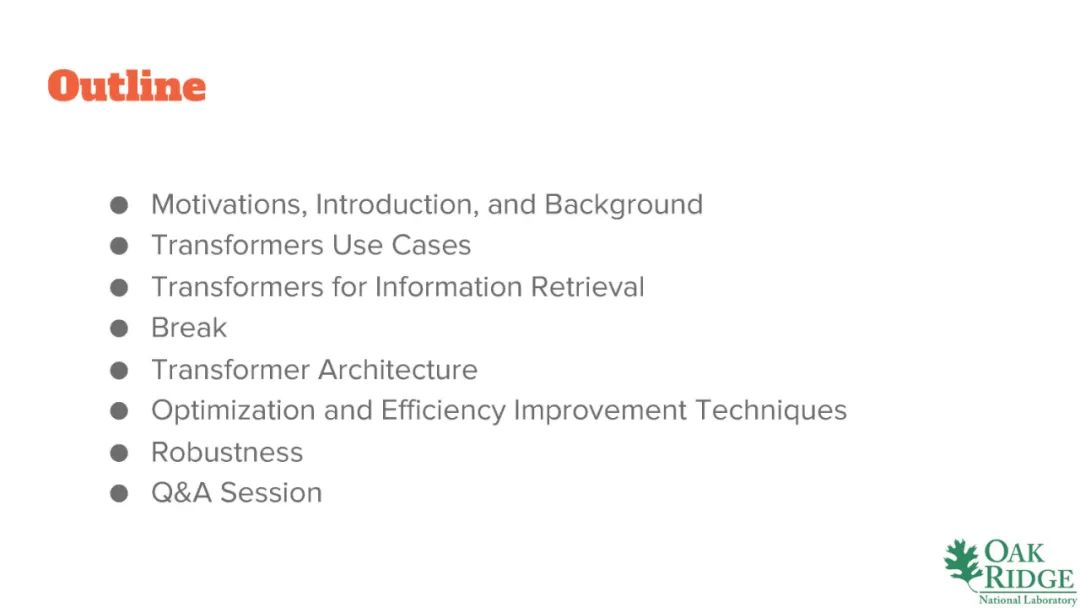

本教程侧重于提高基于transformer的方法的效率和鲁棒性的理论和实践方面,以便这些方法可以有效地用于实际的、高规模和高容量的信息检索(IR)场景。本教程的灵感和信息来自我们在使用大规模叙事数据集(85亿医疗笔记)时的工作和经验,以及我们在基于transformer的IR任务方面的基础研究和学术经验。此外,本教程重点介绍了使基于transformer的IR抗对抗(AI)开发的技术。这是我们最近在IR领域需要考虑的一个问题,我们希望与我们的读者分享一些经验教训和适用的原则。最后,本教程的一个重要(如果不是关键的话)元素是它对教学的关注——以一种清晰、直观、直白的方式提供教程内容。transformer是一门具有挑战性的学科,通过我们的教学经验,我们发现了一个巨大的价值和巨大的需求,以最直接、精确和直观的方式解释这个架构的所有相关方面和相关原则。这就是我们教程的定义风格。

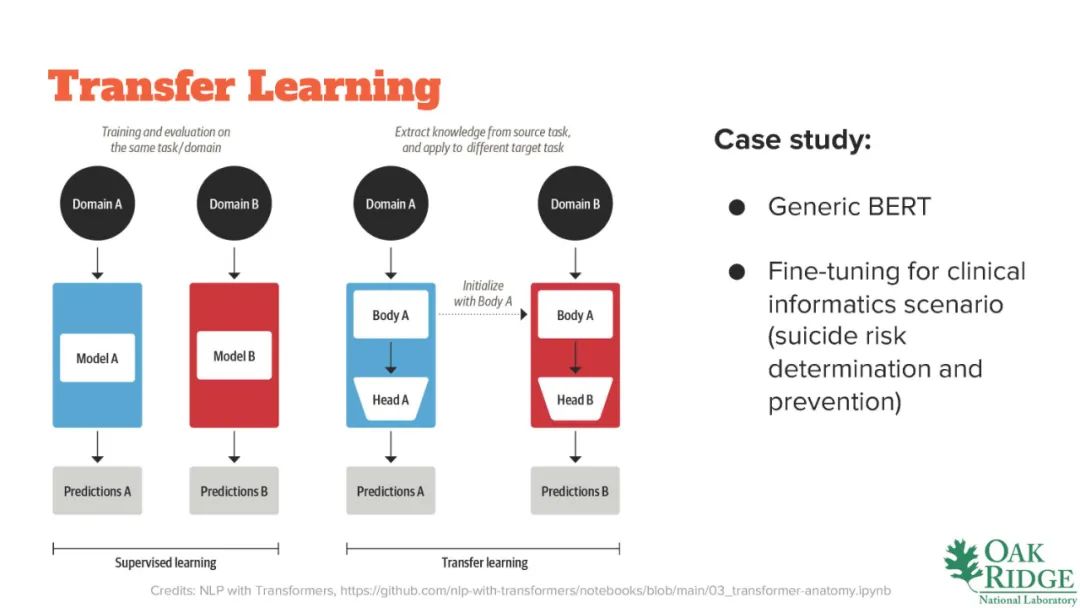

本教程基于我们在一些最大的医疗叙事数据集(VA的85亿医疗笔记数据集[4])上开发信息检索(IR)系统的经验,以及对可靠、高效和性能良好的基础设施的需求,以开展与关键医疗问题(如前列腺癌、肺癌和肝癌)相关的跨学科、大规模医学研究;预防自杀;和心血管疾病。为了开发和支持这样的系统,我们必须改进IR管道的几个版本,并对基于Transformer/ BERT的模型进行数百次重新训练和微调。由于医疗记录的规模,以及频繁的重新训练和微调的需要,我们必须设计出有效的训练和微调方法,以及最有效地使用可用的异构资源(例如,多个版本的NVIDIA GPU和CUDA发行版),以便有一个IR管道能够有效地支持我们的项目。这些经验和教训促使我们编写本教程。此外,我们还教授研究生水平的“自然语言处理专题”课程,并进行研究,考察最先进的自然语言处理模型的效率和鲁棒性等问题。所有这些都促使我们编写了一个教程,向初级到中级的IR社区介绍与IR相关的改进方法和技术,并以Transformers网络为基础。

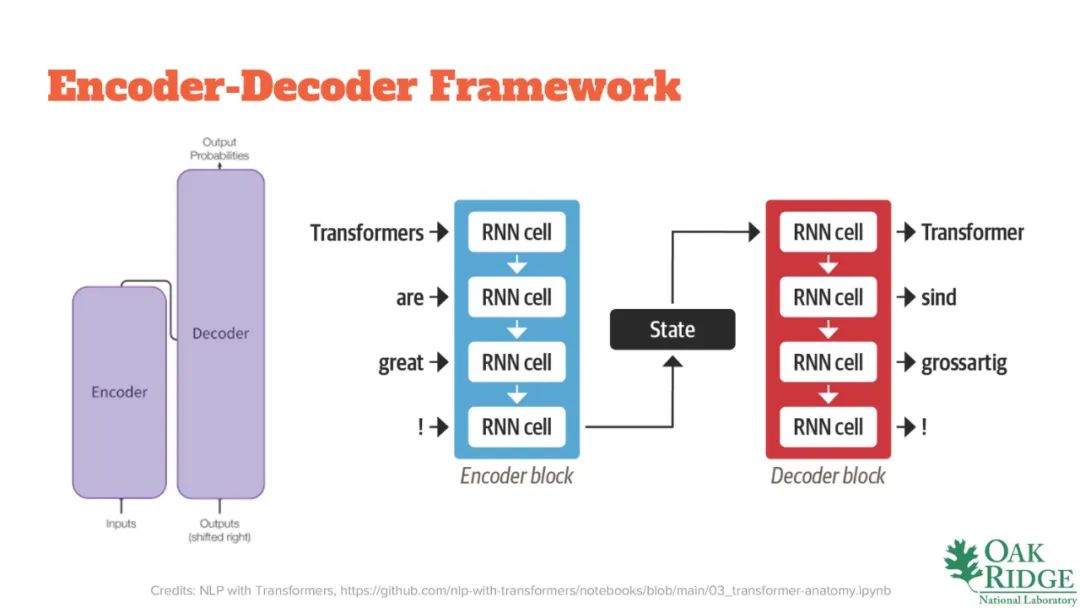

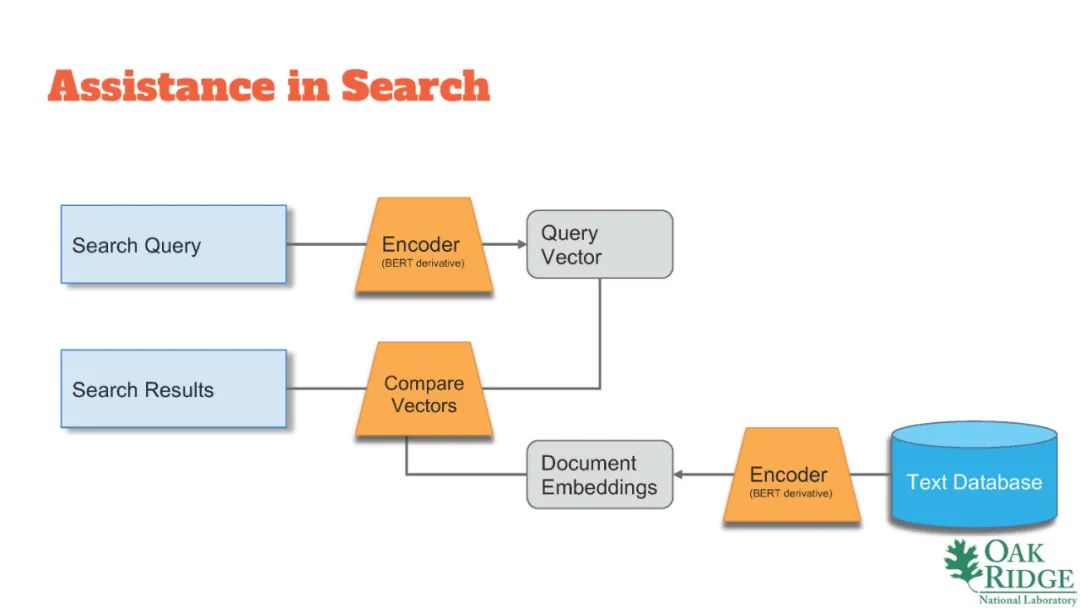

Transformers是一种强大的神经体系结构,在许多与信息检索相关的任务(自动摘要、搜索、阅读理解、机器翻译等)上,它的性能已经达到了接近或超越人类的水平。然而,基于Transformers的体系结构计算复杂,训练和调整可能会消耗资源,特别是对于长上下文的NLP任务。最近,新的方法已经被开发出来,旨在提高Transformers训练和微调的效率,特别是在提高自注意力和其他关键部件的运行效率方面。具体地说,本教程将集中在高效计算和高效、轻、快的变压器-模型大小减少和工作与高效的自注意力的技术和原则。本教程将描述如何使用蒸馏、修剪和量化来制作高效的基于Transformers的红外系统。我们将回顾高效的稀疏Transformers,如Linformer [8], BigBird [9], Reformer[3]和Performer[1],我们将回顾对关键系统性能指标的影响,如内存消耗,模型大小和运行时性能。为了减少模型尺寸,我们将涉及以下方法:

知识蒸馏

知识蒸馏是将“知识”从一个大模型转移到一个小模型的过程。这个过程概念化了教师和学生模型,其中知识从较大的教师模型转移到较小的学生模型[6]。在教程中,我们涵盖了微调知识蒸馏技术(从老师到学生的基础真实标签学习)和预训练的技术(例如,关于transformers的掩码语言模型的知识从老师转移到学生)。

权重修剪

权重修剪是一种模型压缩技术,它从模型中去除对模型结果没有贡献或贡献很小的权值。在IR的背景下,如果我们想要在较小的平台(如移动设备、辅助技术等)上部署一个计算复杂度和计算强度较小的模型,权重修剪是很有用的。在本教程中,我们将回顾一些最好的方法(使用分数矩阵、量级(非结构化)修剪、权重修剪等),以及相关优化库的使用(例如,神经网络块移动修剪[5])。我们讨论了修剪对ir相关任务的影响,随之而来的性能,以及修剪对不同GPU架构的影响。

量化

量化[2]是一种优化技术,目的是在可行的情况下降低数值表示精度。在transformer网络的背景下,该技术旨在识别和减少网络中权重的代表性大小。例如,如果我们有一个网络,参数存储在16位变量中,但信息位都存储在前6-8位中,我们将把权值/参数的表示减少到8位变量,从而节省50%的空间和相应的计算复杂度。在本教程中,我们将介绍三种量化方法(动态、静态和量化感知训练),演示使用PyTorch QFunctional包装器类的方法,并给出结果基准测试—所有这些都带有支持代码。

鲁棒性

最后,我们认识到语言模型也可能受到对抗性利用,我们将介绍一些基本技术,使面向IR的基于transformer的管道在对抗性利用方面更加鲁棒(例如,数据卫生防护[7])。

讲者:

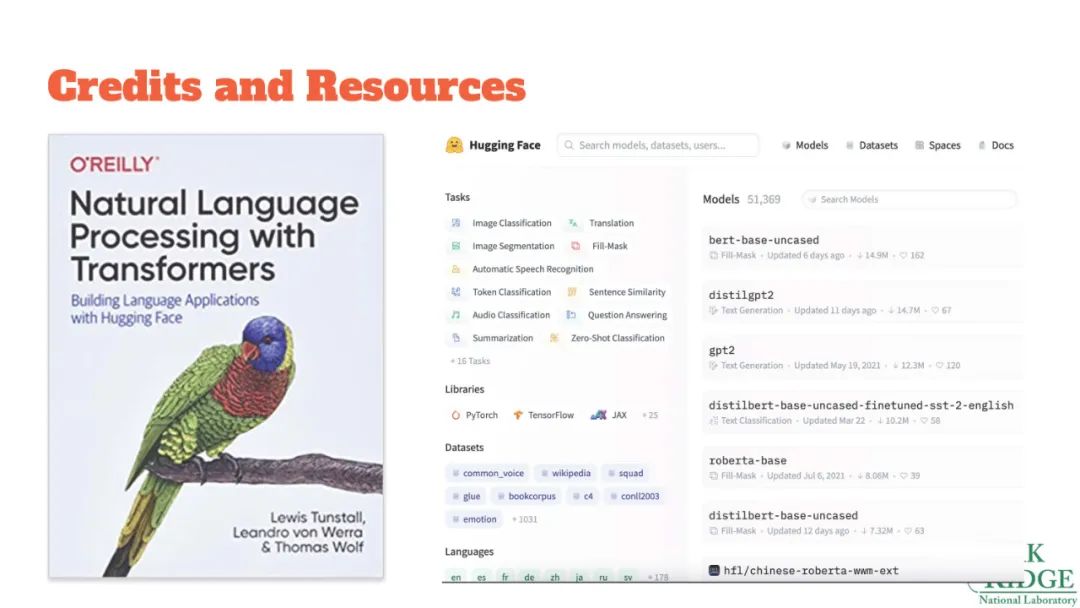

【Hugging Face硬核书】Transformer自然语言处理(Hugging Face):构建语言应用