题目: Exploring the Limits of Transfer Learning with a Unified Text-to-Text Transformer

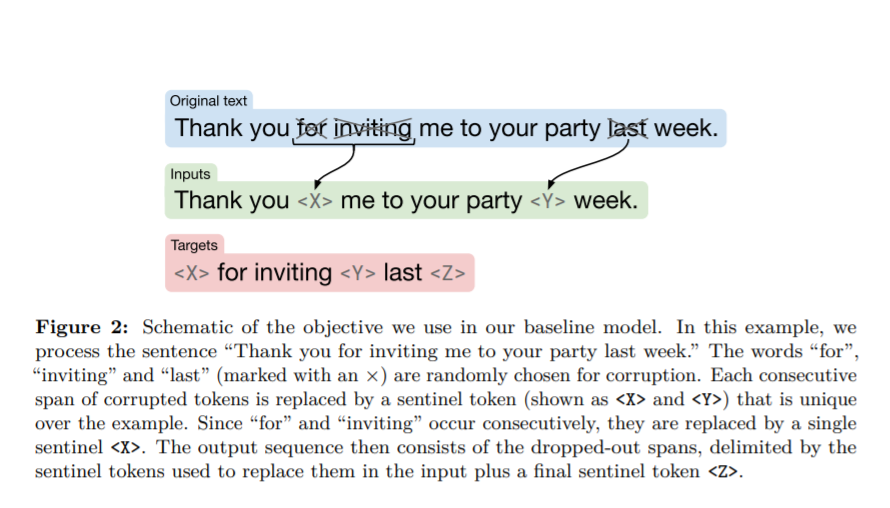

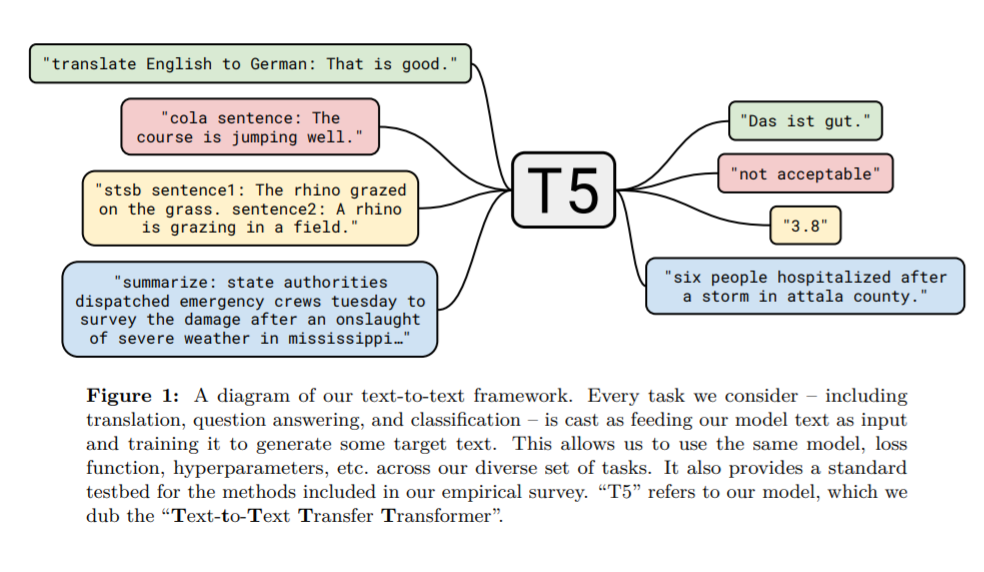

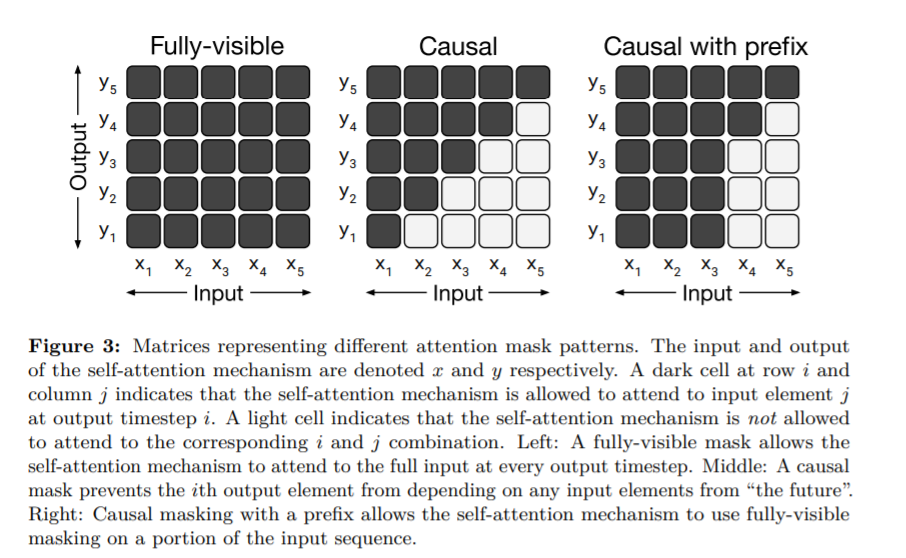

摘要: 迁移学习是自然语言处理(NLP)中的一项强大技术,它首先对一个数据丰富的任务进行预训练,然后再对下游任务进行微调。迁移学习的有效性带来了方法、方法和实践的多样性。本文通过引入一个统一的框架,将每一个语言问题转换成文本到文本的格式,探讨了NLP的迁移学习技术的发展前景。我们的系统研究比较了数十种语言理解任务的训练前目标、体系结构、无标记数据集、迁移方法和其他因素。通过结合我们的探索和规模的见解和我们新的“巨大的干净的爬网语料库”,我们在总结、问答、文本分类等许多基准上取得了最新的成果。为了促进NLP迁移学习的未来工作,我们发布了我们的数据集、预先训练的模型和代码。

成为VIP会员查看完整内容

相关内容

迁移学习(Transfer Learning)是一种机器学习方法,是把一个领域(即源领域)的知识,迁移到另外一个领域(即目标领域),使得目标领域能够取得更好的学习效果。迁移学习(TL)是机器学习(ML)中的一个研究问题,着重于存储在解决一个问题时获得的知识并将其应用于另一个但相关的问题。例如,在学习识别汽车时获得的知识可以在尝试识别卡车时应用。尽管这两个领域之间的正式联系是有限的,但这一领域的研究与心理学文献关于学习转移的悠久历史有关。从实践的角度来看,为学习新任务而重用或转移先前学习的任务中的信息可能会显着提高强化学习代理的样本效率。

专知会员服务

140+阅读 · 2020年7月10日

专知会员服务

43+阅读 · 2020年1月28日

专知会员服务

25+阅读 · 2019年11月15日

Arxiv

3+阅读 · 2019年8月22日

Arxiv

3+阅读 · 2019年1月20日