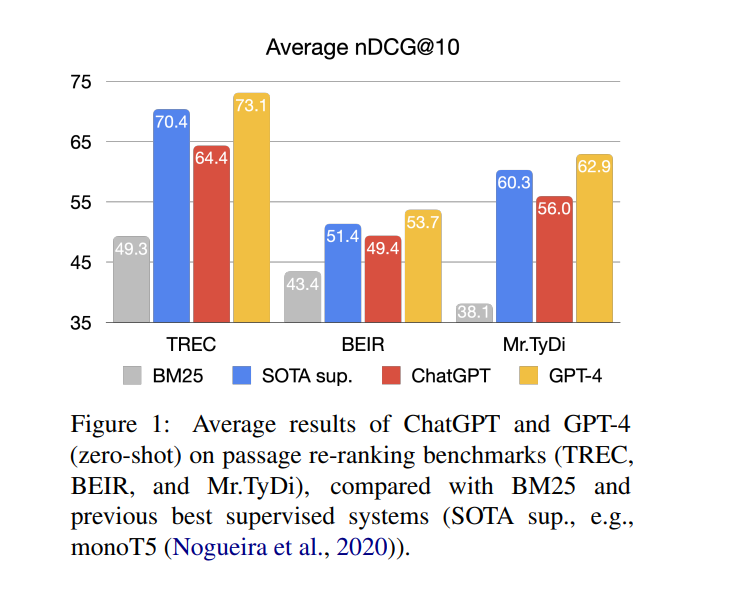

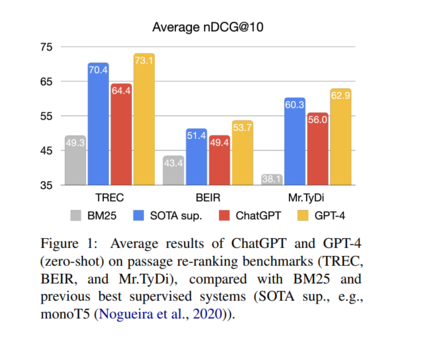

大型语言模型(LLMs)已显示出非凡的能力,可以零样本地泛化到各种与语言相关的任务。本文主要研究了基于ChatGPT和GPT-4的生成式大模型LLMs在信息检索(Information Retrieval, IR)中的相关性排序。令人惊讶的是,实验表明,在流行的IR基准上,适当指导的ChatGPT和GPT-4可以提供优异的,甚至优于监督方法的结果。值得注意的是,GPT-4在MS MARCO上比完全微调的monoT5-3B在TREC数据集上平均提高了2.7 nDCG,在8个BEIR数据集上平均提高了2.3 nDCG,在10种低资源语言Mr.TyDi上平均提高了2.7 nDCG。随后,我们深入研究了将ChatGPT的排序能力提炼为一个专门模型的潜力。在10K ChatGPT生成数据上训练的小型专用模型优于在BEIR上400K带注释的MS MARCO数据上训练的monoT5。复制我们结果的代码可以在www.github.com/sunnweiwei/RankGPT

大型语言模型(LLM),如ChatGPT和GPT-4 (OpenAI, 2022, 2023),正在以强大的零样本和少样本泛化彻底改变自然语言处理。通过对大规模文本语料库进行预训练和按照人类指令进行对齐微调,LLM在语言理解、生成、交互和推理方面表现出了卓越的能力(欧阳等人,2022)。

LLMs的成功也引起了信息检索(Information Retrieval, IR)社区的广泛关注。这些研究主要集中在利用LLM的生成能力,而不是探索LLM的搜索能力。例如,新的必应利用GPT-4根据检索到的文档生成响应(Microsoft, 2023)。因此,目前还不清楚LLM(例如ChatGPT)是否擅长搜索。 为此,该文旨在研究LLM在信息检索相关排序中的潜力。

- RQ1 ChatGPT在段落重排序任务中的表现如何?

- RQ2 如何将ChatGPT的排名能力模仿到一个更小、更专业的模型中?

为回答第一个问题,本文探索了两种策略(Sachan等人,2022a;Liang等人,2022)来指导ChatGPT在段落重排序任务上的表现,我们将其命名为指导查询生成和指导相关性生成。然而,这些方法在重排序方面的性能有限,并且严重依赖模型输出的对数概率的可用性。本文提出一种替代的指导置换生成方法,指示LLM直接输出一组段落的置换。提出了一种滑动窗口策略,允许LLM对任意数量的段落进行排序。 本文使用了三个成熟的文章排名基准进行评估:(i) TREC-DL19和DL20 (Craswell等人,2020);(ii) BEIR中的8个特定段落检索任务(Thakur等人,2021年),以及(iii)多语言段落排名基准My。10种低资源语言的TyDi (Zhang et al., 2021)。结果表明,具有零样本指向性排列生成的GPT-4在几乎所有数据集上都优于监督系统。如图1所示,GPT-4在TREC、BEIR和My上比之前的最先进技术平均提高了2.7、2.3和2.7 nDCG。分别TyDi。为回答第二个问题,本文引入一种排列蒸馏技术,将ChatGPT的段落排序能力模仿到一个更小的、专门的排序模型中。随机从MS MARCO中采样了10K个查询,每个查询由BM25检索,具有20个候选段落。我们利用ChatGPT来获得候选段落的排列,然后采用列表级目标(Wang et al., 2018)来优化学生模型,确保它学会生成与ChatGPT相同的排列。实验表明,学生模型在BEIR上比完全微调的monoT5平均提高了1.53 nDCG。所提出的蒸馏方法在成本效率方面也具有优势。

总而言之,本文的贡献有以下三个方面: * 研究了LLM在段落重排序任务上的指令方法,并介绍了一种新的排列生成方法;详见第2节。 * 综合评估了ChatGPT和GPT-4在各种文章重排序基准上的能力;详见第3节。 * 提出一种通过ChatGPT生成的排列来学习专门模型的蒸馏方法;详见第4节