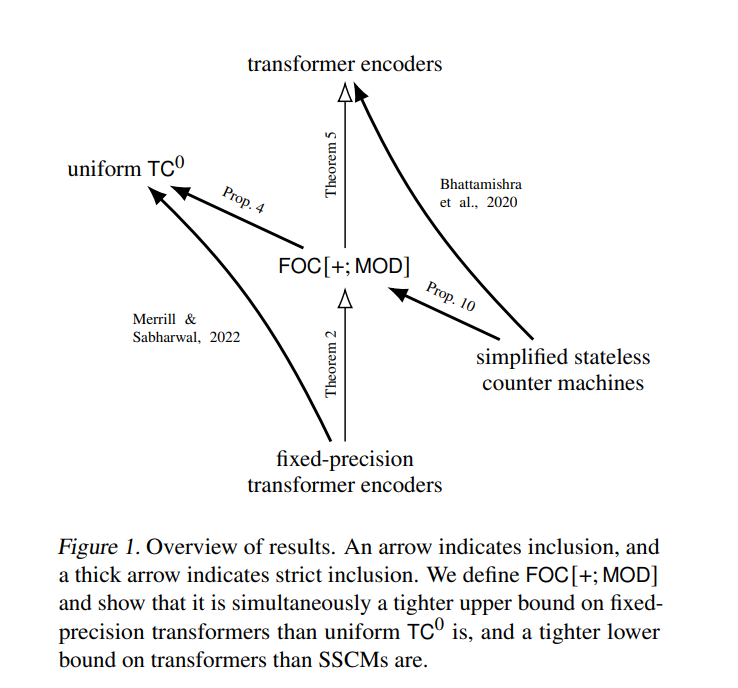

从更好理解的形式系统的角度来描述神经网络,有可能产生对这些网络的力量和局限性的新见解。对于transformer来说,这仍然是一个活跃的研究领域。Bhattamishra和其他人已经表明,transformer编码器的表达能力至少与某种计数器机器一样强,而Merrill和Sabharwal已经表明,固定精度的transformer编码器只能识别统一TC中的语言。通过识别具有计数量词的一阶逻辑变体,将这些结果联系起来并加强,该变体同时是固定精度transformer编码器的上界和transformer编码器的下界。这使我们比以前更接近transformer编码器识别的语言的确切特征。

https://www.zhuanzhi.ai/paper/571bd61949e3574aa0b115cf779fbb9e

成为VIP会员查看完整内容

相关内容

Arxiv

12+阅读 · 2021年12月30日