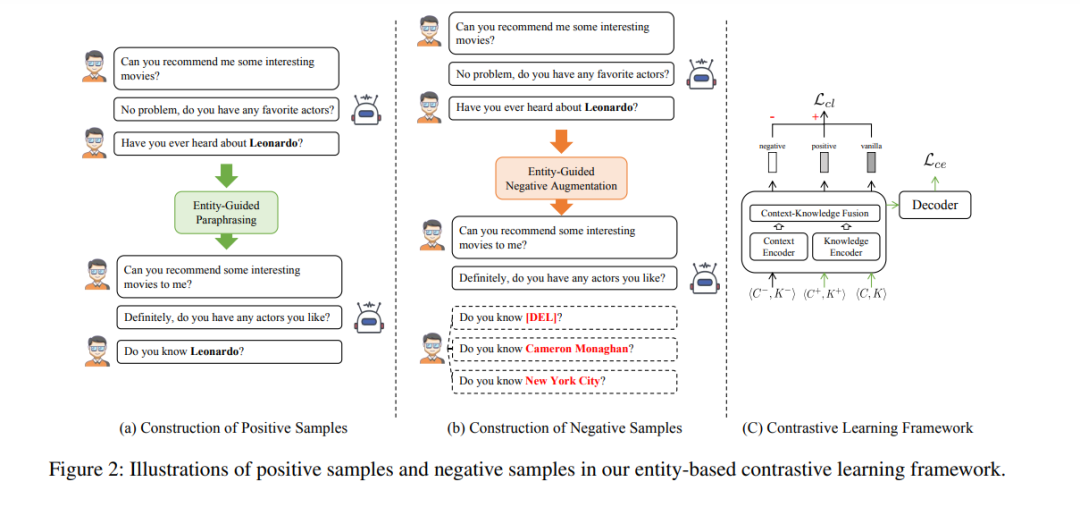

![]() 基于知识的对话(KGD)学习基于给定对话环境和外部知识(例如,知识图谱;KGs)生成有信息量的回应。近期,大型语言模型(LLMs)和预训练技术的出现为基于知识的对话带来了巨大成功。然而,在实际应用中构建KGD系统时,各种现实世界的噪声是不可避免的。例如,对话环境可能涉及到的扰动包括拼写错误和缩写等。此外,知识图谱通常存在不完整性,也可能包含错误和过时的事实。这些现实世界的噪声对KGD系统的鲁棒性构成挑战,并阻碍了其在现实世界中的应用。在这篇论文中,我们提出了一个基于实体的对比学习框架,以提高KGD的鲁棒性。具体而言,我们利用KGD样本中的实体信息创建包含语义无关和语义相关扰动的正负样本。对比学习框架确保KGD模型意识到这两种类型的扰动,从而在现实应用中面对潜在噪声输入时生成有信息量的回应。在三个基准数据集上的实验结果显示,我们的方法在自动评估分数方面实现了新的最佳性能,验证了其有效性和潜力。此外,我们展示了我们的方法在噪声环境和少样本设置下都能比对比模型生成更好的回应。

基于知识的对话(KGD)学习基于给定对话环境和外部知识(例如,知识图谱;KGs)生成有信息量的回应。近期,大型语言模型(LLMs)和预训练技术的出现为基于知识的对话带来了巨大成功。然而,在实际应用中构建KGD系统时,各种现实世界的噪声是不可避免的。例如,对话环境可能涉及到的扰动包括拼写错误和缩写等。此外,知识图谱通常存在不完整性,也可能包含错误和过时的事实。这些现实世界的噪声对KGD系统的鲁棒性构成挑战,并阻碍了其在现实世界中的应用。在这篇论文中,我们提出了一个基于实体的对比学习框架,以提高KGD的鲁棒性。具体而言,我们利用KGD样本中的实体信息创建包含语义无关和语义相关扰动的正负样本。对比学习框架确保KGD模型意识到这两种类型的扰动,从而在现实应用中面对潜在噪声输入时生成有信息量的回应。在三个基准数据集上的实验结果显示,我们的方法在自动评估分数方面实现了新的最佳性能,验证了其有效性和潜力。此外,我们展示了我们的方法在噪声环境和少样本设置下都能比对比模型生成更好的回应。 ![]()