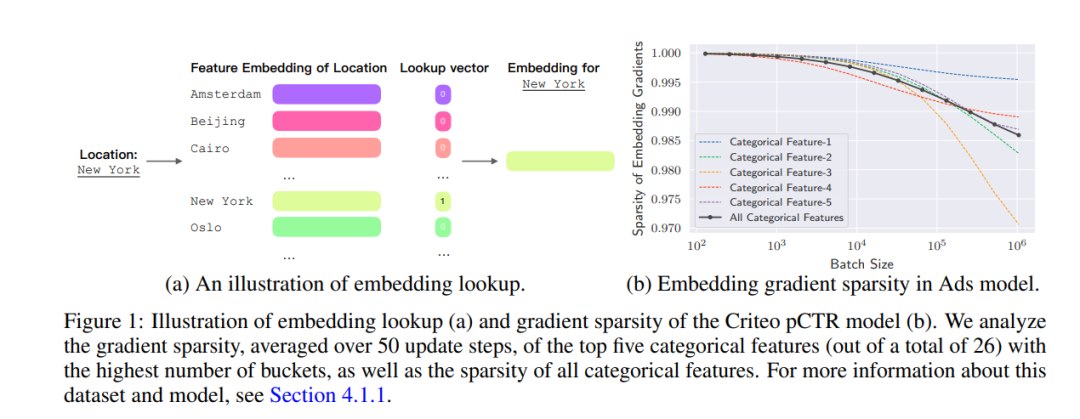

随着大型嵌入模型在推荐系统和语言应用中的使用日益增加,用户数据隐私的担忧也随之上升。DP-SGD(差分隐私随机梯度下降)作为一种训练算法,将差分隐私与随机梯度下降相结合,已成为在不过多损害模型准确性的前提下保护用户隐私的主力。然而,如果直接应用DP-SGD到嵌入模型,可能会破坏梯度的稀疏性,导致训练效率降低。为了解决这个问题,我们提出了两种新算法,DP-FEST和DP-AdaFEST,它们在大型嵌入模型的私有训练过程中保持了梯度的稀疏性。在基准真实世界数据集上,我们的算法实现了梯度大小显著减少(106倍),同时保持了可比较的准确性水平。

成为VIP会员查看完整内容

相关内容

Arxiv

224+阅读 · 2023年4月7日