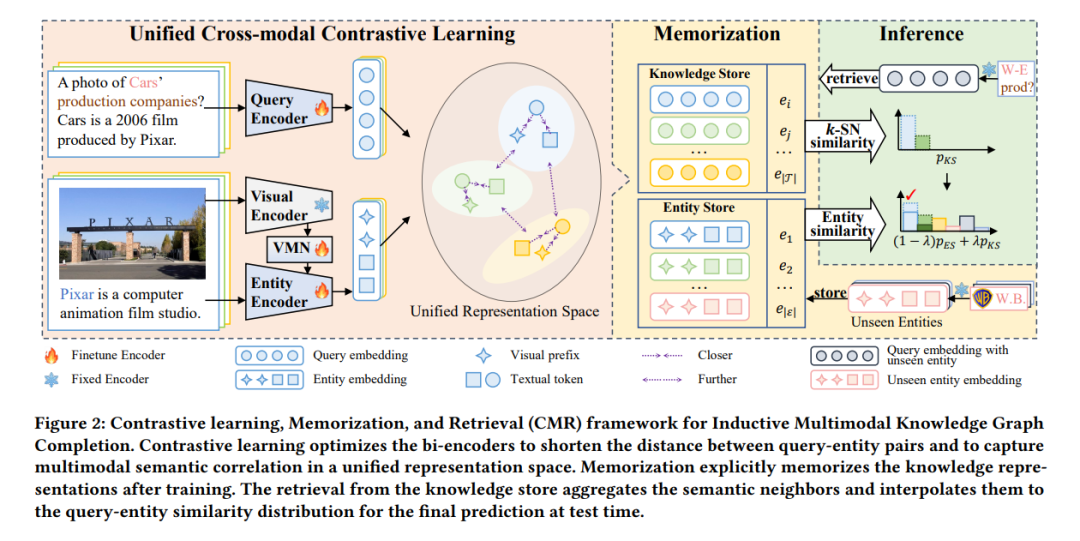

大量研究已经涌现出来用于多模态知识图谱补全(MKGC),以预测多模态知识图谱(MKGs)中的缺失链接。然而,用于研究归纳多模态知识图谱补全(IMKGC)的研究相对较少,这些研究涉及训练期间未见过的新兴实体。现有的归纳方法主要关注学习文本实体表示,忽略了视觉模态中的丰富语义信息。此外,它们侧重于从现有知识图谱中聚合结构邻居,而新兴实体的结构邻居通常是有限的。然而,语义邻居与拓扑连接是解耦的,通常暗示了真正的目标实体。在本文中,我们提出了IMKGC任务和一个语义邻居检索增强的IMKGC框架CMR,通过对比将有用的语义邻居拉近,然后通过记忆支持语义邻居检索以增强推理。具体来说,我们首先提出了一种统一的跨模态对比学习,同时捕捉查询实体对在统一表示空间中的文本-视觉和文本-文本相关性。对比学习增加了正查询实体对的相似性,从而使有用的语义邻居的表示更加接近。然后,我们明确记忆知识表示以支持语义邻居检索。在测试时,我们检索最近的语义邻居并将其插入到查询实体相似性分布中,以增强最终预测。大量实验验证了CMR在三个归纳MKGC数据集上的有效性。代码可在https://github.com/OreOZhao/CMR获得。

成为VIP会员查看完整内容

相关内容

Arxiv

224+阅读 · 2023年4月7日