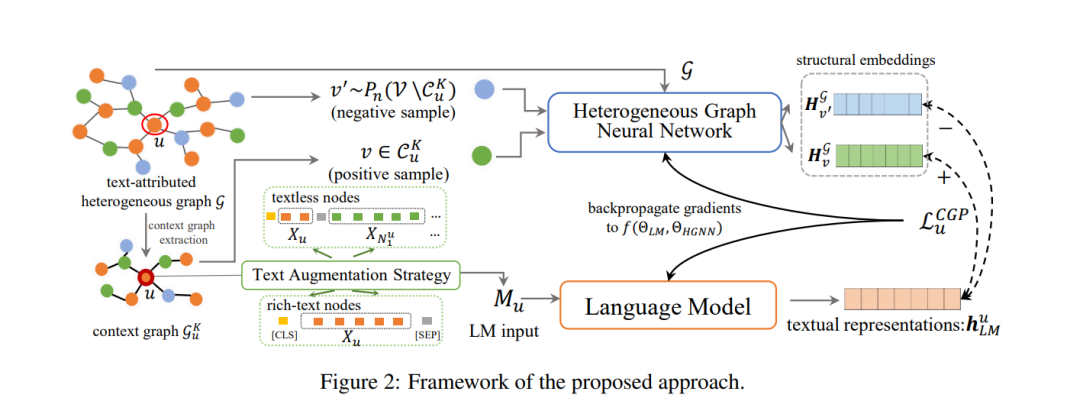

在许多实际情况中(例如,学术网络、社交平台),不同类型的实体不仅与文本关联,而且还通过各种关系相互连接,这可以被抽象为文本属性异构图(TAHGs)。当前的语言模型(LMs)预训练任务主要集中在分开学习每个实体的文本信息,并忽视了捕捉TAHGs中实体之间的拓扑关系的重要方面。在这篇论文中,我们提出了一个新的针对LMs的预训练框架,明确地考虑TAHGs中的拓扑和异构信息。首先,我们定义了一个上下文图为特定顺序内的目标节点的邻域,并提议一个拓扑意识的预训练任务,通过联合优化LM和一个辅助的异构图神经网络来预测参与上下文图的节点。其次,基于观察到一些节点文本丰富,而其他节点文本很少的现象,我们设计了一种文本增强策略,通过其邻居的文本来丰富没有文本的节点,以处理不平衡问题。我们在三个来自不同领域的数据集上进行链接预测和节点分类任务。实验结果证明了我们的方法相对于现有方法的优越性和每种设计的合理性。我们的代码可在以下链接找到:https://github.com/Hope-Rita/THLM。

成为VIP会员查看完整内容

相关内容

Arxiv

0+阅读 · 2023年12月6日

Arxiv

42+阅读 · 2023年4月19日

Arxiv

223+阅读 · 2023年4月7日