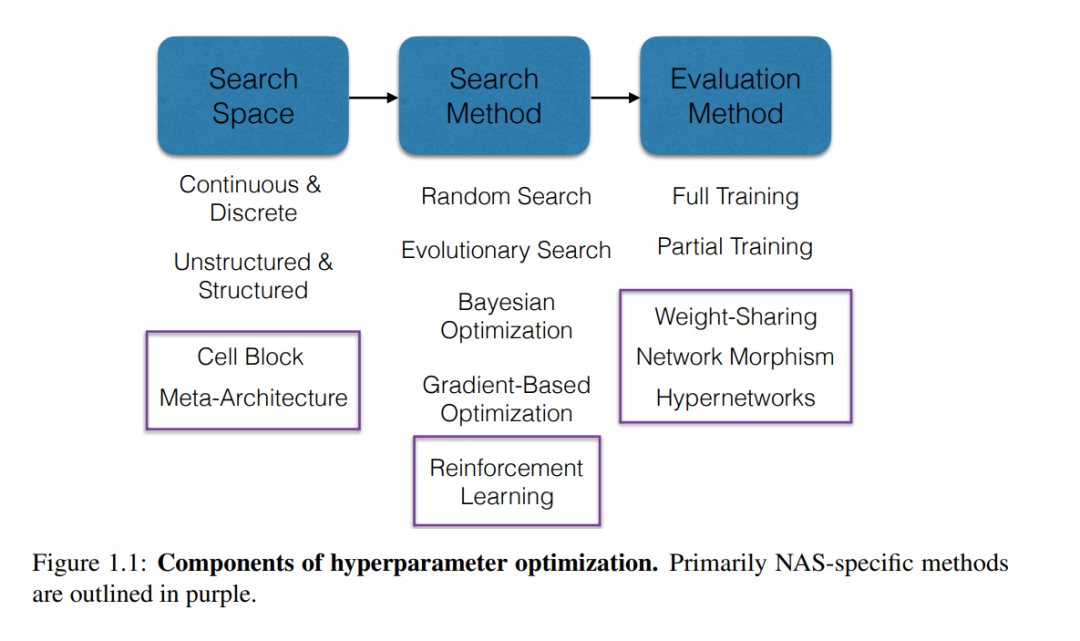

机器学习被广泛应用于各种不同的学科,以开发感兴趣的变量的预测模型。然而,构建这样的解决方案是一个耗时且具有挑战性的学科,需要经过高度训练的数据科学家和领域专家。作为回应,自动化机器学习(AutoML)领域旨在通过自动化减少人工工作量并加快开发周期。由于超参数在机器学习算法中无处不在,以及调优的超参数配置可以对预测性能产生影响,超参数优化是AutoML的一个核心问题。最近,深度学习的兴起推动了神经架构搜索(NAS),这是一个专注于自动化神经网络设计的超参数优化问题的专门实例。对于大规模调优问题,网格搜索和随机搜索等简单的超参数优化方法在计算上是难以处理的。因此,本文的重点是开发高效和有原则的超参数优化和NAS方法。

**在回答以下问题方面取得了进展,目的是开发更高效和有效的自动化机器学习算法。**1. 超参数优化(a)我们如何有效地使用早期停止来加速超参数优化?(b)如何利用并行计算来执行超参数优化,同时在顺序设置中训练单个模型所需的时间?(c)对于多阶段机器学习管道,我们如何利用搜索空间的结构来减少总计算成本?

- 神经架构搜索(a)最先进的权重共享NAS方法和随机搜索基线之间的性能差距是什么?(b)如何开发更有原则的权重共享方法,并证明收敛速度更快和改进的经验性能?(c) NAS中常用的权重共享范式是否可应用于更一般的超参数优化问题?

鉴于这些问题,本文分为两个部分。第一部分侧重于通过解决1a, 1b和1c问题在高效超参数优化方面取得的进展。第二部分侧重于通过解决问题2a, 2b和2c,在理解和改进神经架构搜索的权重共享方面取得的进展。

成为VIP会员查看完整内容

相关内容

卡耐基梅隆大学(Carnegie Mellon University)坐落在宾夕法尼亚州的匹兹堡,是一所享誉世界的私立顶级研究型大学,学校面积不大,学科门类不多,但在其所设立的几乎所有专业都居于世界领先水平。卡内基梅隆大学享誉全国的认知心理学、管理和公共关系学、写作和修辞学、应用历史学、哲学和生物科学专业。它的计算机、机器人科学、理学、美术及工业管理都是举世公认的一流专业。

Arxiv

0+阅读 · 2023年4月17日

Arxiv

224+阅读 · 2023年4月7日