多智能体协同决策问题是群体智能领域一个重要的研究方向,随着深度强化学习算法在多智能体决策领域如游戏AI、推荐系统、智能交通等方面的应用,基于深度强化学习的多智能体算法已经成为一个研究热点。文中分别针对不完全信息决策、复杂决策空间设计以及动态博弈等问题开展分析,并阐述了相应的算法或模型,最后对未来多智能体领域的研究进行了展望。

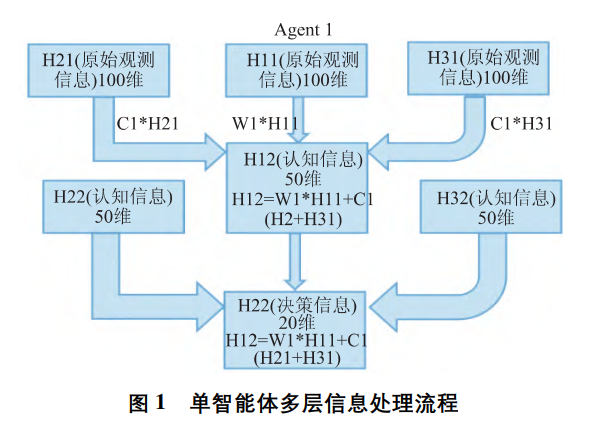

多智能体[1-5]系统由一群有自主性的,可互相 交互的实体组成,它们共享一个相同的环境,通过感 知器感知环境并通过执行器采取行动。根据系统中 智能体的结构不同可以分为同构多智能体系统和异 构多智能体系统,异构多智能体系统个体间模型不 统一,使得个体感知环境的方式或者决策空间存在 一定的差异。在多智能体系统中,智能体通过与环 境进行交互获取当前决策下的奖励,智能体基于奖 励改善策略并获得最优策略的方法为多智能体强化 学习算法。

相对于单智能体策略学习问题,多智能体策略 学习过程具有更高的复杂度。一方面在于多智能体 不仅要考虑环境因素,还要考虑到己方、敌方、中立 方的行动和意图; 另一方面考虑智能体间的神经网 络网络是相互连接的,以此来促进智能体之间的协 同性。在单智能体强化学习中,智能体所在的环境 通常是稳定不变的,但是在多智能体强化学习中,环 境是复杂的、动态的,因此给学习过程带来很大的困 难。强化学习[5]算法包含状态值函数和动作- 状态 值函数等要素。在多智能体强化环境中,状态空间、 动作空间随智能体数量指数增长,因此多智能体情形下搜索空间通常非常巨大,对计算资源要求高。基于每个智能体的任务不同,其决策动作的奖励设 计不同,但是彼此之间又相互耦合影响,其设计的优 劣对学习到的策略好坏有直接的影响。多个智能体 的策略是同时学习的,在单个智能体的策略发生改 变时,其他智能体的最优策略也可能会变化,这将对 算法的收敛性带来影响。

根据对多智能体控制形式的不同,多智能体协 同算法可以分为集中式( 中心化) 控制算法与分布 式( 去中心化) 控制算法。集中式控制算法通常把 整个多智能体系统的协作机制看成一个整体,通过 一个全局性的中央单元对所有单元进行统一控制。与集中式控制算法对应,分布式控制算法将各个智 能体划分为单个主体,每一个主体独立处理环境状 态信息,并做出行为决策。随着深度思考等知名研 究机构在星际争霸 2、守护古树 2 等多智能体游戏 环境中取得突破,基于深度强化学习算法[6-8]实现 对多智能体集中式或分布式协同控制的研究已经成 为人工智能领域的研究热点。本文主要介绍应对多智能体博弈环境下面临信 息不完全、动作空间维度爆炸、动态不确定性等问题 的主要方法,并对未来深度强化学习算法的发展及 应用进行展望。