摘要——根据规模预测,大型模型在许多领域取得了突破性进展,特别是在自然语言生成任务中,它们的表现已接近甚至超越人类水平。然而,前所未有的参数规模带来了显著的计算和存储成本。这些大型模型需要大量的计算资源和GPU内存来运行。在将大型模型适应于特定下游任务时,其庞大的参数规模在计算能力和GPU内存有限的硬件平台上微调时面临重大挑战。为了解决这个问题,参数高效微调(PEFT)通过有效调整大型预训练模型的参数以适应各种下游任务,提供了一种实用的解决方案。具体而言,PEFT调整预训练大型模型的参数,以适应特定任务或领域,最小化额外参数的引入和所需的计算资源。本文主要介绍PEFT的基础知识、各种PEFT算法的核心思想和原理、PEFT的应用以及未来研究方向。通过阅读本综述,我们相信感兴趣的读者能够迅速掌握PEFT方法论,从而加速其发展和创新。 关键词——微调、参数高效、大型语言模型、深度学习、人工智能。

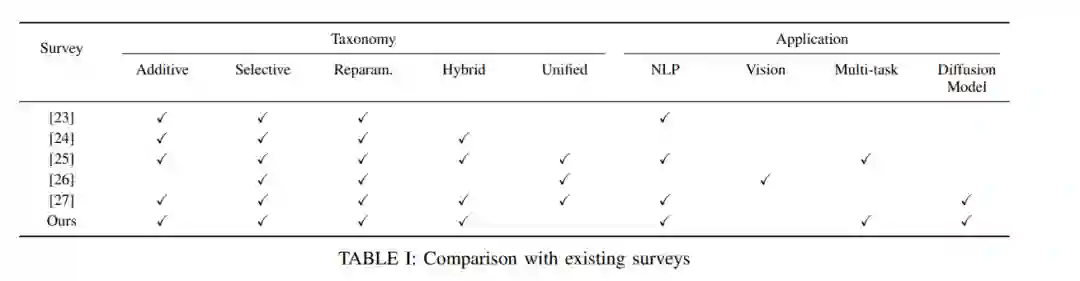

最近几年,大型预训练模型(通常称为“大模型”)作为人工智能领域的一项重要进展,逐渐受到广泛关注。由于其在各种应用场景中的卓越表现和多样性,这些模型引发了大量讨论。这些模型具有强大的计算能力和丰富的数据资源,使其能够在处理复杂任务时表现出色。在自然语言处理(NLP)领域,大型语言模型(LLMs)备受关注。这些模型在文本生成、机器翻译、个性化聊天机器人、文本摘要、情感分析和问答系统等任务中展现出卓越的创造力。 然而,大模型的发展面临着重大挑战和争议。这些模型需要大量的计算资源和数据支持,这可能对环境造成威胁并影响隐私保护。尽管在特定任务中表现出色,但这些模型仍然存在局限性和错误率,需要不断优化和改进。在直接使用大模型处理特定任务时,其性能往往低于预期。因此,微调大模型已成为提高模型性能的关键方法。 PEFT(参数高效微调)是一种转移学习方法,专门用于调整大型预训练模型的参数,以适应新的任务和场景。这种方法涉及动态调整模型,以增强其在执行特定任务时的有效性,考虑到目标任务的独特特征和要求。微调过程通常包括改进模型架构、优化参数和调整学习策略等多个方面,以在新任务中实现更好的性能。随着深度学习领域的不断发展,优化和微调大模型的技术也取得了显著进展。值得注意的PEFT方法包括LoRA、适配器调优、前缀调优、提示调优、P-tuning、BitFit等。 然而,尽管在多个领域中,大模型微调技术取得了显著成就,但仍然存在许多需要解决的挑战和困难。例如,过拟合的缓解、微调效率的优化,以及在预训练与微调任务之间找到学习平衡等问题都需要更多的研究。 近年来,关于PEFT的文章层出不穷,其中一些研究提供了对最流行方法的有益概述。以下是对这些研究的比较分析。丁宁等人引入了一种理论抽象,用于Delta Tuning,从优化和最优控制的角度进行分析。这一抽象提供了一种统一的方法,描述当前的参数高效微调方法,为未来的研究提供了独特的视角。然而,尽管该研究主要集中在NLP应用上,但这些方法在不同领域的通用性和有效性仍需进一步探讨。Lialin等人提供了全面的分析和分类,涵盖了广泛的方法,并比较了约30种方法在存储效率、内存效率、计算效率、准确性和推理开销等五个维度上的表现。然而,虽然文章主要关注于对数十亿参数规模语言模型进行有效微调的详细方法,但对真实应用场景的探讨相对有限。徐玲玲等人对当前PEFT方法进行了全面的评估和分析,评估了它们在一系列NLP任务中的性能、参数效率和内存利用率。然而,该论文并未充分阐述这些方法在实际操作环境中的应用,也未深入探讨它们的适应性及可能遇到的领域特定挑战。辛怡等人提供了视觉PEFT的全面概述和未来方向,系统地回顾了最新的进展。尽管文章涵盖了多种视觉任务,但实验主要集中在几个常见任务上,并未完全涵盖更广泛的潜在应用场景。韩泽宇等人详细分类了PEFT方法,探讨了PEFT技术在各种模型架构和下游任务中的应用,以及参数高效微调方法的系统设计挑战。该研究为研究人员和工程师提供了PEFT方法的全面概述,但在实际应用覆盖方面仍有改进空间。 我们的贡献如下:

- 我们提供了与现有综述论文相比,更全面和详细的关于大模型和一般微调方法论的基础知识概述。这部分内容不仅涵盖了大模型的基本原理、结构和技术,还提供了它们在自然语言处理、多模态活动和其他领域的实际应用的深入概述。

- 我们的调查涵盖了最新的研究方法论,突出展示了大模型领域的最新进展。这确保了我们的综述内容全面且详尽。我们的综述范围广泛,涵盖了自然语言处理、多模态任务和计算机视觉等多个场景,使读者能够全面理解大模型技术的现状和未来前景。

- 在回顾和分析当前方法后,我们提出了一些创新和面向未来的研究方向。这些领域考虑到了先进模型技术的增长潜力,并结合了实际应用中行业需求和障碍,提出了可行和创新的研究途径。

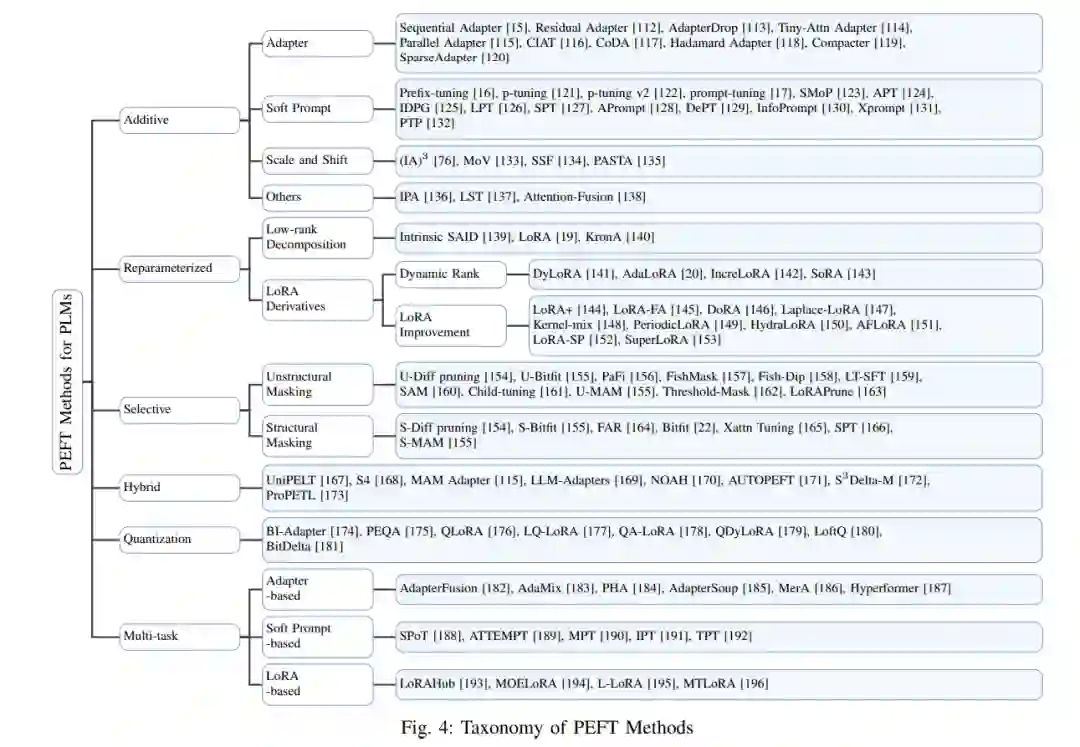

本调查旨在全面回顾大模型微调技术的最新进展。通过对现有研究的深入审查,我们的目标是识别并填补当前知识体系中的空白,从而开发出一个全面和系统的知识框架,为研究人员提供清晰的视角,并指导他们未来的研究。总之,我们的工作为相关领域提供了有价值的资源和视角,供学术和实践用途。调查的剩余部分结构如下: 在第二部分中,我们提供大型语言模型基本组成部分的简要总结,包括其过去的发展、新兴能力以及支配其规模的扩展规律。随后,我们简要概述了全面语言模型的主要分类,并介绍了多模态综合模型的基本原理和框架。此外,我们还探讨了在大型语言模型微调领域采用的主要方法,包括指令微调、对齐和基于人类反馈的强化学习(RLHF)。最后,我们简要总结了在大模型微调领域最常用的基准和评估数据集。 在第三部分中,我们提供了对PEFT方法的全面分析和总结,展示了当前PEFT方法的分类框架,涵盖了2019年6月至2024年7月发布的100多篇研究文章。我们在传统的加法、重新参数化和减法PEFT分类基础上,纳入了混合、量化和多任务分类PEFT方法的总结。 在第四部分中,我们对多模态、视觉和扩散模型领域的PEFT方法进行全面分析和描述。我们的目标是提供深刻的理解和针对不同应用场景的PEFT选择和改进建议。 在第五部分中,我们总结了我们的广泛调查,并提出了多个有前景的未来发展方向,包括算法改进和任务场景,旨在为这一蓬勃发展的领域的进一步研究和发展提供有价值的见解。