I. 引言**

从演示中学习(Learning from Demonstration, LfD)[1], [2],也称为模仿学习(Imitation Learning)[3], [4],是通过观察和模仿一组专家演示来学习期望的机器人行为模型的领域**。基于场景的观察和所需任务的条件,模型(通常称为策略)被训练生成与专家演示中行为相似的动作。根据任务的不同,这些动作可能代表期望的末端执行器姿态 [5], [6]、机器人轨迹 [7], [8] 或期望的场景安排 [9], [10] 等。LfD 包括几种解决这一问题的方法。行为克隆(Behavioral Cloning, BC)方法 [1] 将条件生成模型拟合到基于观察的动作上。尽管在序列决策问题中存在一些缺点(例如,错误累积导致的协变量偏移 [11]),但在实践中,由于其稳定且高效的训练算法,它已经展示了一些最为令人印象深刻的结果 [6], [12], [7], [13]。另一种方法是逆强化学习(Inverse Reinforcement Learning, IRL)[14], [15], [16] 或其变体 [17], [18], [19],结合了演示数据与环境中的试错(即强化学习(Reinforcement Learning, RL)),生成的策略比 BC 更具鲁棒性,但受到训练算法稳定性较差的限制。与直接模仿演示动作的 BC 不同,IRL 侧重于推断演示行为所优化的潜在奖励函数,并应用 RL 来推断策略。IRL 的一个关键优势在于它能够仅通过观察进行学习 [20], [21],而无需明确的演示动作信息。在 LfD 中,演示的固有特性带来了重大挑战。通常,收集的数据是次优的、噪声较大的、基于高维观察条件的,并且包含多种行为模式 [22], [23], [24]。这种多样性可以在对给定物体的多种抓取方式、专家提供演示的偏好或专家之间的分歧中体现出来。数据的这些固有属性促使研究人员寻找能够恰当地捕捉其分布的模型。传统上,在深度学习成为主流之前,LfD 方法通常使用高斯过程(Gaussian Process, GP)[25], [26]、隐马尔可夫模型(Hidden Markov Model, HMM)[27], [28] 或高斯混合模型(Gaussian Mixture Models, GMM)[29] 来表示生成模型。然而,这些模型无法扩展至大数据集,也无法在图像等高维上下文中表示条件分布。基于神经网络的模型允许在图像 [30], [31] 或文本 [32], [33] 等高维变量上进行条件设定,但它们通常被训练为单峰模型。这些模型与收集的演示数据的多模式特性相冲突。这些模型无法捕捉数据中的固有多样性和多模式,导致研究人员不得不将自己局限于较小的 [34] 或高度策划的数据集,以确保单峰性,从而简化建模过程。

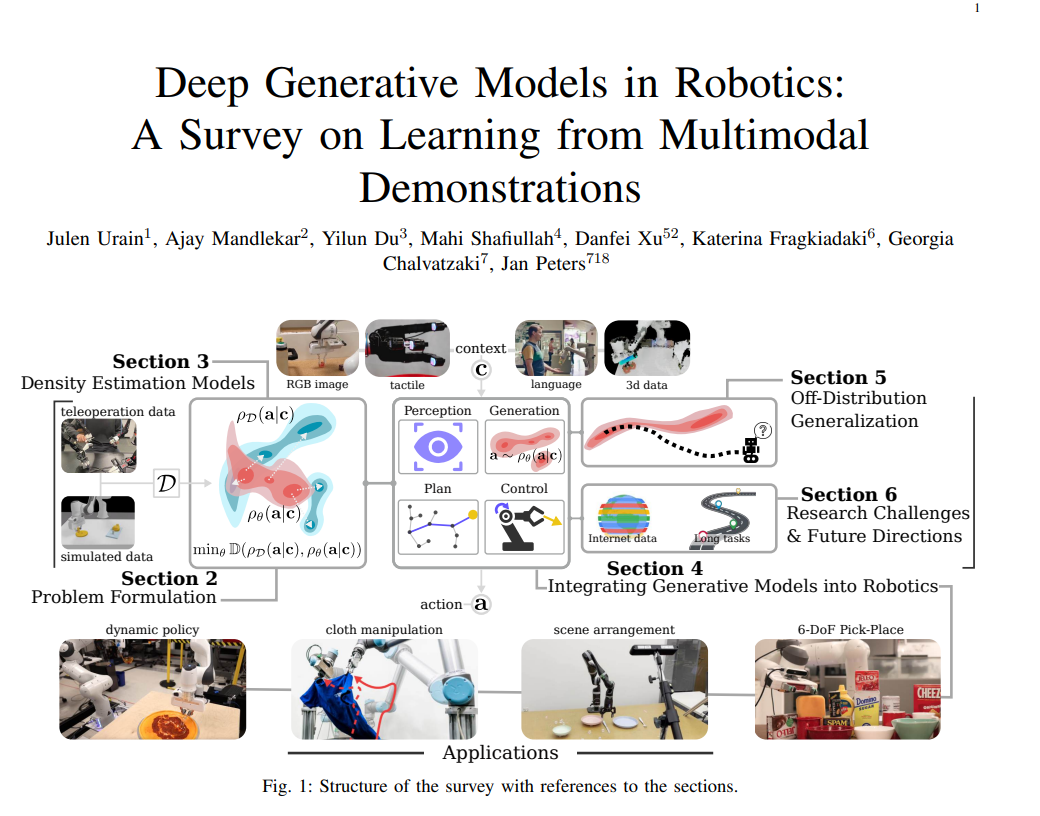

近年来,深度生成模型(Deep Generative Models, DGM)在图像 [35] 和文本生成 [36] 中的成功展示了其捕捉高度多模态数据分布的能力。近年来,这些表现力强的模型在机器人领域的模仿学习应用中引起了广泛关注(见图2)。例如,扩散模型(Diffusion Models, DM)[37], [35] 已被有效用于学习高维轨迹分布 [38], [7], [8];基于语言和图像的策略使用类似GPT的模型来表示动作空间中的类别分布 [39];变分自编码器(Variational Autoencoders, VAE)[40] 被应用于生成任意物体的六自由度(6-DoF)抓取姿态 [5]。本文统一且全面地回顾了机器人领域中为捕捉数据固有的多模态性而从演示中学习 DGM 的各种方法。尽管其中一些模型借鉴了其他机器学习领域的成果,如 DM,但我们也重点介绍了在机器人动作分布表示中特别有影响力的方法,如动作价值图(Action Value Maps)[41], [42], [43]。本综述主要关注使用离线数据的方法,即不收集额外的在线或交互数据,以及离线监督,即除了专家动作外不使用额外的监督。尽管在从视觉到文本生成的各个领域中,从离线数据集中学习 DGM 已被广泛研究,但机器人领域有其固有的挑战,需要谨慎的设计选择。为了激发机器人应用中的具体设计选择,我们将在 I-A 节中介绍从演示中学习策略的基本挑战。我们将综述分为六个部分(见图1): 在第二部分中,我们将形式化问题并提供整个综述中使用的术语。 在第三部分中,我们介绍了机器人领域中最常用的 DGM,展示了它们的固有属性,简要列出了应用这些方法的各种工作,并介绍了每种模型的训练和采样算法。 在第四部分中,我们展示了深度生成模型应用的不同类型,重点介绍了模型生成的数据类型以及考虑的条件变量类型。 在第五部分中,我们提出了一系列设计和算法归纳偏差,以提高从学习模型的数据分布中的泛化能力。我们如何保证在上下文观察中生成有用的动作,而这些动作在演示中没有出现?我们提出的选项包括生成模型的模块化组合、从观察中提取有用特征以及利用观察与动作之间的对称性。 最后,在第六部分中,我们强调了该领域当前的研究挑战,并提出了未来的研究方向。

A. 从离线演示中学习的挑战从离线演示中学习机器人策略面临着若干挑战。尽管其中许多挑战(例如演示中的多模态)与其他研究领域(如图像生成或文本生成)共享,但在机器人领域中,我们还需要考虑一些特有的挑战。以下是从离线数据中学习机器人策略的主要挑战。演示的多样性。主要挑战之一是演示本身的固有变化。不同的演示者可能具有不同的技能水平、偏好和完成相同任务的策略,导致数据集中包含广泛的方法。单峰分布缺乏表达能力,无法捕捉演示中的这种变化,从而导致性能不佳。DGM 是解决这一挑战的有前景的方法。通过捕捉复杂的多模态分布,这些模型可以学习表示演示中展现的不同策略和行为。异质的动作和状态空间。与数据空间定义明确的计算机视觉不同,在机器人领域中,没有单一的状态-动作空间。机器人动作可以包括从力矩命令到期望的目标位置或期望的轨迹。此外,机器人行为可以在机器人的配置空间和任务空间中建模。这种多样性导致了异质的数据集和用于学习机器人策略的异质解决方案。部分可观察的演示。当人类执行演示时,其动作不仅基于可观察到的元素,还受到任务知识和观察历史影响的内部状态驱动。此外,人类可以整合环境中的信息,这些信息可能无法被机器人的传感器轻易获得或观察到,例如人类视觉捕捉到的外围细节但被机器人的摄像头遗漏。这种不匹配往往导致演示仅部分代表任务的上下文,从而导致机器人学习的策略中出现歧义。关于部分可观测性的问题已经在文献中得到了广泛研究 [44]。一种常见的实际方法是将观察历史编码为上下文,而不是单一的观察,允许模型提取内部状态,从而减少歧义 [45]。时间依赖性和长视距规划。机器人任务通常涉及序列决策,其中动作在时间上是相互关联的。这种序列性可能导致错误的累积,将机器人引向训练演示中未遇到的情况。为解决此问题,已有多种方法提出。一些工作建议学习短视距技能,然后与高层规划器连接。另一方向是,许多工作 [38], [13] 提出学习生成动作轨迹而不是单步动作的策略,从而减少序列累积错误。此外,其他选项包括在生成演示时注入噪声 [46] 或交互式扩展数据集 [11]。训练和评估目标之间的不匹配。从离线演示中学习通常被定义为密度估计问题。学习的模型经过训练以生成类似于训练数据集的样本。然而,学习的模型用于解决特定任务,最大化的度量是任务成功率。这种训练目标与评估目标之间的不匹配可能导致在机器人用于解决特定任务时表现不佳。解决这一问题的一个可能方向是将行为克隆阶段与后续强化学习微调相结合 [47]。分布偏移和泛化。从离线演示中学习的一个基本挑战是演示数据与实际场景之间的分布偏移,在这些场景中,学习的策略被部署。演示通常在受控环境或特定上下文中收集,但机器人必须在演示未覆盖的潜在新环境中运行。这种不匹配可能导致泛化失败和性能下降。解决这一挑战需要能够从给定演示中推断并适应新环境的技术。我们将在第五部分中探讨提高机器人应用中泛化能力的不同方法。

B. 相关综述

LfD 领域有着悠久的历史,已有多篇综述对此进行了探讨。在基于深度学习的方法成为主流之前,已有几篇综述 [50], [51], [52], [53] 探讨了模仿学习的基本问题。这些综述回答了诸如我们应该如何获取数据?我们应该学习什么模型?或我们应该如何学习策略?等问题。近年来,一些最新的研究 [54], [3], [55] 更新了基于深度学习模型在 LfD 问题中的应用的综述。特别是 [3] 从算法的角度审视了模仿学习,使得不同算法的比较可以从信息论的角度进行。机器人学习社区的当前阶段,随着大规模机器人演示数据集的增加(无论是在模拟中还是在现实中),模仿学习方法的重要性日益增加,以及廉价机器人硬件的日益普及,当前适时提供一个涵盖过去几年研究进展并专注于该领域当前面临挑战(多模态性、泛化、异质数据集等)的综述。最近,几篇综述 [56], [57] 探讨了学习机器人基础模型的问题,主要集中在将互联网规模的视觉和语言基础模型整合到机器人问题中。尽管将视觉-语言基础模型应用于机器人问题具有潜力,但我们的综述关注于不同的问题。本综述的兴趣在于探索如何直接从具体现体机器人的数据中学习策略(部分原因是大规模数据集的日益丰富 [24], [58]),而不是将视觉-语言模型适应于机器人。