高赞新书《可解释的机器学习》出版:理解黑盒必备,免费资源

铜灵 发自 凹非寺

量子位 出品 | 公众号 QbitAI

最近,这本名为《可解释性的机器学习》书在推特火了起来,两天内2千多人点赞,将近700人转发。

作者Christoph Molnar介绍说,这是一本关于黑盒模型可解释性的理解指南,用时两年完成,全书共250多页,七万八千多字。

好消息,这本《可解释性的机器学习》全书电子版现在可以在线预览了。Molnar在推特上解释,你可以自己选择为这本书支付多少钱,不掏腰包也没什么,免费版本也将一直提供。

一起来看看内容——

内容有啥?

这本书共分为10个章节,从什么是机器学习和可解释的定义解释,到模型的常用解释方法和基于示例的解释,再到机器学习与可解释性的未来,内容一气呵成。

“可解释”是这本书的核心论题,作者认为,可解释性在机器学习甚至日常生活中都是相当重要的一个问题。

Molnar表示,虽然数据集与黑盒机器学习解决了很多问题,但这不是最好的使用姿势,现在模型本身代替了数据成为了信息的来源,但可解释性可以提取模型捕捉到的额外信息。

而这些额外的信息可能会发挥更大的作用。

举个例子🌰,自动驾驶汽车通过深度学习系统自动检测骑自行车的人,如果你想让模型正确率保持在100%,必须了解其背后的解释:哦,原来模型识别的是自行车的两个轮子,所以对于自行车边缘被遮挡的情况还要进行进一步优化。

此外,当我们的日常生活中全都是机器和算法时,需要可解释性来增加社会的接受度。这倒是也不难理解,要是连科学家都有研究不透“黑盒”,怎样让普通人完全信任模型做出的决策呢?

所以Molnar认为,“解释”还是一个社会过程,拉进人类与机器的距离。

模型的可解释性

对于机器学习方法可解释性,Molnar在书中进行了深刻的讨论,对线性回归、logistic回归、GLM、GAM、决策树、决策规则等可解释模型进行了细致说明。

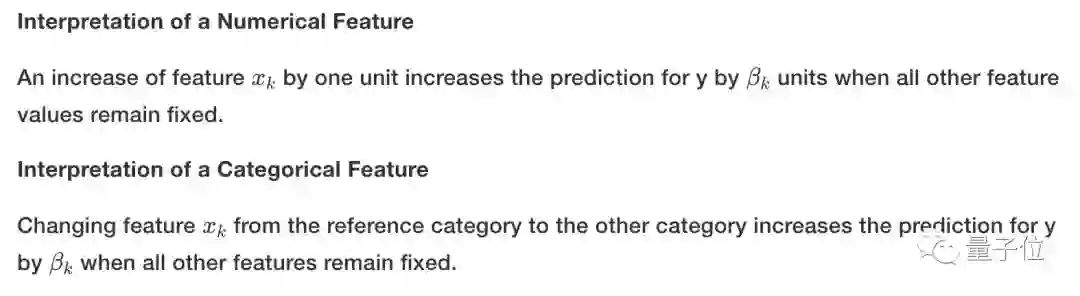

在线性回归的解释中,Molnar认为线性回归模型中权重的解释取决于相应特征的类型,比如数字特征、二进制功能、具有多个类别的分类功能等,都对理解线性回归有帮助。

在这本书中,Molnar还内置很多解释模型各种方法的模板,方便你速查时使用。比如如果你想解释线性回归模型中的特征,直接去套用模板就可以了。

Molnar认为,在机器学习任务中,应该将研究重点放在与模型无关的可解释性工具上,在未来机器学习就是一个自动化的训练过程。

关于可解释性的未来,作为还做出了预测,认为在以后的研究中机器人和程序将尝试去解释自己。有趣值Max。

书中还有很多精彩内容,就等你前往阅读了。

“Wow!”

《可解释的机器学习》电子版放出后,网友纷纷竖起大拇指,高呼“感谢作者”。

“这本书真令我大开眼界”、“神奇的书”、“出色的解释”……网友的好评声在评论区蔓延。

网友@mspitzer243表示,感谢作者贡献了这本书,也感谢在iml包中提供的很多技术实现。这本书帮助自己很多,对可解释性有了更深的理解,甚至还激励自己开始写博客文章了。

还不来收藏围观一下?

最后,附电子书地址:

https://christophm.github.io/interpretable-ml-book/index.html

作者系网易新闻·网易号“各有态度”签约作者

— 完 —

加入社群

量子位现开放「AI+行业」社群,面向AI行业相关从业者,技术、产品等人员,根据所在行业可选择相应行业社群,在量子位公众号(QbitAI)对话界面回复关键词“行业群”,获取入群方式。行业群会有审核,敬请谅解。

此外,量子位AI社群正在招募,欢迎对AI感兴趣的同学,在量子位公众号(QbitAI)对话界面回复关键字“交流群”,获取入群方式。

诚挚招聘

量子位正在招募编辑/记者,工作地点在北京中关村。期待有才气、有热情的同学加入我们!相关细节,请在量子位公众号(QbitAI)对话界面,回复“招聘”两个字。

量子位 QbitAI · 头条号签约作者

վ'ᴗ' ի 追踪AI技术和产品新动态

喜欢就点「好看」吧 !