可解释机器学习:打开黑盒之谜(238页书籍下载)

【导读】机器学习模型经常被批评是技术黑箱:只要输入数据就能得到正确答案,但却无法对其进行解释。Christoph Molnar在其新书中呼吁大家当前是时候停止将机器学习模型视为黑盒子,在学会运用模型的同时更应去学会分析模型如何做出决策,并给出了将黑盒变得具有可解释性的讨论。

机器学习领域在过去十年中发生了显著的变化。从一个纯粹的学术和研究领域方向开始,我们已经看到了机器学习在各个领域都有着广泛的应用,如零售,技术,医疗保健,科学等等。在21世纪,数据科学和机器学习的重要目标已经转变为解决现实问题,自动完成复杂任务,让我们的生活变得更加轻松,而不仅仅是在实验室做实验发表论文。机器学习,统计学或深度学习模型工具已基本成型。像Capsule Networks这样的新模型在不断地被提出,但这些新模型被工业采用却需要几年时间。因此,在工业界中,数据科学或机器学习的主要焦点更多在于应用,而不是理论。最重要的是能够解决复杂的现实问题。

机器学习模型本质上就是一种算法,该算法试图从数据中学习潜在模式和关系,而不是通过代码构建一成不变的规则。所以,解释一个模型是如何在商业中起作用总会遇到一系列挑战。在某些领域,特别是在金融领域,比如保险、银行等,数据科学家们通常最终不得不使用更传统更简单的机器学习模型(线性模型或决策树)。原因是模型的可解释性对于企业解释模型的每一个决策至关重要。然而,这常常导致在性能上有所牺牲。复杂模型像如集成学习和神经网络通常表现出更好更精准的性能(因为真实的关系在本质上很少可以通过线性划分的),然而,我们最终无法对模型决策做出合适的解释。

为了解决和探讨这些差距,本书重点介绍模型可解释性的重要及以及各种可解释性模型。

可解释性深度学习可以查看专知以前文章:

打开人工智能黑箱:看最新16篇可解释深度学习文章,带您了解增强AI透明性

请关注专知公众号(点击标题下方蓝色专知关注)

后台回复“可解释机器学习” 就可以获取238页《Interpretable Machine Learning》书下载链接~

专知《深度学习:算法到实战》2019年1月正在开讲,欢迎报名!

专知开课啦!《深度学习: 算法到实战》, 中科院博士为你讲授!

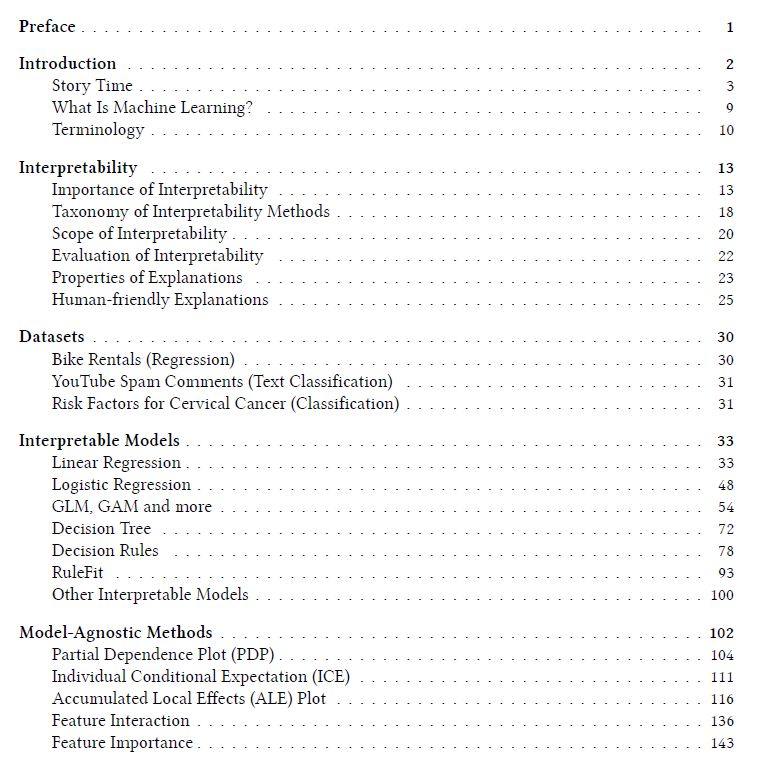

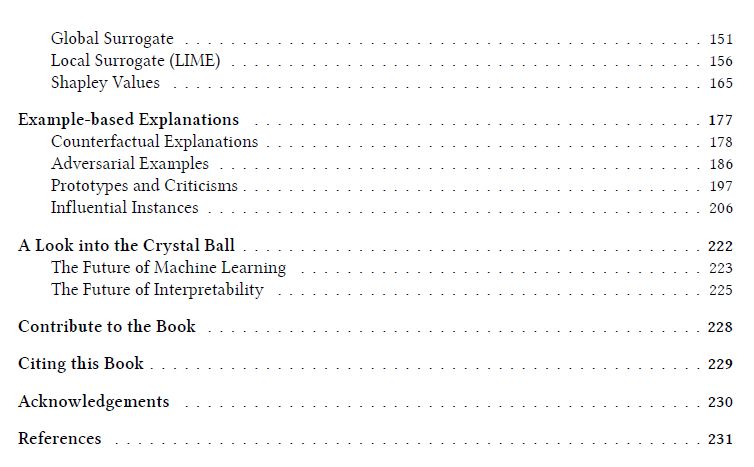

目录

第1章简介

本书向您解释如何使(监督的)机器学习模型可解释。这些章节包含一些数学公式,但即使没有公式,您也应该能够理解方法背后的思想。 这本书不适合那些试图从头开始学习机器学习的人。如果您是机器学习的新手,有很多书籍和其他资源可以学习基础知识。作者推荐Hastie,Tibshirani,Friedman(2009)的书“The Elements of Statistical Learning”和Andrew Ng在线学习平台coursera.com上的“机器学习”在线课程。这本书和课程都是免费的!

可解释机器学习模型的新方法以非常快的速度在迭代更新。要跟上所有出版的东西是疯狂的,根本不可能。这就是为什么你在这本书中找不到最新颖、最奇特的方法,而是机器学习可解释性的既定方法和基本概念。这些基础知识使您可以使机器学习模型可解释。将基本概念内化还可以帮助您更好地理解和评估自您开始阅读本书以来最近5分钟内在arxiv.org上发表的关于可解释性的任何新论文。

本书从一些(反乌托邦)短篇故事开始,这些短篇小说不是用来理解这本书的,而是希望能够让你感受到并让你思考。然后,本书探讨了机器学习可解释性的概念。我们将讨论何时可解释性很重要以及有哪些不同类型的解释。贯穿全书的术语可以在术语一章中查阅。大部分的模型和方法都是用数据章节中描述的真实数据例子来说明的。使机器学习可解释的一种方法是使用可解释的模型,如线性模型或决策树。另一种选择是使用模型无关的解释工具,这些工具可以应用于任何有监督的机器学习模型。模型不可知的方法通过改变机器学习模型的输入和测量预测输出的变化来工作。在“基于示例的说明”一章中讨论了返回数据实例作为解释的模型不可知方法。所有模型不可知方法都可以根据它们是否解释所有数据实例或单个预测的全局模型行为来进一步区分。以下方法解释了模型的整体行为:部分依赖图,累积局部效应,特征交互,特征重要性,全局代理模型以及原型和批评。为了解释个体预测,我们有局部代理模型,Shapley值解释,反事实解释(以及密切相关的:对抗例子)。一些方法可用于解释全局模型行为和个体预测的两个方面:个体条件期望和有影响的实例。

第2章可解释性

可解释性没有数学定义。米勒Miller(2017)所喜欢的(非数学)定义是:可解释性是一个人能够理解决策原因的程度。另一个是:可解释性是指一个人能够持续预测模型结果的程度。机器学习模型的可解释性越高,人们就越容易理解为什么做出某些决定或预测。如果一个模型的决策比另一个模型的决策更易于理解(interpretable),那么该模型比其他模型更易于解释。作者将交替使用interpretable和explainable这两个术语。像Miller(2017)一样,作者认为区分术语interpretability和explainability是有意义的。

参考链接:

https://christophm.github.io/interpretable-ml-book/

https://christophm.github.io/

-END-

专 · 知

专知《深度学习: 算法到实战》课程正在开讲! 中科院博士为你讲授!

请加专知小助手微信(扫一扫如下二维码添加),咨询《深度学习:算法到实战》参团限时优惠报名~

欢迎微信扫一扫加入专知人工智能知识星球群,获取专业知识教程视频资料和与专家交流咨询!

请PC登录www.zhuanzhi.ai或者点击阅读原文,注册登录专知,获取更多AI知识资料!

点击“阅读原文”,了解报名专知《深度学习:算法到实战》课程