题目: Learning@home: Crowdsourced Training of Large Neural Networks with Decentralized Mixture-of-Experts

摘要:

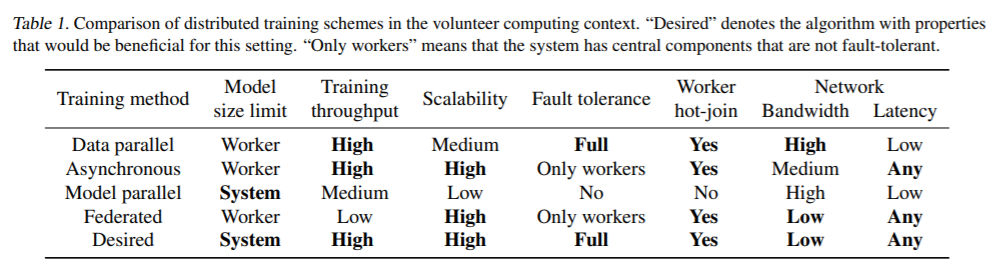

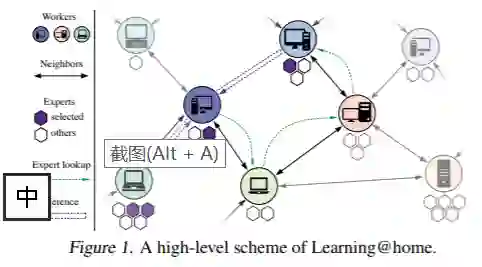

最近在深度学习方面的许多突破都是通过在海量数据集上训练越来越大的模型实现的。然而,训练这样的模型可能会非常昂贵。例如,威震天在一个价值2500万美元的GPU集群上训练了83亿参数的语言模型。因此,大多数研究人员无法负担训练最先进模型的费用并为其发展作出贡献。假设,研究人员可以用志愿者提供的数千台常规PC来众包大型神经网络的训练。1万台价值2500美元的台式机的原始计算能力使价值2500万美元的服务器pod相形见绌,但是使用传统的分布式训练方法无法有效地利用这种能力。在这项工作中,我们提出了Learning@home:一种神经网络训练范式,用于处理数百万连接不良的参与者。我们分析了该范例的性能、可靠性和架构约束,并将其与现有的分布式培训技术进行了比较。

成为VIP会员查看完整内容

相关内容

Arxiv

4+阅读 · 2018年1月11日