如何让训练神经网络不无聊?试试迁移学习和多任务学习

雷锋网按:本文为雷锋字幕组编译的论文解读短视频,原标题Transfer Learning vs Multitask Learning,作者为Ibrahim Sobh。

翻译 | 李晶 编辑 | 吴璇

训练深度神经网络是一个乏味的过程。更实际的方法,如重新使用训练好的网络解决其他任务,或针对许多任务使用相同的网络。这篇文章中,我们会讨论两个重要的方法:迁移学习和多任务学习。

迁移学习

在迁移学习中,我们希望利用源任务学到的知识帮助学习目标任务。例如,一个训练好的图像分类网络能够被用于另一个图像相关的任务。再比如,一个网络在仿真环境学习的知识可以被迁移到真实环境的网络。

总的来说,神经网络迁移学习有两种方案:特征提取和微调。迁移学习一个典型的例子就是载入训练好VGG网络,这个大规模分类网络能将图像分到1000个类别,然后把这个网络用于另一个任务,如医学图像分类。

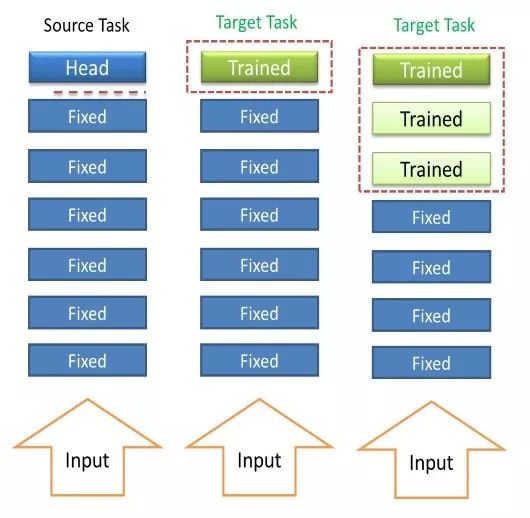

1) 特征提取

特征提取是针对目标任务把一个简单的分类器加在源任务上预训练的网络上,将预训练的网络作为特征提取器。仅有添加的分类器的参数需要更新,预训练的网络的参数不变。这能使新任务从源任务中学习到的特征中受益。但是,这些特征更加适合源任务。

2) 微调

微调允许学习目标任务时修改预训练的网络参数。通常,在预训练的网络之上加一个新的随机初始化的层。预训练网络的参数使用很小的学习率更新防止大的改变。通常会冻结网络底层的参数,这些层学到更通用的特征,微调顶部的层,这些层学到更具体的特征。同时,冻结一些层能够减少需要训练的参数的数量,避免过拟合问题,尤其时在目标任务数据量不够大的情况下。实践中,微调胜过特征提取因为他针对新的任务优化了预训练的网络。

迁移学习的基本情形:

迁移学习可以分为4种情形基于以下两个因素:1)目标任务数据集的大小,2)源任务与目标任务的相似度:

情形1:目标数据集很小,目标任务与源任务相似:这种情况使用特征提取,因为目标数据集小容易造成过拟合。

情形2:目标数据集很小,目标任务与源任务不同:这时我们微调底层网络,并移除高层网络。换句话说,我们使用较早的特征提取。

情形3:目标数据集很大,目标任务与源任务相似:我们有了大量的数据,我们可以随机初始化参数,从头开始训练网络。然而,最好还是使用预训练的网络初始化参数并微调几层。

情形4:目标数据集很大,目标任务与源任务不同。这时,我们微调大部分层甚至整个网络。

多任务学习

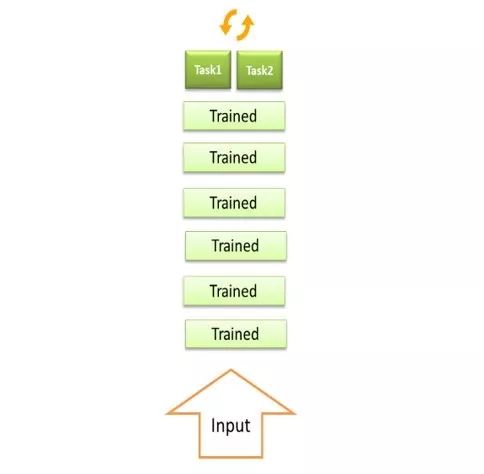

多任务学习的主要目标是通过使用多个任务的样本优化网络的参数改进任务的性能。例如,我们希望有一个网络可以根据输入的脸部图像区分是男性还是女性,同时可以预测这个人的年龄。这时,我们有两个相关的任务,一个是二分类,一个是回归任务。显然两个任务是相关的,对一个任务的学习可以改进另外一个任务。

一个简单的网络设计实例,可以在任务和任务之间共享一部分网络。共享部分学习任务通用的中间表达,有助于这些共同的学习任务。另一方面,针对特定的学习任务,特定的头部会学习如何使用这些共享表达。

对深度学习来说,迁移学习和多任务学习是两个重要的方法。

博客原址:https://www.linkedin.com/pulse/transfer-learning-vs-multitask-ibrahim-sobh/

更多文章,关注雷锋网(公众号:雷锋网)

添加雷锋字幕组微信号(leiphonefansub)为好友

备注「我要加入」,To be an AI Volunteer !

4 月 AI 求职季

8 大明星企业

10 场分享盛宴

20 小时独门秘籍

4.10-4.19,我们准时相约!

新人福利

关注 AI 研习社(okweiwu),回复 1 领取

【超过 1000G 神经网络 / AI / 大数据资料】

为什么吴恩达认为未来属于迁移学习?

▼▼▼