推理模型

·

近段时间,推理模型 DeepSeek R1 可说是 AI 领域的头号话题。用过的都知道,该模型在输出最终回答之前,会先输出一段思维链内容。这样做可以提升最终答案的准确性。

今天这篇文章将带你了解思维链(CoT)的相关研究和技术。

(图注)某些形式的推理技巧。

思维链(CoT)已经存在了相当长的一段时间。从技术上讲,它是一种高级提示工程。各种形式的 CoT 通常都是强迫大型语言模型进行推理。

2024 年 9 月,OpenAI 发布了其模型 o1 的预览版后,我们看到围绕 CoT 的炒作愈演愈烈。

除了 OpenAI,没有人完全知道 o1 是如何工作的,它是否是一个组合系统,用什么样的数据进行了微调,是否使用了强化学习,或者是否有几个模型在一起工作。

也许一个模型负责计划,另一个模型负责思考,第三个模型负责评分。但我们知道,它们都采用了某种逐步推理的方式。

关于这一点,已经有很多公开的研究。这篇文章将介绍现有的研究成果,让你知道自己可以使用什么。我也会对不同的技术进行测试,看看我们能否实现真正的改进。

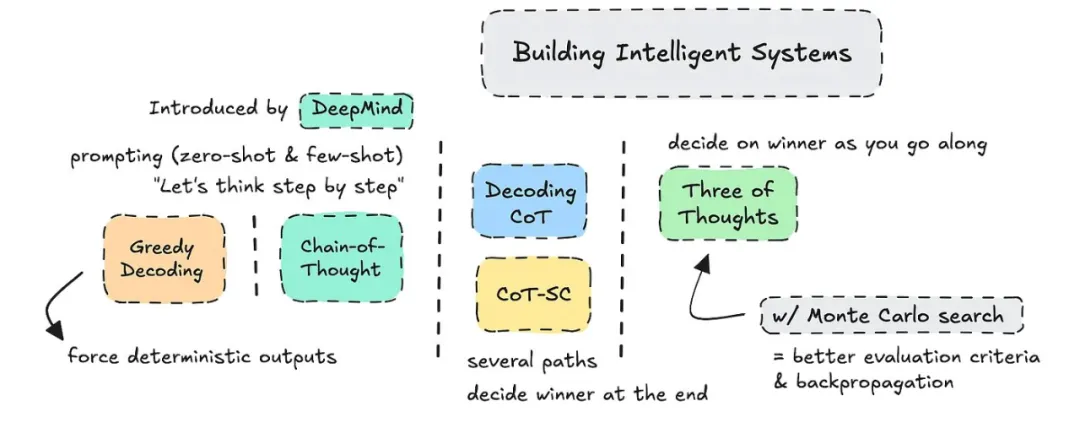

研究者们在过去两年中发表了很多论文。你可以在下图中看到他们所谈到的推理技术。

过去两年讨论较多的 CoT 技术。

大部分工作直接来自 DeepMind 或普林斯顿大学。为他们的开源工作点赞。

CoT 这个词是 DeepMind 在 2022 年提出的,只在提示中使用。最新的论文探索了结合蒙特卡洛搜索(Monte Carlo Search)和无需提示的 CoT 的「思维树」(ToT)。

接下来将介绍简单的思维链 (CoT)、CoT链、贪婪解码、CoT-SC、解码 CoT 以及结合蒙特卡洛树搜索的「思维树」。

成为VIP会员查看完整内容

相关内容

Arxiv

79+阅读 · 2023年4月4日

Arxiv

142+阅读 · 2023年3月29日

Arxiv

83+阅读 · 2023年3月21日