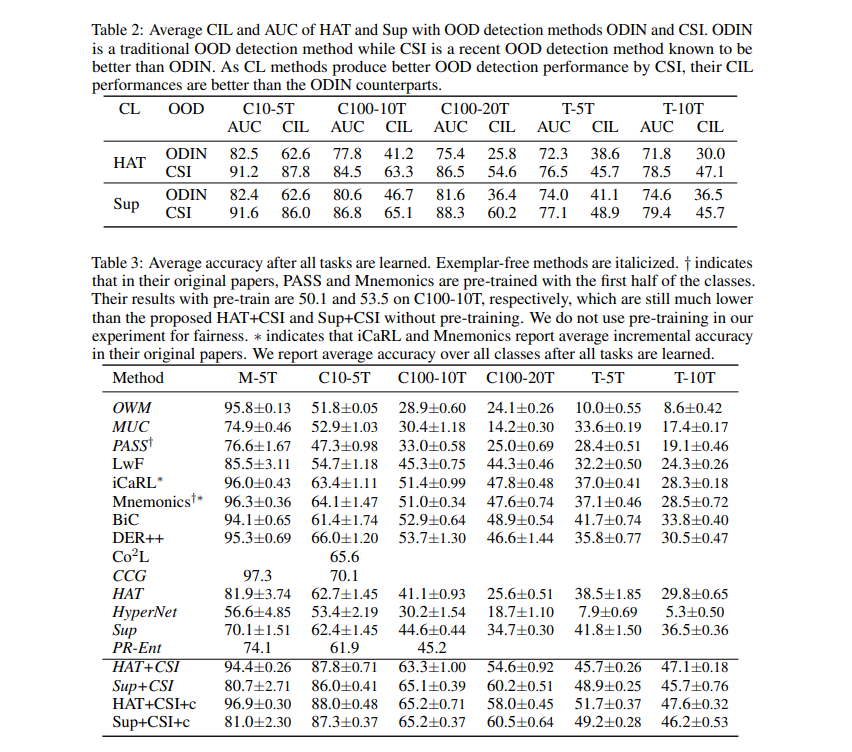

持续学习(CL)循序渐进地学习一系列任务。有两种流行的CL设置,类增量学习(CIL)和任务增量学习(TIL)。记忆的一个主要挑战是灾难性遗忘(CF)。虽然有几种技术可以有效地克服TIL的CF,但由于任务间类分离的额外困难,CIL仍然具有挑战性。到目前为止,很少有理论工作为解决信息网络问题提供原则性指导和充分必要条件。本文就进行了这样的研究。该方法首先将任务信息信息问题概率地分解为两个子问题:任务内预测(WP)和任务ID预测(TP)。进一步证明TP与分布不均(OOD)检测相关。关键的结果是,无论一个CIL算法显式或隐式地定义了WP和TP或OOD检测,良好的WP和良好的TP或OOD检测对于良好的CIL性能都是必要和充分的。此外,TIL就是WP。基于理论结果,还设计了新的CIL方法,在CIL和TIL设置下,其性能都大大优于强基线。

https://arxiv.org/pdf/2211.02633.pdf

成为VIP会员查看完整内容