摘要—脑电图(Electroencephalography,EEG)是最常用于捕捉大脑电活动的信号之一,而对脑电信号进行解码以获取用户意图,一直是脑–机接口(Brain–Computer/Machine Interfaces,BCIs/BMIs)研究的前沿课题。与传统的基于机器学习的脑电分析方法相比,深度学习方法的兴起逐步变革了该领域,通过端到端的长链式架构,实现了更具判别力的特征自动学习。在众多深度学习方法中,Transformer 凭借其基于注意力机制处理序列数据的强大能力,近年来在各类 EEG 处理任务中的应用日益广泛。 本文围绕该方向展开综述,系统总结了 Transformer 模型自提出以来在 EEG 解码中的最新应用进展。我们首先梳理了 Transformer 的基本原理及其在 EEG 解码中的直接应用,随后介绍了其与其他深度学习技术(如卷积/循环/图/脉冲神经网络、生成对抗网络、扩散模型等)融合构成的常见混合架构。我们也回顾了在 EEG 解码任务中采用改进型定制 Transformer 结构的研究进展。最后,文章讨论了该快速发展领域当前面临的挑战与未来发展前景。 本综述旨在帮助读者清晰了解 Transformer 在 EEG 解码中的应用现状,并为今后的研究工作提供有价值的参考与启发。 关键词—脑电解码,特征融合,Transformer,卷积神经网络,信号处理。

I. 引言

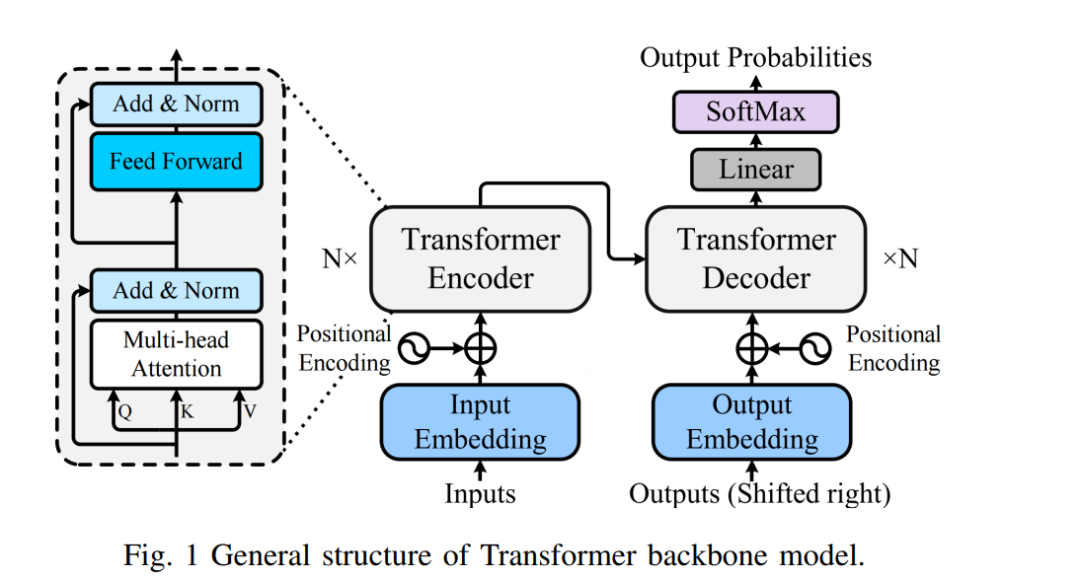

作为一种将人类思维直接与外部设备连接的前沿技术,脑–机接口/脑–机系统(Brain–Computer/Machine Interfaces, BCIs/BMIs)近年来在康复工程与非医疗领域中日益受到关注 [1], [2]。其中,非侵入式的脑电图(Electroencephalography, EEG)通过在头皮上布置电极记录大脑皮层神经元的活动,具备毫秒级的时间分辨率,可用于追踪大脑活动的快速变化,因此在 BCI 中得到广泛应用 [3]。因此,如何高效地解码 EEG、识别用户潜在意图,成为 BCI 系统中的核心问题,其基本流程包括信号采集、预处理、特征提取与分类等步骤。 传统上,这些过程通常依赖于机器学习方法。研究人员需要手动从原始 EEG 信号中提取三个主要维度的特征:频域、时域与空间域,常用方法包括共空间模式(CSP)、快速傅里叶变换(FFT)与小波变换等,随后将特征输入支持向量机、随机森林、线性判别分析等监督分类器,或 K 近邻(KNN)等无监督方法进行解码与识别。然而,这类手工特征工程高度依赖专家经验,过程复杂且耗时。 相比之下,近年来深度学习(Deep Learning, DL)方法因其强大的自动特征提取与表示学习能力,在 EEG 解码中取得了显著成功。DL 的基本思想源自类脑的分层结构,其深层架构能够逐层提取更抽象且具判别力的特征。当前已有多种 DL 方法成功应用于 EEG 解码任务,例如卷积神经网络(CNN)、循环神经网络(RNN)、长短时记忆网络(LSTM)以及迁移学习等。然而,许多上述模型在处理非平稳 EEG 信号的复杂时序模式与高维特征空间方面仍存在难以并行建模的挑战。 作为另一类经典深度学习架构,Transformer 由 Google 于 2017 年提出,用于变革序列建模任务 [4]。其核心创新是多头注意力机制(Multi-Head Attention, MHA),可以评估输入序列中各元素之间的关系并赋予不同的权重,从而使模型能够捕捉 EEG 信号中存在的复杂时空依赖关系。Transformer 中引入的位置编码(Positional Encoding)有助于保留时间位置信息,对理解 EEG 不同时段间的关系至关重要;而多头机制还可在不同子空间中并行处理信息,从而提升了模型的表达能力与效率。综上,Transformer 架构具备并行性、可扩展性与灵活性,已在多个领域展现出广阔前景 [5]。自 2019 年起,该架构已逐步应用于脑电语音识别 [6]、癫痫检测 [7]、脑电分类等任务 [8],并取得重要进展,引发新一轮脑电解码研究热潮。 尽管近年来围绕 Transformer 的 EEG 解码研究数量持续增长,已有接近 200 篇相关论文发表,但尚缺乏系统性的综述文章来梳理其技术演进趋势。Chen 等人 [9] 曾报道 Transformer 在脑科学中的基础应用,强调其在脑疾病诊断、脑龄预测与异常检测等领域的广泛潜力;Abibullaev 等 [10] 对其在 BCIs 中的基本原理、优势与挑战进行了总结;另有研究 [11] 探讨了数据稀缺与数据增强在 Transformer 式 BCI 系统中的关键作用。但据我们所知,当前尚无针对 EEG 解码中 Transformer 架构演化与变种的详尽综述。在该方向爆发式发展的背景下,系统总结最新进展的需求尤为迫切,这正是我们撰写本文的动因。

**A. 贡献与综述概览

我们从 IEEE Xplore、ScienceDirect、Web of Science、Google Scholar 及 arXiv 等数据库中检索了相关文献,检索截止日期为 2025 年 6 月 29 日,关键词包括 “Electroencephalogram/EEG”、 “Transformer/vision transformer/ViT/self-attention/multi-head attention”、以及 “decoding/classification/detection/recognition”。我们筛选时采用以下标准: * 排除主要聚焦非 EEG 信号(如 EOG、EMG)的研究,除非涉及多模态方法; * 排除仅在标题/摘要中提及 Transformer,但正文无关或缺乏创新方法的研究; * 排除设计不明确、实验分析不足或缺少对比实验的工作; * 优先保留使用多个标准数据集进行验证的有代表性研究。

最终,我们筛选并整理了自 2020 年以来约 165 篇与 EEG 解码中 Transformer 应用相关的论文,以全面总结与深入分析该领域的最新进展。本文的主要贡献包括: 1. 提供迄今最全面的综述,系统梳理 Transformer 模型在 EEG 解码领域的适用性,厘清其技术演进脉络,激发潜在研究者关注; 1. 对 Transformer 在 EEG 处理中的不同变种进行分类:包括基础模型、与其他深度学习技术的融合模型、以及结构改造后的定制 Transformer,并首次系统整理定制化结构的细分类别,提供清晰的研究切入点; 1. 详细讨论当前面临的挑战与未来方向,重点分析特定任务与数据集背景下的应用模型,促进对该领域发展的辩证性思考,助推研究社区繁荣发展。

**B. 文章结构

针对分类、生成、去噪等多种 EEG 解码任务,Transformer 模型的应用形式主要包括三类: * 基础模型(Backbone Models):直接使用原生 Transformer; * 混合模型(Hybrid Models):与其他深度学习模型(如 CNN、RNN 等)融合; * 定制模型(Customized Transformer):对 Transformer 内部结构进行修改优化。

据此,本文结构安排如下: * 第 II 节介绍 Transformer 基础知识及其在 EEG 解码中的直接应用; * 第 III 节按模型演化路线回顾 Transformer 与其他深度学习模型融合的混合架构; * 第 IV 节系统总结结构定制型 Transformer 网络; * 第 V 节讨论当前面临的挑战与未来研究方向; * 第 VI 节对全文进行总结。