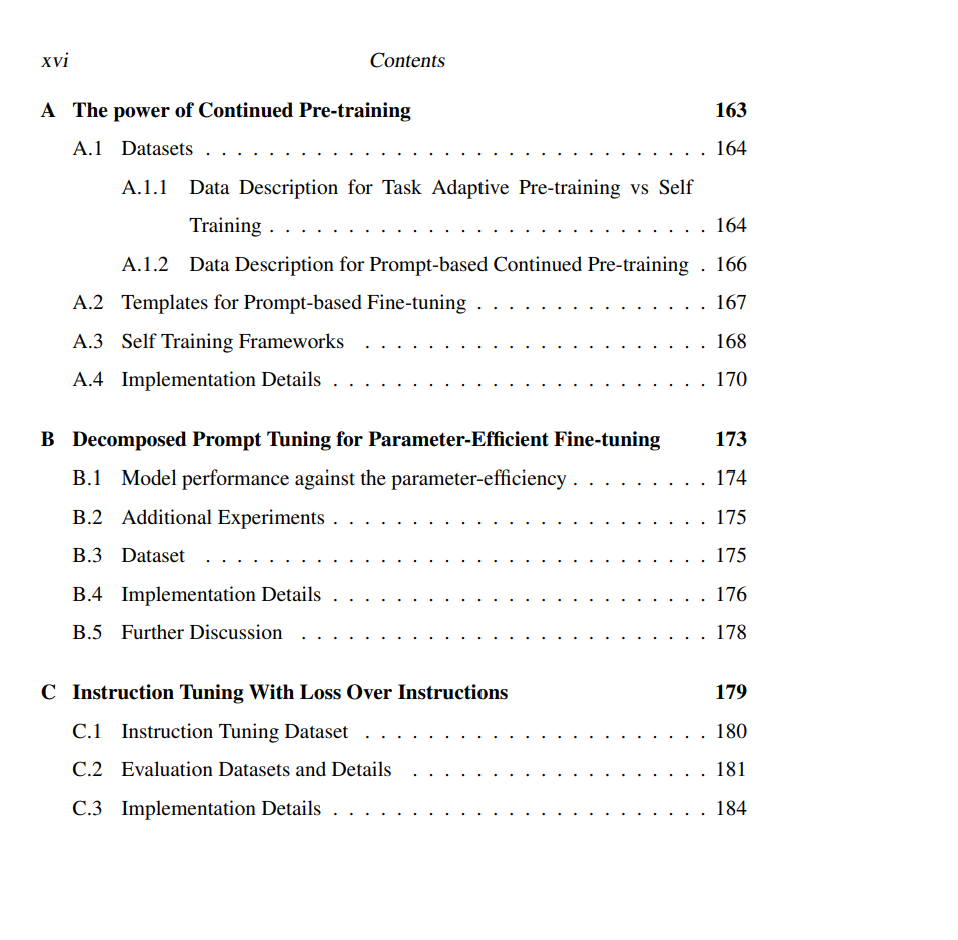

语言模型(Language Models, LMs)在自然语言处理(NLP)任务中展现出了卓越的能力,然而要将其潜力充分释放到具体应用中,仍面临诸多挑战。随着模型规模与复杂度的不断增长,如何高效且稳健地对其进行适配变得愈发困难。目前主流的方法通常是在带标签数据上进行微调(fine-tuning),但该范式往往难以有效利用大量可获取的无标签数据,容易在任务特定的小规模数据集上产生过拟合,并且伴随着高昂的计算开销。这些限制在现实世界中尤为突出——语言任务与领域的边界常常是开放且动态变化的。 本论文围绕如何将语言模型更有效地适配于下游任务,提出了一系列创新方法,旨在从后训练(post-training)的视角解决模型适配过程中的关键难题。首先,我们研究了在标签资源有限的情况下最大化无标签数据利用的策略,目标是从无标签数据中提取与任务相关的知识,以提升模型在特定任务上的表现,并实现更鲁棒的任务对齐。相关研究促成了新型的持续预训练(continued pre-training)技术,其性能优于现有的半监督学习方法。 接着,我们提出了一种新的参数高效微调方法,该方法显著降低了微调语言模型所需的内存与时间成本,从而在保持竞争性性能的同时,使得微调过程更加高效与可行。此外,我们还改进了有监督微调策略,以增强模型的指令跟随能力,尤其适用于学习资源受限的情境。这一改进使语言模型在各类 NLP 任务中表现更为出色,特别是在开放式生成任务中,进一步提升了其实用性与灵活性。 为了更好地理解与评估模型在特定下游任务上的适应能力,我们还构建了新的评测基准与评估方法。其中包括用于测试复杂认知能力(如多跳空间推理)的测评工具,提供了更全面、细致的评估维度。 通过在多种 NLP 任务上的广泛实证评估,我们的研究表明:所提出的方法显著提升了语言模型在多任务环境中的鲁棒性、效率与泛化能力。本文提出的方法代表了迈向更强大、更高效语言模型的重要一步,也为实现通用人工智能(Artificial General Intelligence, AGI)带来了切实进展。