ChatGPT的出现开启了AGI之门。深度强化学习自AlphaGo成功就是认为是通用人工智能的核心技术。 DeepMind研究科学家Jack Parker-Holder在牛津大学的博士论文《迈向真正开放式强化学习》对此探究解答,217页pdf

Jack Parker-Holder是DeepMind开放式团队的一名研究科学家。对设计永不停止产生新的、有趣的东西的系统很感兴趣。特别是,我想设计和构建开放式系统,不断提出新的问题供RL智能体解决,最终产生一个具有普遍能力的智能体。关于我在DeepMind的工作。 在加入DeepMind之前,Jack Parker-Holder是牛津大学圣彼得学院的一名博士生,在那里我是机器学习研究小组的成员,由Stephen Roberts担任顾问。 https://jparkerholder.github.io/

摘要****在过去的十年中,深度强化学习(RL)在游戏、机器人甚至核聚变等实际问题中取得了一些显著的成功。确实,考虑到其普适性,该领域的许多知名研究人员认为RL本身足以产生通用人工智能(AGI)。很容易看出,RL在理论上是一个开放的过程,其中智能体从其自身的经验中永远不会停止学习,只要给定一个适当复杂的环境。在本论文中,我们认为限制RL智能体的关键因素是需要静态的、由人类设计的配置。在智能体方面,我们通常针对特定智能体和特定架构调整一组超参数,忽略了它们可能需要随时间而适应的事实。同时,即使我们拥有强大的RL智能体,我们也缺乏足够复杂的环境,可以促进通用行为的学习。

我们假设解决这个问题的唯一方法是拥抱开放性,通过设计具有无限能力来产生新的、有趣的东西的系统。在第一部分中,我们介绍了使用一组智能体动态自适应几个重要智能体超参数的新方法。这使得智能体有可能随着时间的推移自适应几个超参数。本文介绍一种自动设计环境的新方法,发展一门课程,不断在学生代理的能力前沿提出新的挑战。将这两项进展结合起来,可以产生一个开放式的学习系统,其中智能体和环境随着时间的推移共同适应,产生越来越复杂的问题和可以解决这些问题的智能体。

然而,即使这也不是真正开放式的,因为一旦智能体可以解决人类指定分布的每个任务,它最终将停滞不前。在论文的第二部分,我们提出了使该系统无界的方向。介绍了两种新方法,以鼓励发现多样化的解决方案,可以帮助避免欺骗性的局部最优,并发现更广泛的行为集。通向真正开放式系统的一条路径是完全消除对人类设计的模拟环境的需要,而是在学习的世界模型中训练智能体。讨论了该领域的一些贡献,包括改进世界模型的主动数据采集,以及在世界模型中产生合成经验的方法,提高了智能体的鲁棒性。最后,提出了一个结合这些见解的未来系统的建议,我们相信这可能是真正开放式的。

1.1 对于通用人工智能来说,奖励足够了吗?

强化学习(RL, Sutton & Barto[290])是一种范式,智能体完全从环境中的自身交互中学习,以最大化预期累积奖励。这与机器学习中的其他设置不同,因为智能体可以学习规划和推理,以便采取具有长期后果的行动。理论上,智能体从自身经验中学习的能力是没有限制的,因此强化学习为开放式学习提供了潜力。在过去的十年中,RL与深度神经网络的结合[87,144,252]带来了一系列显著的成就。所谓的深度RL智能体的第一个重大胜利是当研究人员表明,仅从像素[190]就可以学习以人类水平玩Atari游戏时。其他的成功接踵而至,比如AlphaGo打败了世界上最好的围棋选手之一[271],而RL也被证明有能力在电子竞技游戏中与人类竞争[22,312]。强化学习不仅在游戏中产生了重大影响,在机器人领域,强化学习已被用于从模拟迁移到现实世界[7,118,209,226,298],并用于从大型数据集[126,166]进行训练。近年来,强化学习甚至对其传统领域之外的领域产生了影响,例如在现实世界中导航[19]或控制血浆[53]。随着该领域的快速进展,有可能进一步推断并考虑未来可能使用RL的情况。强化学习已经显示出为人类研究了几个世纪的问题找到全新解决方案的能力,例如AlphaGo在与李世石的第二场比赛中著名的“第37步”。事实上,考虑到它的通用性,该领域的一些最杰出的研究人员认为,仅RL可能就足以产生通用人工智能(AGI)[274]。在本文中,我们将从表面价值出发,并专注于使用RL生产普通智能体所需的缺失成分。此外,本文寻求建立研究方向,当解决时可以弥补这一差距。在我们开始研究未来的研究方向之前,我们需要(简要地)澄清我们提到AGI时的意思。首先要说明的是,智能有许多可能的定义[90,157],本文的目标不是提出一个新的定义。本文更多地是作为一种指导,而不是一个特定的目标,从Hutter[110]和Legg & Hutter[158]开创的工作中获得灵感,他们最初提到了智能体π的普遍智能。具体来说,Legg & Hutter[158]提出了以下定义:

或者非正式地说:“智能衡量智能体在广泛环境中实现目标的能力”。这里,“广泛的环境”由E表示,从智能体的角度来看,所有定义良好的奖励可求和环境的空间由K反向加权,K是用于描述环境的二进制字符串的Kolmogarov复杂度[139]。智能体π的成功由价值函数V π μ表示,我们将在2.1节中更严格地定义它。 以这种方式查看AGI的好处是,它不再是一个二进制标签,而是一个连续的值范围。因此,我们可以通过增加方程1.1的值,在AGI方面取得进展,无论它可能有多远。那么,对于当前的RL方法来说,这可能是什么样子的呢?很明显,虽然我们取得了巨大的成功,但其中许多都是更狭隘的AI形式,例如解决个人游戏。此外,许多智能体未能泛化到其环境[45,136,214]中的微小变化,经常过度拟合训练环境的特定组件[276,339]或在环境中起作用的其他智能体[106]。因此,要增加公式1.1的值,我们必须专注于增加智能体可以解决的任务的多样性,使智能体对环境的变化以及其他智能体的变化具有鲁棒性。

下一个问题是我们如何使用RL实现这一点?如果我们更仔细地观察Silver等人[274],作者推测:“当强大的强化学习智能体被置于复杂环境中时,在实践中将产生复杂的智能表达。如果这个猜想是正确的,它为实现人工通用智能提供了一个完整的途径。”因此,我们可以清楚地看到这里的问题——我们还没有“强大的强化学习智能体”或“复杂环境”,或两者的定义。

本文认为,用RL实现更通用的智能体的关键限制因素是依赖特定的手工编码智能体和环境配置,这些配置缺乏随时间增加其复杂性的能力。如果我们在简单的问题上训练我们的智能体,那么我们可以快速实现精通,但最终达到方程1.1中的低值。然而,将智能体置于高度复杂的环境中使学习具有挑战性[100]。相反,我们认为,实现具有普遍能力的智能体的可能路径是一个从简单配置开始的系统,但使它们有可能随着时间的推移自动变得更复杂。为实现这一目标,本文提出了一些方法来自动发现越来越具有挑战性的问题,让智能体来解决,同时也引入了一种方法,让智能体自适应解决这些问题。这就是开放性的问题。

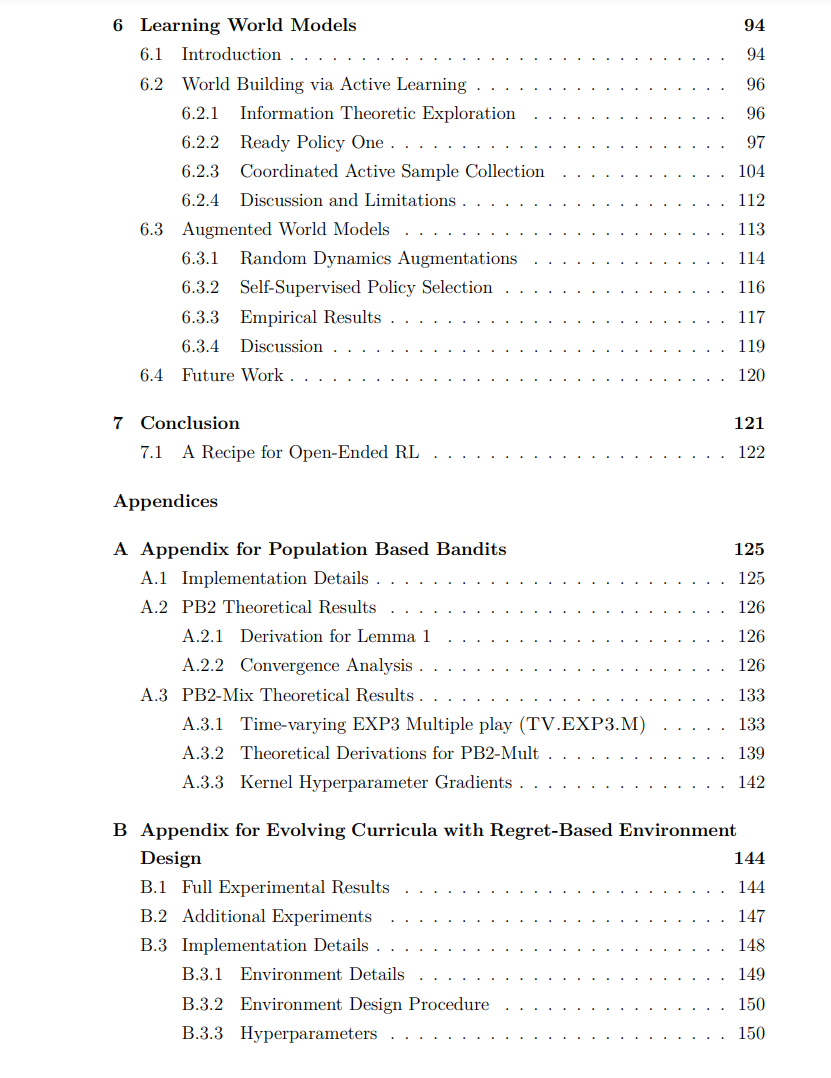

1.2 论文结构

首先,回顾了深度强化学习和自动化未指定组件的方法的必要背景材料,称为自动强化学习或AutoRL。我们包括了以下调查中的许多细节: Jack Parker-Holder , Raghu Rajan , Xingyou Song , André Biedenkapp, Yingjie Miao, Theresa Eimer, Baohe Zhang, Vu Nguyen, Roberto Calandra, Aleksandra Faust, Frank Hutter, Marius Lindauer Automated Reinforcement Learning (AutoRL): A Survey and Open Problems JAIR, 2022

第一部分:自动强化学习

在这一部分,我们做了以下贡献:

提出了基于群体的Bandits(PB2),一种用于在单次训练运行中动态学习和适应智能体配置的算法。

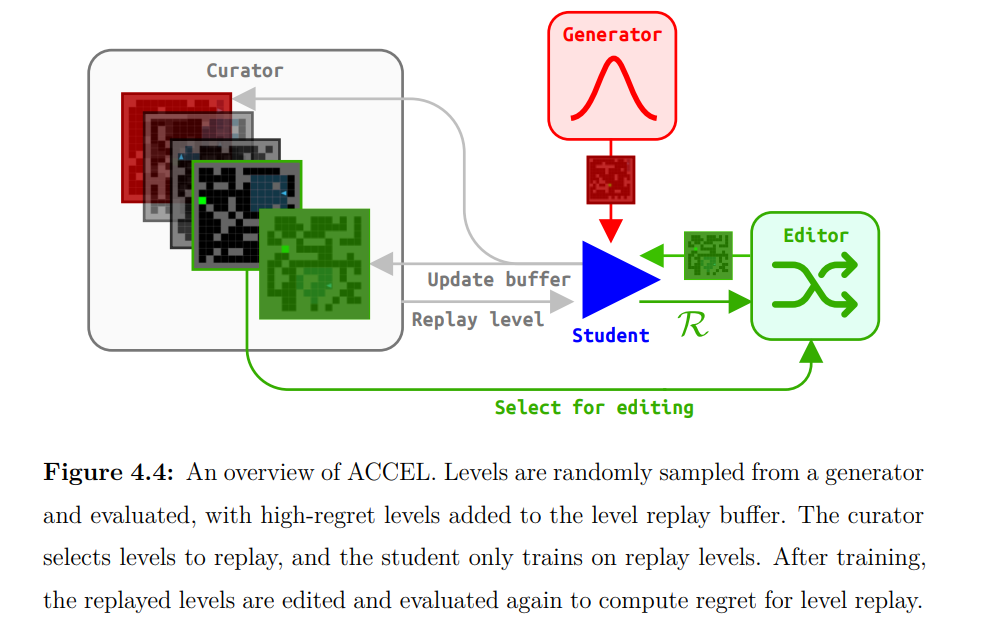

提出一种新方法来进化自适应课程,能够在给定的任务分配中产生鲁棒的多面手智能体。

本文假设,使强化学习系统更开放的重大改进是通过自动发现和适应系统超参数的大型组件。本文将这个问题分解为两个支柱:智能体调整自己,环境不断提出新的挑战。在第3章中,我们首先专注于开发可以在一次训练中动态学习和适应其配置的大部分组件的智能体。我们相信,这可以带来永不停止学习的强大强化学习智能体。接下来,在第4章中,我们将讨论进化训练环境的自适应分布的方法。正如所示,这使得自动发现导致发现复杂环境的课程成为可能,同时训练一个可以解决这些问题的智能体。在第一部分的结尾,我们讨论了将这两个组件组合成一个共同进化的[26]系统的可能性,在这个系统中,环境变得越来越具有挑战性,智能体适应解决它们。请参阅下面的更具体的贡献列表。

第二部分:实现开放性

这一部分包括以下贡献: 1. 本文提出两种新的算法来发现不同的解决方案,通过行为(DvD)和基因型(Ridge Rider)多样性。

2. 本文提出新的信息论方法来收集数据,以产生有效的世界模型,受主动学习的启发。

结合第一部分中的方法,应该会产生一个强大的协同进化系统,在这个系统中,环境不断向能够适应解决这些问题的智能体提出困难的挑战。然而,正如我们所指出的,仅靠这一点可能不足以实现开放性,它很可能会汇聚到单一的解决方案和单一的环境分布。此外,这种解决方案甚至可能不是最优的,因为在许多情况下,直接优化无法找到最强大的行为[268,325]。论文的第二部分更具有推测性,再次分为两章,每一章都提出了一个可能的方向,使我们的强化学习训练系统无界。在第5章中,我们首先会介绍一些方法,通过鼓励发现更广泛的创造性行为,甚至是意想不到的行为,来促进学习动态的多样性。第6章要克服的最后一个障碍是对人类设计的模拟环境的依赖,我们建议在世界模型中训练智能体,直接从数据中学习。这本质上为“AI生成算法”[42]提供了足够的基础,它可以充分学习自己的环境,同时学习RL算法和配置来解决它们。