生成式人工智能在多个模态(如视觉与语言)中取得了生成高保真输出的显著进展。然而,一个关键挑战仍未解决:我们如何将这些模型引导向特定属性的输出,而不仅仅是复现训练数据中的模式?**奖励引导生成(reward-guided generation)**通过使模型输出对用户定义的奖励函数保持一致,为这一问题提供了解决路径。该方法不仅增强了生成过程的定制性和个性化,还为强化学习、优化和生物设计等领域打开了新的可能性。

要充分释放奖励引导生成的潜力,理解其理论基础与方法论至关重要。本论文提出了一份具有理论支撑的研究路线图,旨在推动奖励引导生成建模的发展,具体包括:(1) 构建对奖励条件生成的理论理解;(2) 设计在经验上表现优异的新算法;(3) 识别并解决现有方法中的关键缺陷,从而提升其可靠性。

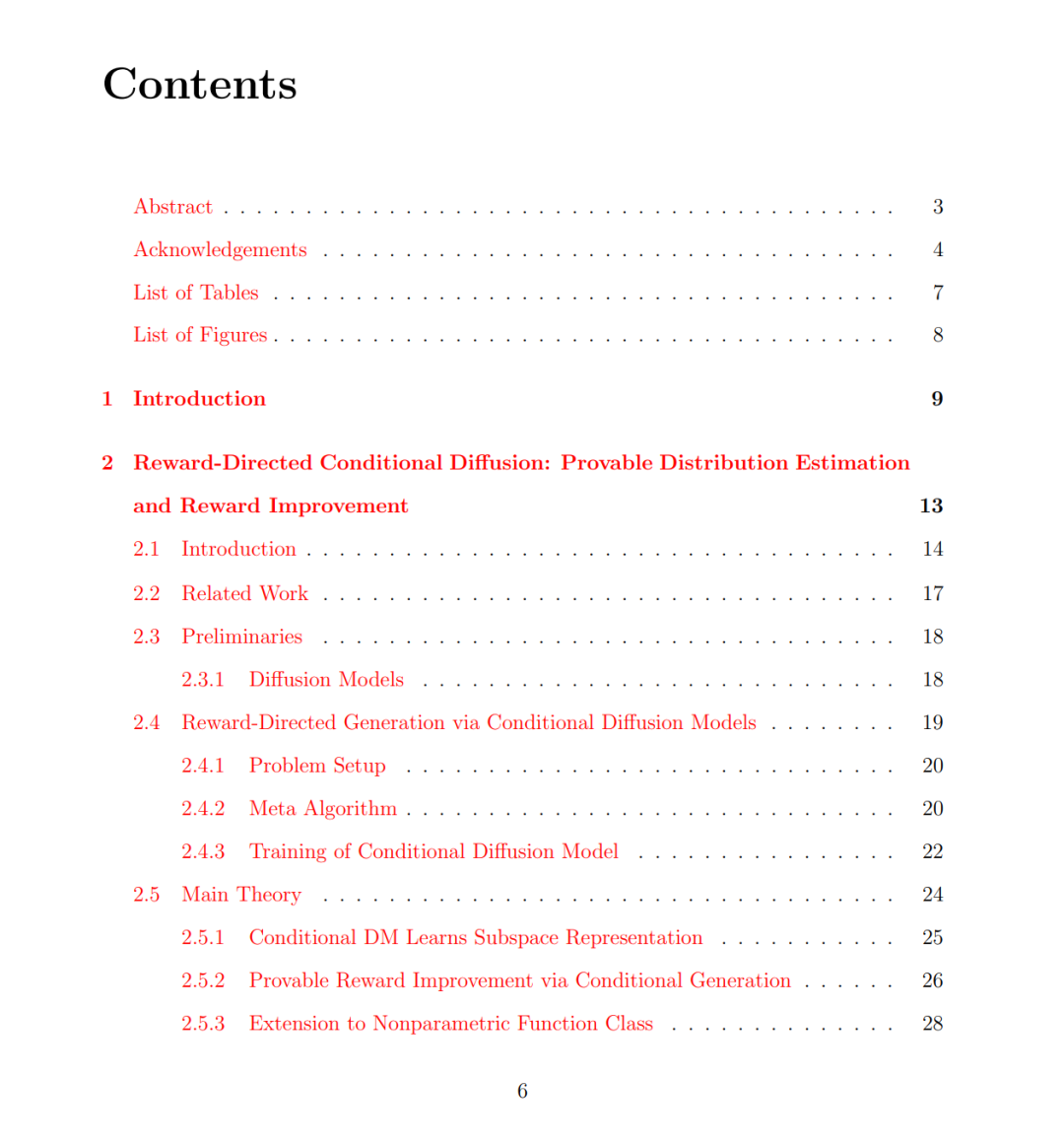

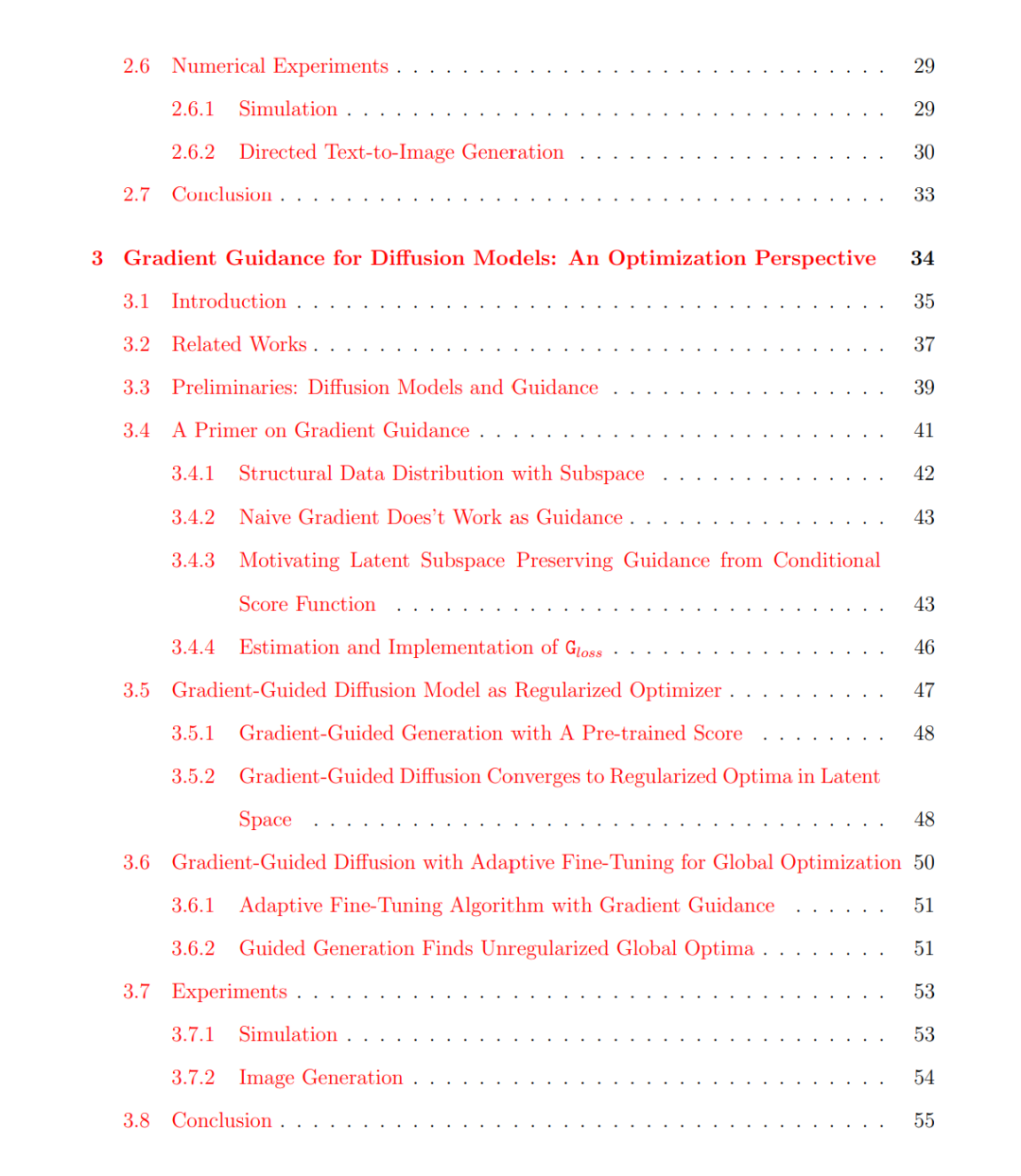

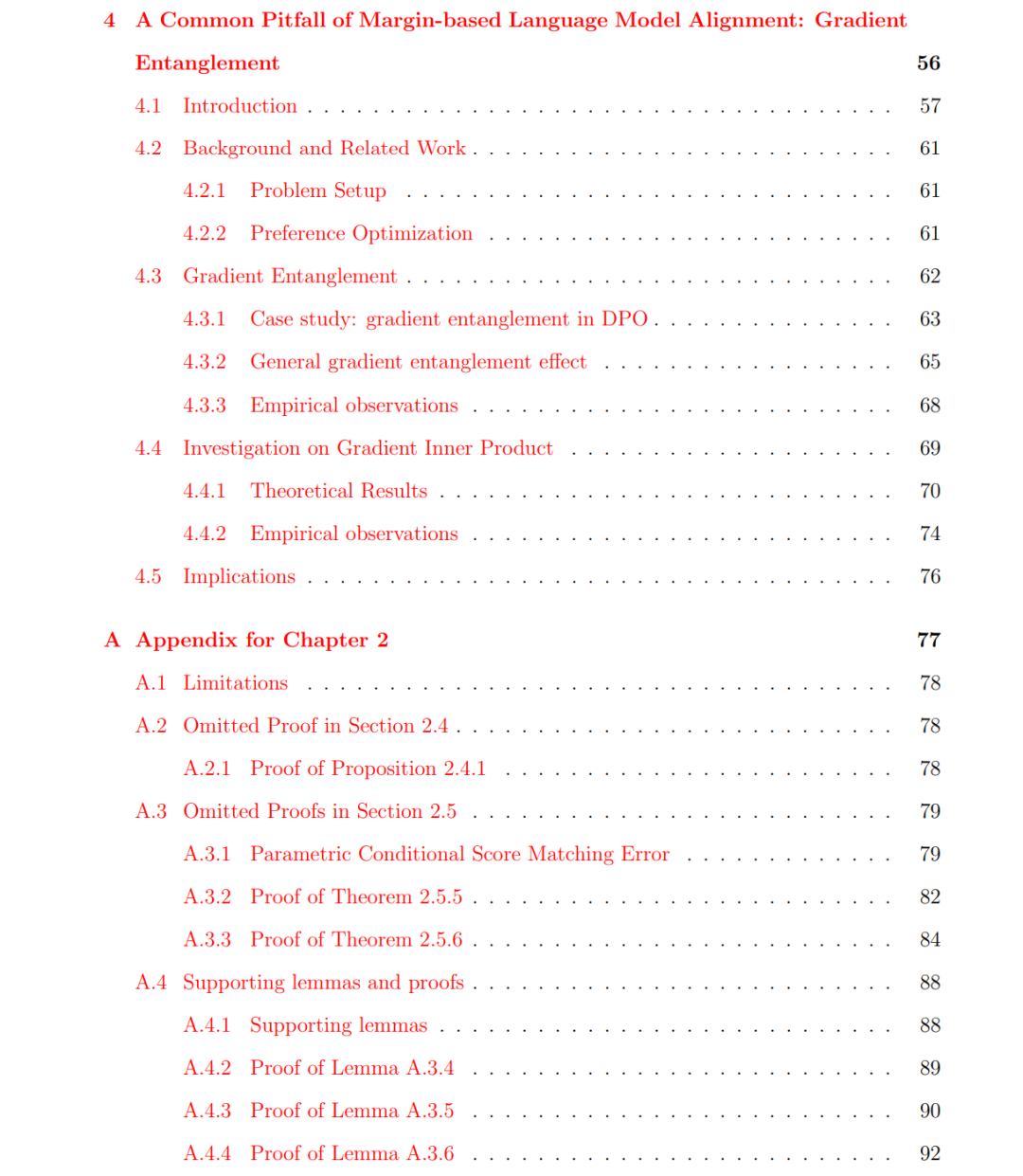

为此,第 2 章分析了奖励条件扩散模型(reward-conditioned diffusion models),解释了外部信号如何塑造生成样本的结构及其对应的奖励值。第 3 章提出了一种用于扩散模型的基于梯度的引导方法,该方法在保持对原始数据流形的忠实度的同时,有效融合外部信号。我们对其收敛性进行了分析,展示了预训练模型与奖励信号之间的交互如何既保留了样本质量,又增强了生成控制力。第 4 章研究了大语言模型在基于间隔对齐(margin-based alignment)中的梯度纠缠问题(gradient entanglement),指出过度依赖“偏好输出”与“不偏好输出”之间的对数似然间隔,可能会无意中放大不良响应、压制良好响应,凸显出更明确、解纠缠的奖励目标设计的重要性。

本论文以严谨理论为支撑,并将其凝练为实用算法,推动了奖励引导生成建模的研究,为构建更可控、更具适应性、更可靠的生成模型奠定了坚实基础。