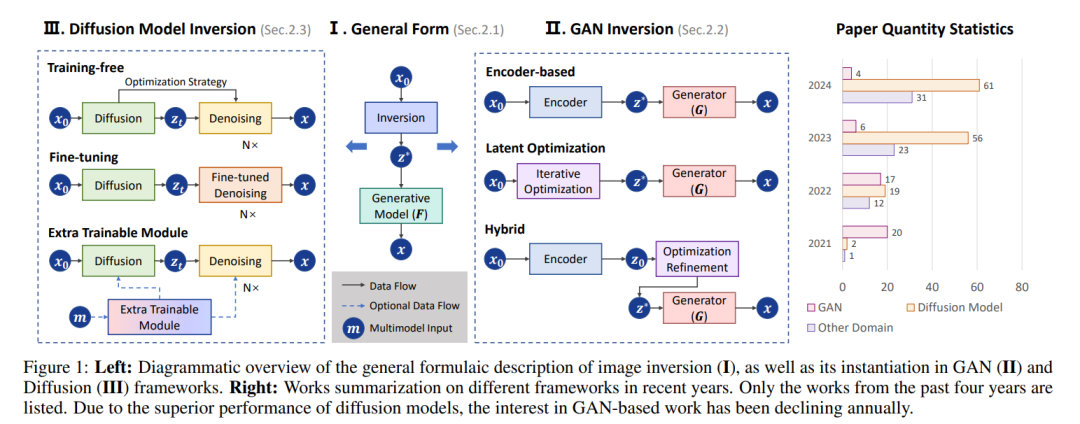

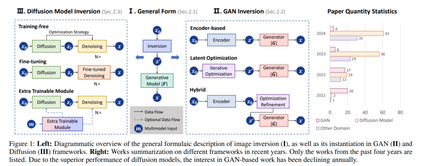

图像反演是生成模型中的一个基础任务,旨在将图像映射回其潜在表示,以支持下游应用,如图像编辑、修复和风格迁移。本文全面综述了图像反演技术的最新进展,重点讨论了两种主要范式:生成对抗网络(GAN)反演和扩散模型反演。我们根据优化方法对这些技术进行分类。对于GAN反演,我们系统地将现有方法分为基于编码器的方法、潜在优化方法和混合方法,分析其理论基础、技术创新和实际权衡。对于扩散模型反演,我们探讨了无训练策略、微调方法以及附加可训练模块的设计,重点讨论它们的独特优势和局限性。此外,我们讨论了几种流行的下游应用以及超越图像任务的新兴应用,识别了当前的挑战和未来的研究方向。通过整合最新的研究成果,本文旨在为研究人员和实践者提供一个有价值的参考资源,推动图像反演领域的进一步发展。我们将持续跟踪最新的研究工作,

网址:https://github.com/RyanChenYN/ImageInversion。

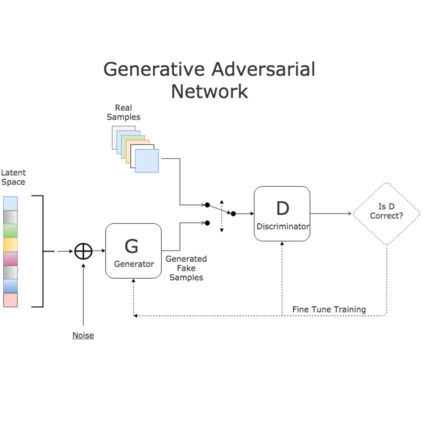

https://arxiv.org/pdf/2502.119741 引言图像反演是指将给定图像映射回预训练生成模型的潜在表示的任务。这一任务在图像编辑、风格迁移、图像修复等应用中具有重要意义 [Xia 等,2022;Shuai 等,2024]。通过反演技术,用户可以有效利用生成模型的丰富语义信息,实现对真实图像的高效控制和修改,成为一个日益独立且活跃的研究方向。早期的图像反演研究始于生成对抗网络(GAN)的兴起 [Zhu 等,2016],主要集中于如何将图像投影到GAN的潜在空间中,以便于后续的图像编辑和生成任务。StyleGAN系列的问世 [Karras 等,2019;Karras 等,2020] 显著提高了图像反演技术的准确性和效率。然而,这些方法存在一定的局限性 [Tov 等,2021;Roich 等,2023;Zhang 等,2024c]:基于编码器的前向方法仍然会导致次优结果,而基于优化的方法则需要大量时间,且未能满足一般图像编辑和高精度应用的需求,例如肖像摄影。近年来,扩散模型凭借其强大的生成能力和稳定的训练过程,逐渐成为生成模型领域的新宠。从DDPM [Ho 等,2020] / DDIM [Song 等,2020] 到LDM [Rombach 等,2022],像Stable Diffusion系列这样的开源模型显著增强了图像编辑的可控性和有效性,推动了许多优秀的无训练和微调解决方案的出现 [Miyake 等,2023;Chung 等,2024;Mo 等,2024]。最近的突破性进展,如DiT [Peebles 和 Xie,2023] 框架和流匹配技术,为图像反演提供了新的思路和方法。GAN到扩散模型的多样化发展,也为高保真度图像反演任务和复杂场景中的可控编辑应用奠定了基础。本文系统地回顾并总结了这些技术的发展轨迹,从公式化的角度抽象定义了问题,深入探讨了不同类别方法的原理和实际问题。全面覆盖了图像反演及相关子领域,并提供了深入的讨论。范围本文重点讨论了两种主要的图像反演框架:GAN反演和扩散模型反演。对于GAN反演,我们从三个角度进行全面分析与比较:基于编码器的方法、潜在优化方法和混合方法。对于扩散模型反演,我们从训练角度将方法分为无训练方法、微调方法和额外可训练模块方法,并讨论每种方法的优缺点。此外,我们还分析了最新的技术趋势,如基于DiT的反演方法 [Feng 等,2024],并探讨了反演技术在图像及更广泛领域(如视频 [Fan 等,2024] 和音频 [Manor 和 Michaeli,2024])中的应用。本文主要分析了2021年以后的研究,以确保其相关性和前瞻性。由于篇幅限制,本文仅讨论了具有代表性的工作,最新的、持续更新的研究成果可通过该项目页面获取。与相关综述的讨论与现有的综述文章相比,例如专注于早期基于GAN的方法 [Xia 等,2022],以及近期专注于基于扩散的方法的工作 [Shuai 等,2024],本文将GAN反演和扩散模型反演整合到一个统一框架中进行系统比较,填补了该领域的研究空白。并且,本文将反演讨论扩展到非图像应用,为读者提供了更全面的视角。贡献首先,本文提供了对图像反演领域最新进展的全面回顾,涵盖了两种主要生成模型(GAN和扩散模型)的关键反演技术。通过系统地分类这些方法,我们揭示了内在的联系和技术差异,为研究人员提供了清晰的理论指导。其次,本文从图像级别的角度讨论了主要应用及相关领域的进展。最后,我们总结了当前研究中的主要挑战,并提出了一系列潜在的未来研究方向,为图像反演领域的进一步发展提供了重要参考。