1 引言

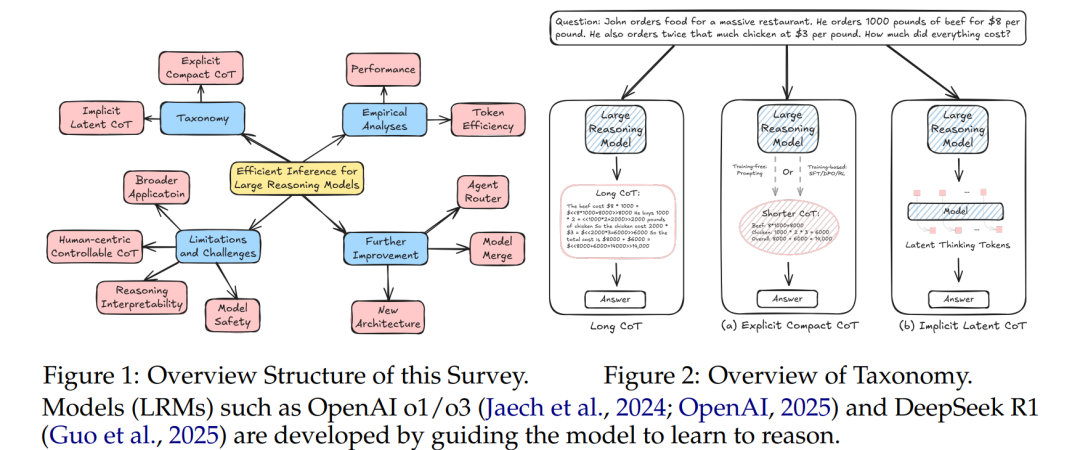

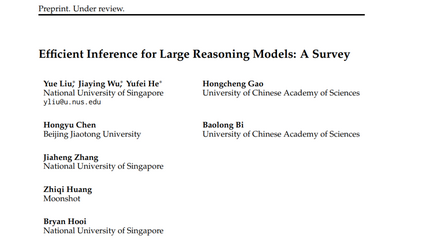

大语言模型(LLMs)经过训练,能够提供快速直观的回应,在各种快速思考的应用中取得了巨大成功,例如聊天机器人(OpenAI,2022)。与此不同的是,数学问题求解(奥林匹克,2025)或研究(OpenAI,2025a)等慢思考场景要求模型在提供最终回应之前进行分析性和深思熟虑的推理。为了解决这些挑战,尽管大规模推理模型(LRMs)非常有效,但其中间推理过程非常消耗资源,面临三大挑战:(1)显著的令牌消耗,(2)较高的内存开销,以及(3)推理时间的增加。这些问题不仅增加了服务公司推理的成本,还降低了用户的体验。因此,为 LRMs 提供高效推理已经成为一个紧迫且至关重要的方向。由于思维令牌被视为与常规输出令牌相同而没有成本区分,之前关于常规 LLMs 推理效率的研究,例如模型压缩(Wang et al., 2024b)、高效模型设计(Nie et al., 2025)和系统级优化(Liu et al., 2024a),可以缓解问题(2)和(3)。这些方法已被广泛研究(Zhou et al., 2024),但并未专门为 LRMs 设计。因此,本文重点关注挑战(1):令牌低效问题。 为此,我们对专门为 LRMs 设计的近期高效推理方法进行了全面综述,旨在提高思维令牌的效率,同时保持推理质量。具体来说,我们提出了一个分层的分类法,首先将近期的方法分为两类。如图 2 所示,这两类分别是:(a)显式紧凑的思维链(CoT),它通过减少思维令牌数量同时保持显式推理结构;(b)隐式潜在的思维链(CoT),它将推理步骤编码在隐藏表示中,而非显式令牌中。此外,对于显式紧凑的 CoT,我们进一步总结了三个子类别:(a.1)CoT 压缩,(a.2)CoT 偏好优化,以及(a.3)基于奖励的 CoT 简洁性。接下来,我们分析这些类别的特点,并从推理质量和效率的角度讨论它们的优缺点。此外,我们还从性能和效率的角度进行了全面的实证研究。我们还识别了关于 LRMs 推理效率的四个开放挑战,包括以人为本的可控推理、推理效率与可互操作性之间的权衡、确保高效推理的安全性以及高效 LRMs 在数学和代码之外的更广泛应用。最后,我们强调了若干潜在的技术解决方案,旨在进一步改进现有方法,即模型合并、新架构和代理路由器。我们希望这项综述能够帮助研究人员和工程师进一步提高 LRMs 的高效推理。

本文的主要贡献如下:

• 我们对当前的高效推理方法进行了全面的文献综述,并通过分层分类法进行优势和劣势的讨论。 • 我们从性能和效率的角度对近期方法进行了实证研究,并总结了关于用户控制、可解释性、安全性和应用方面的四大挑战。 • 我们从模型合并、非自回归架构和代理路由器的角度,强调了进一步改进现有方法的技术见解。