黑盒AI模型的激增促使需要解释其内部机制并证明它们的可靠性,特别是在高风险应用领域,如医疗保健和自动驾驶。由于缺乏可解释AI(XAI)的严格定义,开发了大量与可解释性、可解读性和透明度相关的研究,以从不同角度解释和分析模型。因此,面对一长串的论文,要全面了解XAI研究的所有方面变得具有挑战性。考虑到神经网络在AI研究中的流行,我们将关注范围缩窄到XAI研究的一个特定领域:基于梯度的解释,这可以直接用于神经网络模型。在这篇综述中,我们系统地探索了迄今为止基于梯度的解释方法,并引入了一个新的分类体系,将它们分为四个不同的类别。然后,我们按时间顺序介绍技术细节的精髓,并强调算法的演变。接下来,我们引入人类和量化评估来衡量算法性能。更重要的是,我们展示了XAI的一般挑战和基于梯度解释的特定挑战。我们希望这篇综述能帮助研究人员理解最新进展及其相应的缺点,这可能会激发他们在未来工作中解决这些问题的兴趣。

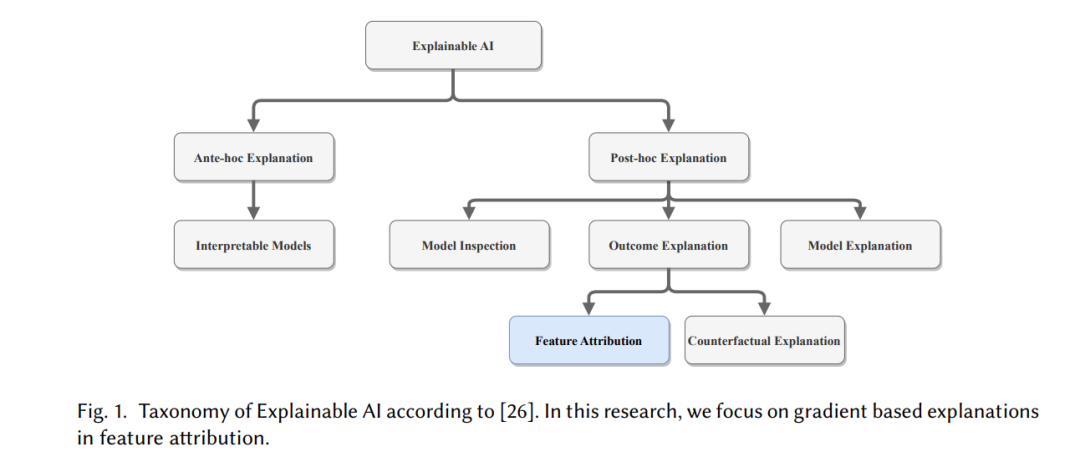

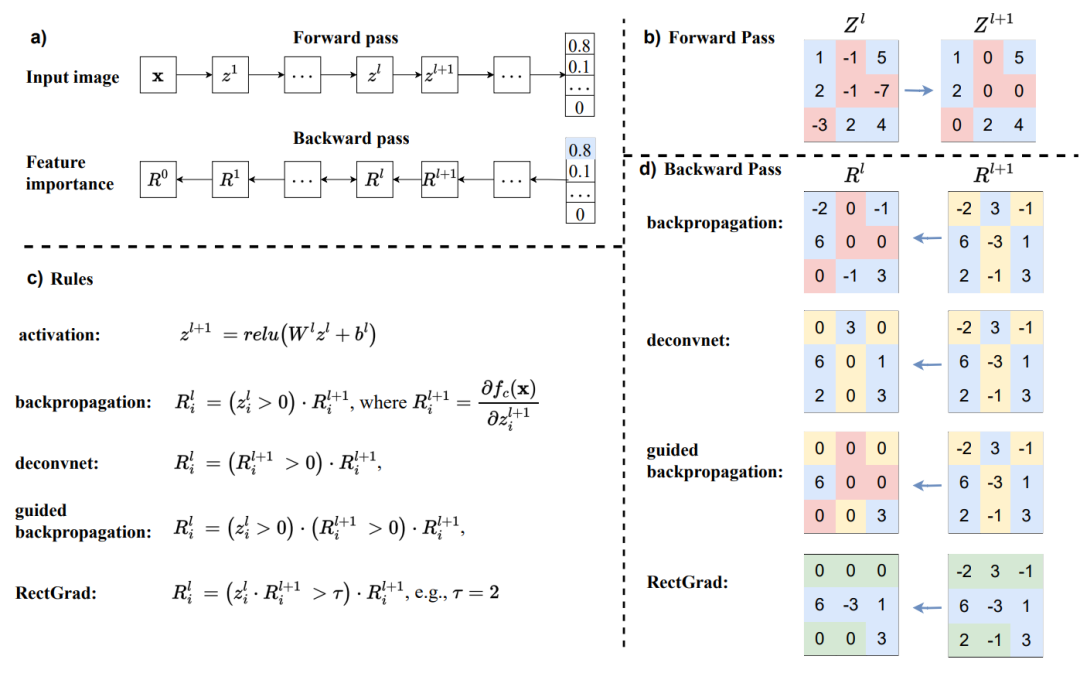

如今,我们目睹了在各个领域内神经网络模型的显著激增,例如,计算机视觉 [28, 43, 54]、自然语言处理 [10, 53, 97]、机器人学 [9, 47] 和医疗保健 [36, 75]。由于它们不透明的决策过程,AI模型可能会对少数民族表现出偏见或做出意外且可能灾难性的错误。例如,ProPublica报告称,COMPAS司法系统对非洲裔美国人的被告存在偏见,预测他们重新犯罪的可能性较高 [35]。Ribeiro等人 [70] 观察到,模型在背景中存在雪的情况下区分狼和哈士奇犬。因此,迫切需要阐明内部过程,理解决策机制,并增强用户对AI系统的信任。 可解释AI(XAI)指的是一系列旨在推理和理解模型行为、提供洞见以纠正模型错误/偏见,并最终使用户接受并信任模型预测的技术。根据Guidotti等人 [26] 的分类,如图1所示,XAI可以被分类为以下方面:先验解释和事后解释。先验解释努力开发用户可以直接理解的透明模型,无需额外的解释工具,例如,决策树 [69] 和决策规则 [31]。事后解释旨在通过利用输入特征与模型预测之间的关系来解释训练过的黑盒模型。事后解释可以进一步分为模型解释 [13, 45]、结果解释 [70, 84] 和模型检查 [18, 23]。模型解释涉及使用在全局级别上可解释和透明的模型来近似黑盒模型的整体逻辑。结果解释专注于探索特定预测的背后原因,属于局部级别。模型检查旨在提供视觉和文本表示,以便于理解模型的工作机制。 在结果解释中通常采用两种方法:特征归因(也称为特征重要性方法)和反事实解释。特征归因直接识别输入特征对模型输出的重要性,而反事实解释探索输入空间中的最小且有意义的扰动,以回答输入值的哪些变化可能会影响模型的预测。为了更深入地探索两种方法之间的联系,我们引用了Kommiya Mothilal等人的研究 [42]。

1.1 本综述的目的

由于缺乏一个普遍且严格的可解释AI(XAI)定义,大量与可解释性、可解读性、透明度及其他相关概念的研究都属于XAI领域。在谷歌学术上搜索“可解释AI”关键词会得到超过200,000个结果,这给在单一出版物内全面阐述XAI的所有方面带来了巨大挑战。尽管已有许多关于XAI的综述文章或书籍章节 [2, 5, 11, 14, 14, 21, 26, 30, 51,58, 73, 85],但大多数仅简要描述并展示了XAI的某个特定子领域,如基于梯度的特征归因的早期工作。这种对特定子领域的欠充分探索激励我们全面概述基于梯度解释的最新进展。先前的综述旨在帮助从业者快速掌握XAI的各个方面,而我们的综述文章深入探讨了基于梯度解释方法的算法细节。通过这样做,我们的目的是帮助研究人员在更多应用中采用适当的方法,并在这一狭窄领域内促进创新突破。 基于不同的方法论途径,特征归因包含以下研究分支:基于扰动的方法 [16, 17, 95]、基于替代的方法 [25, 70]、基于分解的方法 [6, 8, 59, 60] 以及基于梯度的方法 [79, 81, 84]。然而,在本文中,我们专注于基于梯度的方法,出于以下考虑。

梯度的直觉。梯度量化了输入特征中的无穷小变化如何影响模型预测。因此,我们可以利用梯度及其变体有效地分析特征修改对模型预测结果的影响。

神经网络的无缝集成。神经网络在各个领域获得了极大的流行度和令人印象深刻的性能。在模型训练后,可以通过反向传播轻松获得梯度。因此,基于梯度的解释能够直接解释神经网络,无需对模型本身进行任何更改。

满足公理化属性。由于缺乏真实基准,特征归因方法可能会产生不同的解释,这导致了确定哪个解释更可信的挑战。基于梯度的解释是有意设计来满足某些公理化原则的,例如敏感性和完整性,确保产生合理且期望的解释。

1.2 我们的贡献

我们综述的贡献总结如下:

我们提出了一个新颖的分类体系,系统地将基于梯度的特征归因分为四组。随后,我们介绍了每组算法的研究动机和技术细节的要点。

我们全面概述了一系列广泛接受的评估指标,包括人类评估和客观指标,使得可以定量和定性地比较各种解释方法的性能。

我们总结了XAI中的一般研究挑战以及基于梯度解释特有的特定挑战,这些挑战可能会滋养并为未来工作中的潜在改进奠定基础。