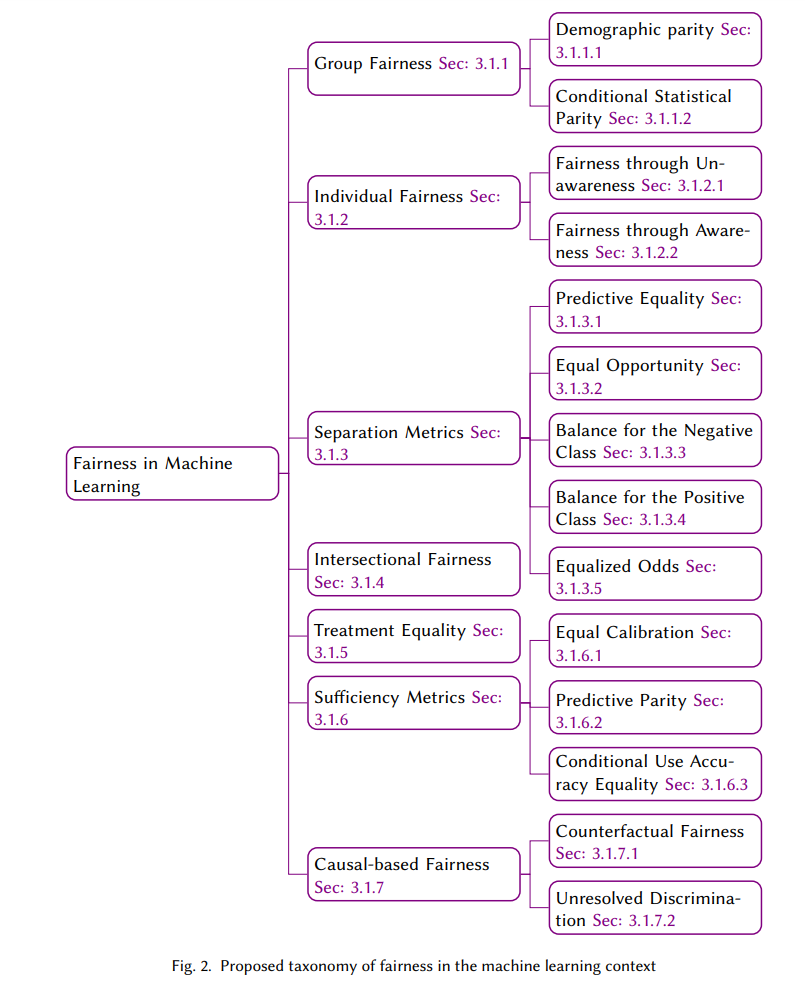

![]() 人工智能(AI)模型现在被用于我们生活的所有方面,如医疗保健、教育和就业。由于它们被用于许多敏感的环境中,并做出可能改变生活的决策,潜在的偏见结果是一个紧迫的问题。开发者应确保这些模型不会表现出任何意料之外的歧视性做法,如对某些性别、种族或残疾人的偏见。随着AI系统的普遍传播,研究人员和从业者越来越意识到不公平的模型,并努力减少其中的偏见。已经进行了大量研究来解决这些问题,以确保模型不会有意或无意地延续偏见。本综述提供了研究人员促进AI系统公平性的不同方法的概要。我们探讨了当前文献中存在的不同公平性定义。我们通过对不同类型的偏见进行分类并研究不同应用领域中偏见AI的案例,创建了一个综合性的分类体系。对研究人员减少AI模型中偏见所采用的方法和技术进行了彻底的研究。此外,我们还深入了解了偏见模型对用户体验的影响以及在开发和部署这些模型时需要考虑的伦理问题。我们希望这篇综述能帮助研究人员和从业者理解AI系统中公平性和偏见的复杂细节。通过分享这篇彻底的综述,我们旨在促进公平和负责任的AI领域的额外讨论。 自动化系统的使用在各个领域迅速推进,影响着从招聘员工到推荐系统的一切。AI系统嵌入到我们的日常活动中,并极大地影响着我们的生活,特别是当用于做出改变生活的决策时。这些模型具有巨大潜力,因为它们可以整合大量数据并比人类更有效、更快地执行非常复杂的计算。然而,在AI的潜力中,关于这些系统中的公平性和偏见问题也随之而来。由于这些系统在医疗保健、金融和刑事司法等领域被用于为个人做出重要决策,确保这些模型的公平性至关重要。 近年来,AI偏见的多个案例被曝光,它对个人和社区的重大影响是不可避免的。例如,在美国,用于判定重新犯罪评分的算法被发现对黑人被告有偏见。谷歌Bard被看到通过陈述男孩想要实现目标并在生活中做出改变,而女孩想要爱和关怀来描绘性别刻板印象。这只是两个例子,但像这样的众多问题导致了在开发和部署公平AI模型方面的兴趣不断增长。图1显示了过去七年在这一领域发表的论文数量。多年来,该领域发表的论文量稳步增加。到2021年,论文数量激增超过1000篇。稳定增长的结果是,去年发表的论文接近惊人的2000篇。该图强调了这些主题多年来在研究社区中的重要性。 在评估模型的公平性时,已经使用了多个公平性定义。本综述探讨了文献中讨论的所有不同的公平性标准。许多研究人员一直在努力解决自动化模型中的公平性问题。在公平AI的广泛领域内,研究人员提出了多种策略来解决和减少其中的偏见。同时,也重要的是要意识到,某些策略只适用于某些类型的偏见。本文详细描述了不同类型的偏见和用于减少这些偏见的所有常见方法。此外,本综述还涵盖了不公平的原因、包括但不限于医疗保健、教育和金融等不同领域内偏见案例的详细信息。努力使AI模型公平也可以增强用户体验。在本文中,我们讨论了偏见模型对用户的影响以及应遵循的确保用户信任的伦理指南。在论文的最后,我们提到了当前文献的挑战和局限性。总的来说,本文的目的是阐明在AI模型的背景下关于偏见和公平性所做的现有工作。我们希望这篇论文能为研究人员和实践者提供这一领域的丰富视角,并鼓励他们确定自己的研究方向,并开发创新想法以减少意外后果。

人工智能(AI)模型现在被用于我们生活的所有方面,如医疗保健、教育和就业。由于它们被用于许多敏感的环境中,并做出可能改变生活的决策,潜在的偏见结果是一个紧迫的问题。开发者应确保这些模型不会表现出任何意料之外的歧视性做法,如对某些性别、种族或残疾人的偏见。随着AI系统的普遍传播,研究人员和从业者越来越意识到不公平的模型,并努力减少其中的偏见。已经进行了大量研究来解决这些问题,以确保模型不会有意或无意地延续偏见。本综述提供了研究人员促进AI系统公平性的不同方法的概要。我们探讨了当前文献中存在的不同公平性定义。我们通过对不同类型的偏见进行分类并研究不同应用领域中偏见AI的案例,创建了一个综合性的分类体系。对研究人员减少AI模型中偏见所采用的方法和技术进行了彻底的研究。此外,我们还深入了解了偏见模型对用户体验的影响以及在开发和部署这些模型时需要考虑的伦理问题。我们希望这篇综述能帮助研究人员和从业者理解AI系统中公平性和偏见的复杂细节。通过分享这篇彻底的综述,我们旨在促进公平和负责任的AI领域的额外讨论。 自动化系统的使用在各个领域迅速推进,影响着从招聘员工到推荐系统的一切。AI系统嵌入到我们的日常活动中,并极大地影响着我们的生活,特别是当用于做出改变生活的决策时。这些模型具有巨大潜力,因为它们可以整合大量数据并比人类更有效、更快地执行非常复杂的计算。然而,在AI的潜力中,关于这些系统中的公平性和偏见问题也随之而来。由于这些系统在医疗保健、金融和刑事司法等领域被用于为个人做出重要决策,确保这些模型的公平性至关重要。 近年来,AI偏见的多个案例被曝光,它对个人和社区的重大影响是不可避免的。例如,在美国,用于判定重新犯罪评分的算法被发现对黑人被告有偏见。谷歌Bard被看到通过陈述男孩想要实现目标并在生活中做出改变,而女孩想要爱和关怀来描绘性别刻板印象。这只是两个例子,但像这样的众多问题导致了在开发和部署公平AI模型方面的兴趣不断增长。图1显示了过去七年在这一领域发表的论文数量。多年来,该领域发表的论文量稳步增加。到2021年,论文数量激增超过1000篇。稳定增长的结果是,去年发表的论文接近惊人的2000篇。该图强调了这些主题多年来在研究社区中的重要性。 在评估模型的公平性时,已经使用了多个公平性定义。本综述探讨了文献中讨论的所有不同的公平性标准。许多研究人员一直在努力解决自动化模型中的公平性问题。在公平AI的广泛领域内,研究人员提出了多种策略来解决和减少其中的偏见。同时,也重要的是要意识到,某些策略只适用于某些类型的偏见。本文详细描述了不同类型的偏见和用于减少这些偏见的所有常见方法。此外,本综述还涵盖了不公平的原因、包括但不限于医疗保健、教育和金融等不同领域内偏见案例的详细信息。努力使AI模型公平也可以增强用户体验。在本文中,我们讨论了偏见模型对用户的影响以及应遵循的确保用户信任的伦理指南。在论文的最后,我们提到了当前文献的挑战和局限性。总的来说,本文的目的是阐明在AI模型的背景下关于偏见和公平性所做的现有工作。我们希望这篇论文能为研究人员和实践者提供这一领域的丰富视角,并鼓励他们确定自己的研究方向,并开发创新想法以减少意外后果。 ![]()