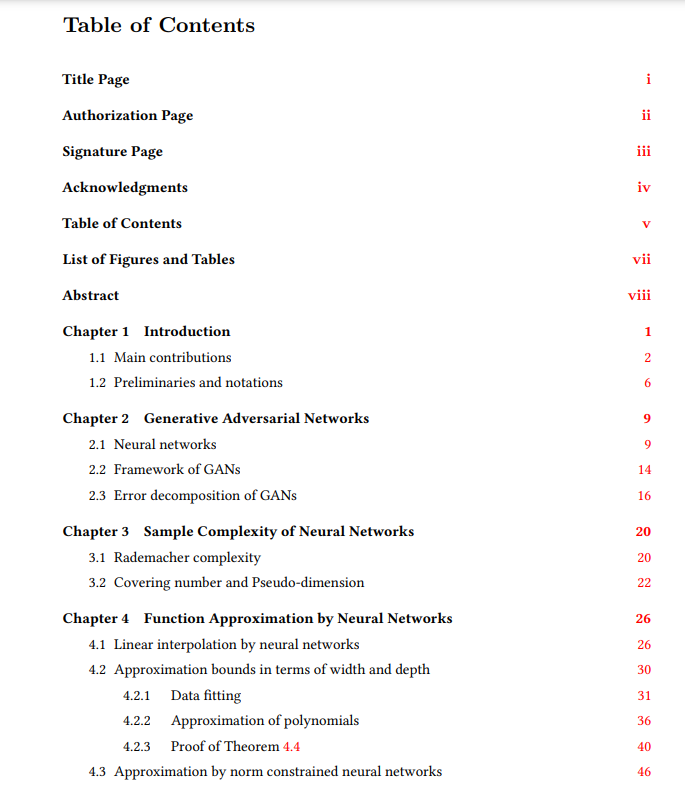

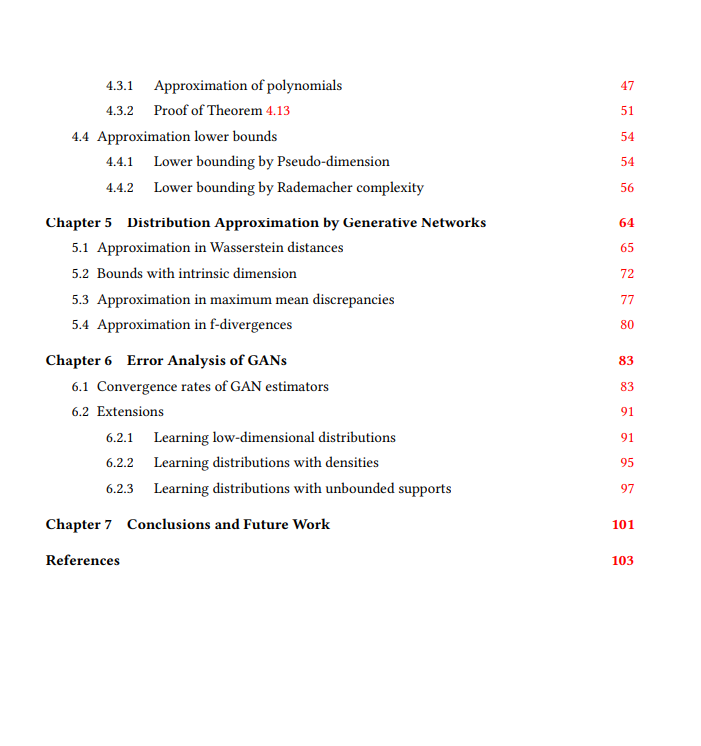

我们研究生成对抗网络(GAN)如何很好地学习有限样本的概率分布,通过分析这些模型的收敛速度。我们的分析基于一个新的oracle不等式,该不等式将GAN的估计误差分解为鉴别器和发生器的逼近误差、泛化误差和优化误差。为了估计鉴别器逼近误差,我们建立了用ReLU神经网络逼近Hölder函数的误差界,并给出了网络的Lipschitz常数的显式上界或权值的范数约束。对于发生器逼近误差,我们证明了神经网络可以将低维源分布近似转化为高维目标分布,并通过神经网络的宽度和深度约束这种逼近误差。结合统计学习理论中神经网络的泛化边界和近似结果,我们建立了GANs在各种设置下的收敛速度,当误差由Hölder类定义的积分概率度量集合测量时,包括Wasserstein距离作为一种特殊情况。特别地,对于集中在低维集合周围的分布,我们证明了GANs的收敛速度不依赖于高的环境维数,而是依赖于较低的本征维数。

成为VIP会员查看完整内容

相关内容

专知会员服务

54+阅读 · 2020年3月5日

Arxiv

22+阅读 · 2021年12月22日

Arxiv

13+阅读 · 2021年3月10日