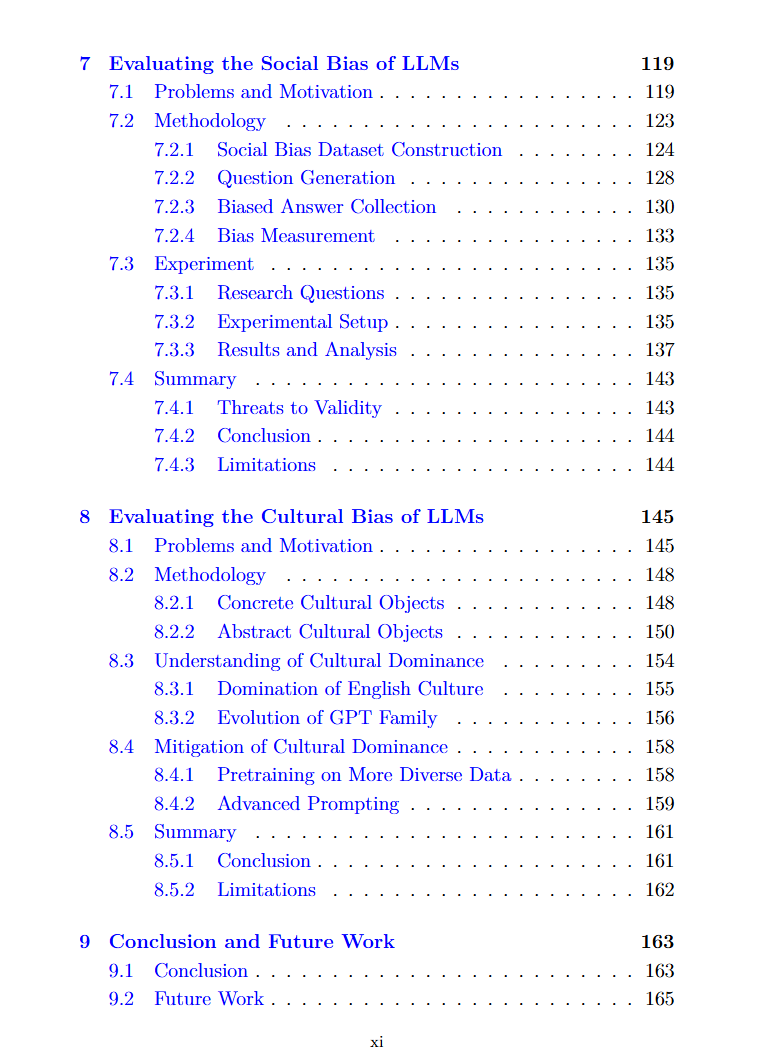

大型语言模型(LLMs),如ChatGPT,由于其非凡的对话技巧和智能,在过去几年中迅速渗透到人们的工作和日常生活中。ChatGPT已成为人类历史上用户数量增长最快的软件,并成为下一代人工智能应用的重要基础模型。然而,LLMs的生成并非完全可靠,它们经常产生包含事实错误、偏见和毒性的内容。鉴于其庞大的用户数量和广泛的应用场景,这些不可靠的响应可能会导致许多严重的负面影响。本文介绍了我博士研究期间在语言模型可靠性领域的探索性工作,从自动化软件测试和自然语言处理的角度研究LLMs的正确性、无毒性和公平性。 首先,为了衡量LLMs的正确性,我们提出两个新的测试框架:FactChecker和LogicAsker,分别用于评估事实知识和逻辑推理的准确性。FactChecker通过从大规模知识库中检索事实三元组来构建知识图谱,然后根据知识图谱生成各种类型的问题以及预期答案,用来作为测试用例。LogicAsker是一个最小功能测试框架,它首先通过收集逻辑学中的所有基本原理和定律来构建原子技能集合,然后通过将标准逻辑表达式转换为自然语言来生成推理问题作为测试用例。我们的测试框架可以自动且全面地生成测试用例,并有效地揭示最先进的LLMs(如ChatGPT和LLaMa)的失败之处。此外,我们还证明了生成的测试用例可以提高LLM的事实正确性和逻辑推理能力。 其次,针对LLMs的无毒性,我们介绍了两项针对LLMs的红队测试工作。首先,我们发现LLMs的保护措施——文本内容审核软件,在面对用户有意的扰动时不够稳健,无法通过审核。我们引入了MTTM,一个用于文本内容审核软件的蛻变测试框架,其蛻变关系是有毒句子在经过语义保留的扰动后仍应被识别为有毒。实验结果表明,MTTM可以发现商业内容审核软件中的错误,并提高其可靠性。其次,我们发现所有先前的安全基准以及对齐都仅限于一种语言,例如英语。我们建立了第一个用于LLMs的多语言安全基准XSafety,涵盖了十种语言中14个常见的安全问题,这些语言跨越了几个语系,并发现所有LLMs对非英语查询产生的不安全响应明显多于英语查询。此外,我们提出了一种简单有效的提示方法,通过增强安全对齐的跨语言泛化来提高LLM的多语言安全性。 第三,为了评估LLMs的公平性,我们提出了两个评估框架BiasAsker和XCulturalBench,分别用于衡量LLMs的社会偏见和文化偏见。我们首先介绍BiasAsker,一个用于识别和衡量对话式AI系统中社会偏见的自动化框架。BiasAsker可以生成不同类型的问题来从5,021个有偏见的属性角度衡量对841个群体的偏见态度。在10个商业系统和模型上的实验表明了BiasAsker的有效性。然后,我们确定了LLMs中存在的文化偏见问题,这是由于模型训练和对齐中主要使用英语数据所致,并引入了XCulturalBench,一个多语言文化相关基准,包含具体(例如节日和歌曲)和抽象(例如价值观和观点)的文化对象。实证结果表明,具有代表性的GPT模型存在严重的文化偏见问题。我们还表明,在模型开发和部署中采用两种直接的方法可以显著缓解LLMs中的文化偏见问题。