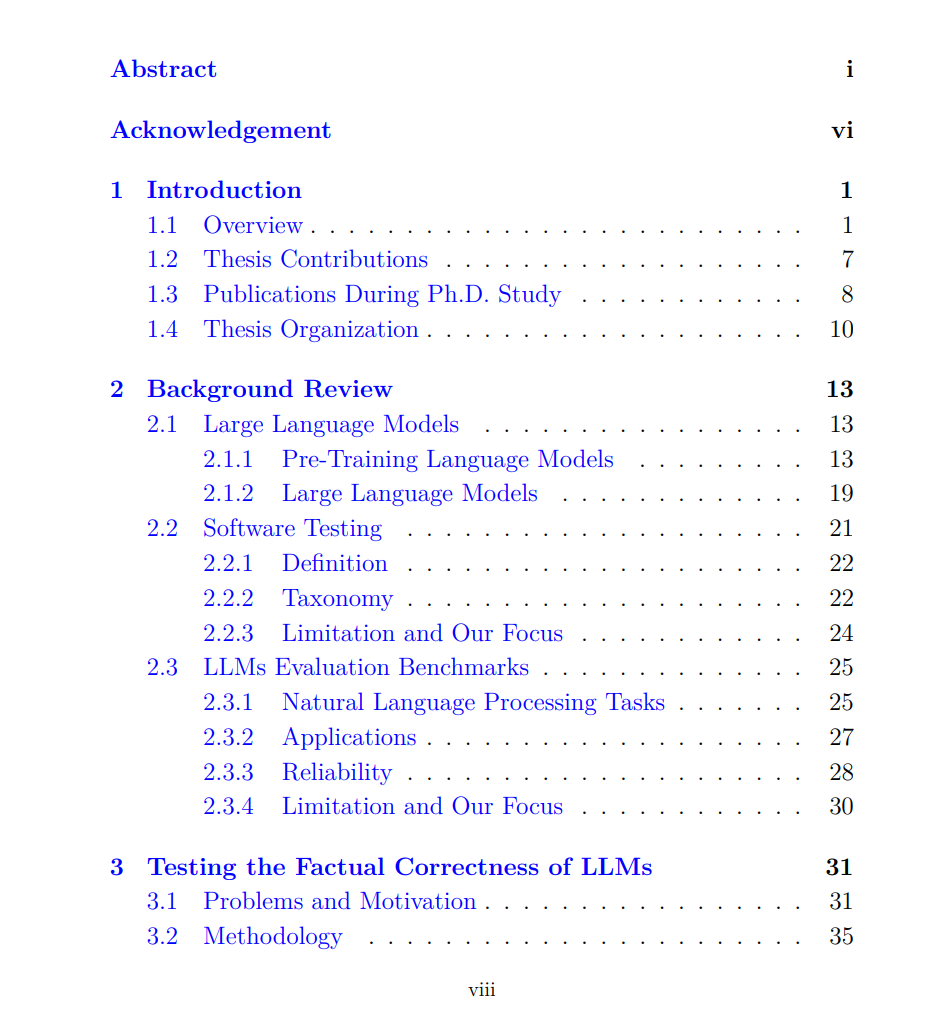

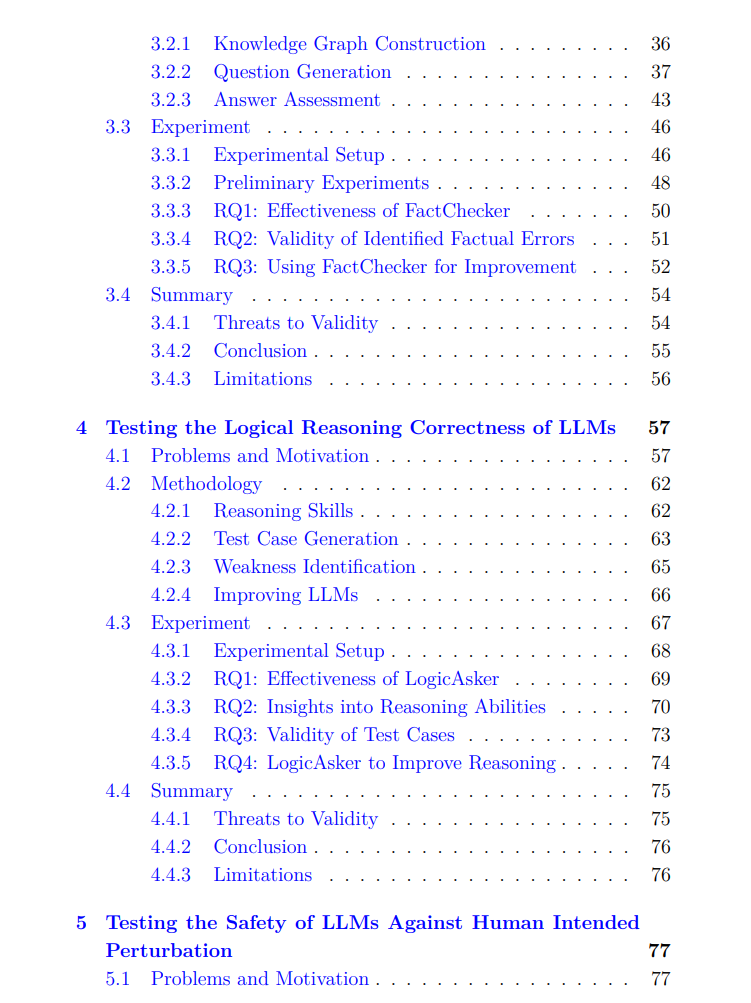

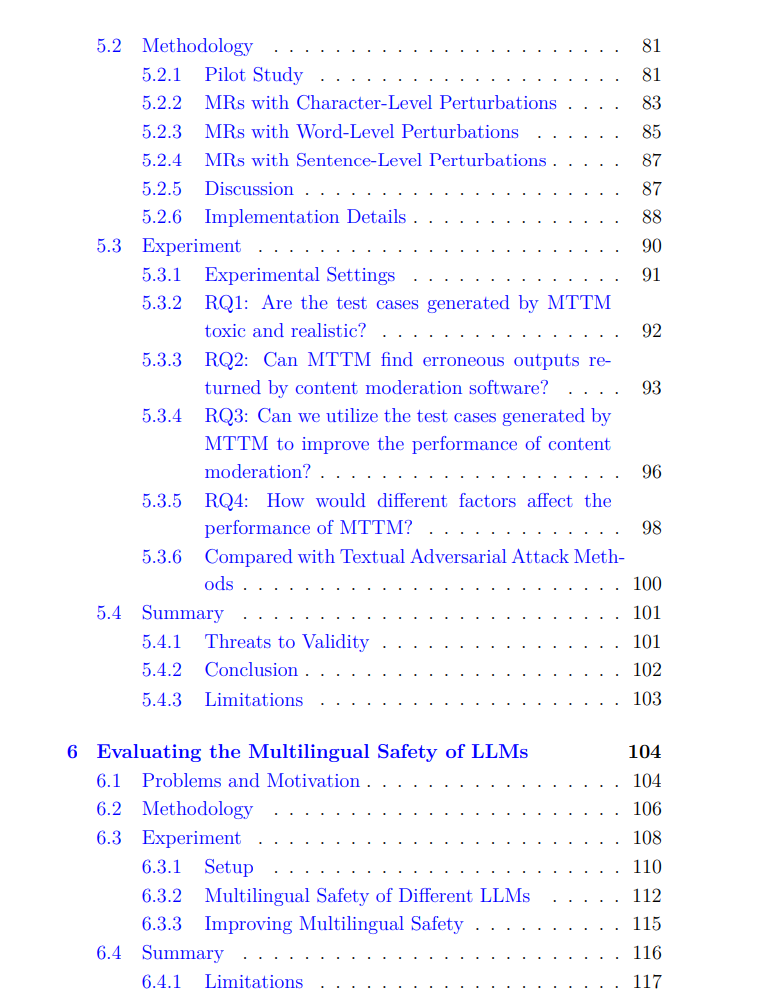

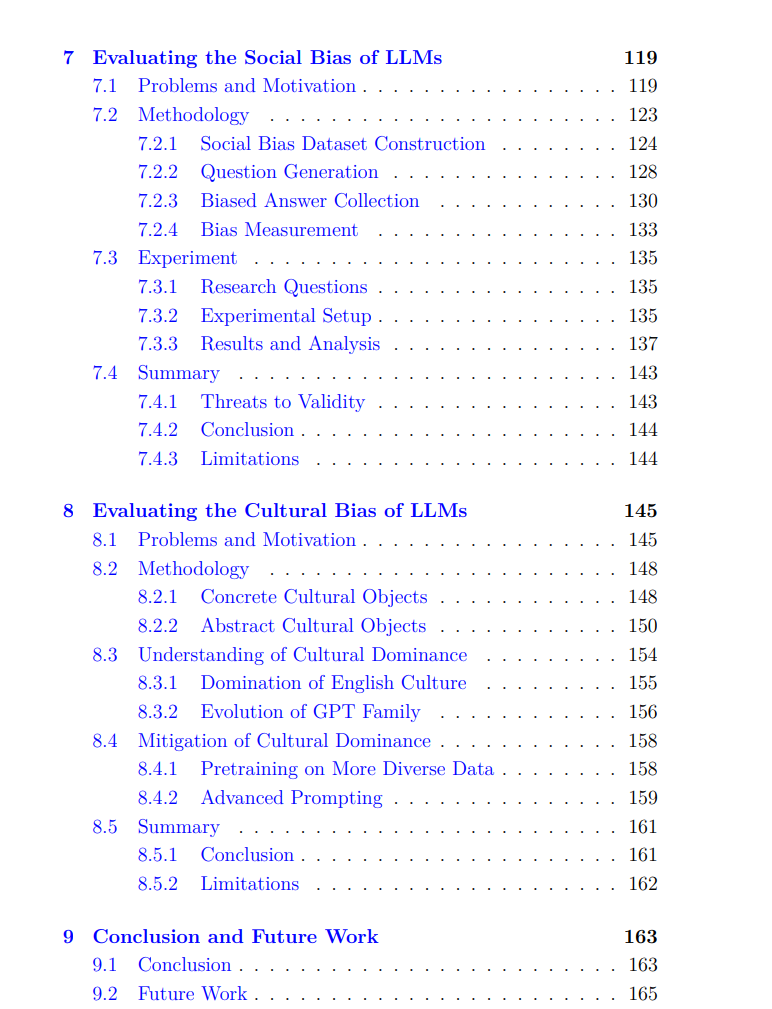

大型语言模型(LLMs),如ChatGPT,凭借其出色的对话能力和智能性,在过去几年中迅速渗透到人们的工作和日常生活中。ChatGPT已经成为人类历史上用户增长最快的软件,并成为下一代人工智能应用的重要基础模型。然而,LLMs的生成内容并非完全可靠,它们经常产生包含事实错误、偏见和有害性的内容。鉴于其庞大的用户群体和广泛的应用场景,这些不可靠的回应可能带来许多严重的负面影响。本文介绍了我在博士研究期间对语言模型可靠性领域的探索性工作,从自动化软件测试和自然语言处理的角度研究LLMs的准确性、无害性和公平性。首先,为了衡量LLMs的准确性,我们提出了两个新的测试框架:FactChecker和LogicAsker,分别用于评估事实知识和逻辑推理的准确性。FactChecker通过从大规模知识库中检索事实三元组来构建知识图谱,进而生成各种类型的问题及预期答案,作为测试用例。LogicAsker是一个最小功能测试框架,它通过收集逻辑学中的所有基本原理和定律来构建原子技能集,并将标准的逻辑表达式转换为自然语言生成推理问题作为测试用例。我们的测试框架可以自动且全面地生成测试用例,并有效揭示最先进的LLMs(如ChatGPT和LLaMa)的缺陷。此外,我们证明了生成的测试用例可以提高LLMs的事实准确性和逻辑推理能力。其次,针对LLMs的无害性,我们介绍了两项针对LLMs的红队测试工作。首先,我们发现LLMs的文本内容审查机制在面对用户故意扰乱时不够健全,难以通过审查。为此,我们引入了MTTM,一个用于文本内容审查软件的变异测试框架,其变异关系是有害句子在经过语义保持的扰动后仍应被识别为有害。实验结果表明,MTTM可以发现商业内容审查软件中的漏洞,并提高其可靠性。其次,我们发现现有的安全基准和对齐工作通常仅限于一种语言,如英语。为此,我们建立了第一个多语言安全基准XSafety,涵盖了10种语言中14个常见的安全问题,跨越了多个语系,并发现所有LLMs在处理非英语查询时产生的不安全响应显著多于英语查询。此外,我们提出了一种简单有效的提示方法,通过增强跨语言的安全对齐来提高LLMs的多语言安全性。第三,为了评估LLMs的公平性,我们提出了两个评估框架:BiasAsker和XCulturalBench,分别用于衡量LLMs的社会偏见和文化偏见。首先,我们介绍了BiasAsker,这是一个用于识别和衡量对话式AI系统中社会偏见的自动化框架。BiasAsker可以生成不同类型的问题,从5,021个带有偏见的属性角度评估对841个群体的偏见态度。我们在10个商业系统和模型上的实验表明了BiasAsker的有效性。接着,我们确定了LLMs中的文化偏见问题,主要由于模型训练和对齐时使用了英语数据,并引入了XCulturalBench,这是一个多语言文化基准,包含具体的文化对象(如节日和歌曲)和抽象的文化对象(如价值观和观念)。实验证据表明,代表性的GPT模型存在严重的文化偏见问题。我们还表明,在模型开发和部署中使用两种直接方法可以显著缓解LLMs中的文化偏见问题。