预训练的大型语言模型(LLM)和大型多模态模型(LMM)的迅速发展开启了智能应用的新时代,从自然语言处理到内容生成等领域都发生了变革。LLM供应链代表了当代人工智能领域的一个关键方面。它包括预训练模型的整个生命周期,从最初的开发和训练到最终的部署和在各个领域的应用。本文提供了LLM供应链的全面概述,突出了其三个核心元素:1)模型基础设施,包括用于训练、优化和部署的数据集和工具链;2)模型生命周期,涵盖训练、测试、发布和持续维护;3)下游应用生态系统,使预训练模型能够集成到各种智能应用中。然而,这个快速发展的领域在这些关键组成部分中面临着许多挑战,包括数据隐私和安全、模型可解释性和公平性、基础设施的可扩展性,以及监管合规性。解决这些挑战对于充分发挥LLM的潜力并确保其道德和负责任的使用至关重要。本文为LLM供应链提供了未来的研究议程,旨在推动这些变革性LLM的持续进步和负责任的部署。

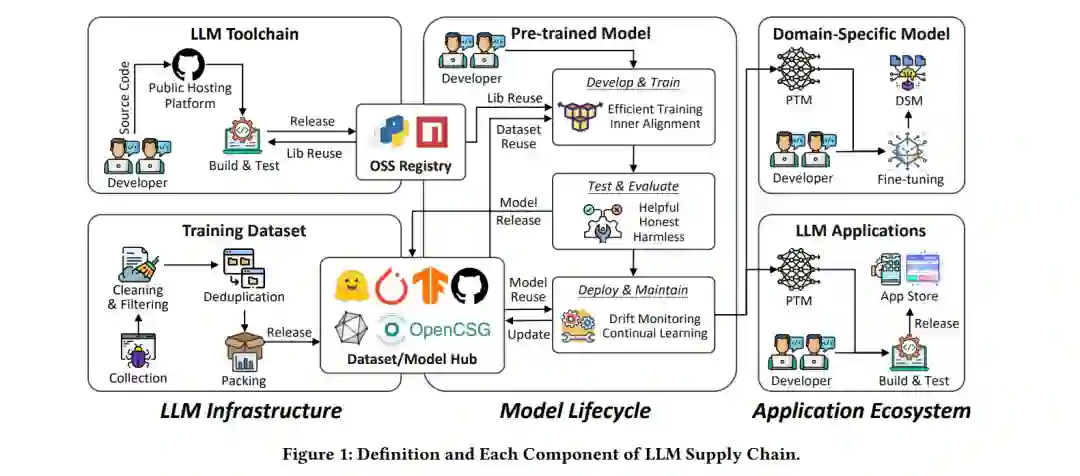

预训练的大型语言模型(LLM)和大型多模态模型(LMM),如GPT4 [2]、Gemini [183]和LLaMA [187]的快速进步,已经彻底改变了人工智能(AI)领域,开启了智能应用的新时代。这些强大的模型,经过大量数据的训练,已在从自然语言处理到多模态内容生成的广泛任务中展示了卓越的能力。 随着LLM的不断普及,支持其开发、部署和维护的强大且高效的供应链的需求变得越来越明显。LLM供应链涵盖了从模型训练到测试、发布及持续维护的整个生命周期。这一复杂的生态系统涉及多种利益相关者,包括模型开发者、数据提供者和终端用户,他们都必须应对一系列独特的挑战,以释放这些变革性技术的全部潜力。 在本文中,我们将全面概述LLM供应链,强调必须解决的关键组成部分和关键挑战,以确保LLM的安全、可靠和公平部署。我们将探索这一供应链的技术、伦理和操作方面,借鉴软件工程、系统架构、安全和数据治理领域的见解。我们的目标是全面理解LLM供应链,并识别可以推动这一快速发展领域未来的最有前景的研究和开发机会。 LLM供应链的定义类似于开源软件(OSS)供应链[93, 164, 204],LLM供应链指的是围绕模型的开发、分发和部署的关系网络。这一供应链包括上游的模型开发社区、模型仓库、分发平台和应用市场,以及数据提供者、工具链/模型开发者、维护者和终端用户。如图1所示,这一供应链可以进一步分为三个关键组成部分:

基础设施基础:LLM供应链的基础是坚实的模型基础设施,包括多样化数据集的策划和管理,以及支持模型高效训练、优化和部署的工具链(如PyTorch [158]、TensorFlow [184]和LangChain [94]);

模型生命周期:模型生命周期是复杂LLM供应链生态系统中的关键节点。这一全面的生命周期,覆盖了模型从概念到退役的整个过程,是供应链复杂相互依存关系的汇聚点。它不仅涵盖了模型重用引入的依赖关系,而且与基础设施层的数据集和开发工具供应链紧密交织;

- 下游应用生态系统:在模型基础设施和生命周期之上,LLM供应链包括一个活跃的下游应用生态系统。这一生态系统包括由LLM驱动的应用和服务,例如GPTs [144],以及直接将这些变革性技术的能力带给终端用户的领域特定模型(DSMs)。这些组成部分之间的复杂相互依存关系和互动构成了LLM供应链的支柱。通过这样定义LLM供应链,我们可以借鉴现有的OSS供应链研究的见解,并将其应用于LLM生态系统的独特需求和复杂性。这一全面的理解将为随后探索LLM供应链内的机会和挑战提供基础。

本文的其余部分安排如下。我们将在第3、第4和第5节分别深入讨论模型基础设施、模型生命周期和下游应用生态系统。每一节的结构依次为愿景、挑战和机会。最后,在第6节中我们将结束本文。

在本文中,我们对LLM供应链进行了全面探讨,深入研究了模型基础设施、生命周期和下游应用生态系统的复杂阶段。我们在每个阶段都确定了关键挑战,突出了未来研究的机会。在基础设施领域,我们强调了高质量数据集和鲁棒安全的工具链的至关重要性。LLM的生命周期,通过开发、测试、发布和维护阶段,显示出持续创新和警惕的需要,以确保模型保持有效、安全,并符合道德标准。对下游应用生态系统的探索,包括LLM应用市场、设备上的LLM和DSM,打开了一个窗口,展示了LLM在各行各业和各种应用中的未来潜力。总之,我们认为LLM供应链代表了一个充满活力和复杂的生态系统,希望本文能为未来研究提供一个议程。