可解释人工智能

·

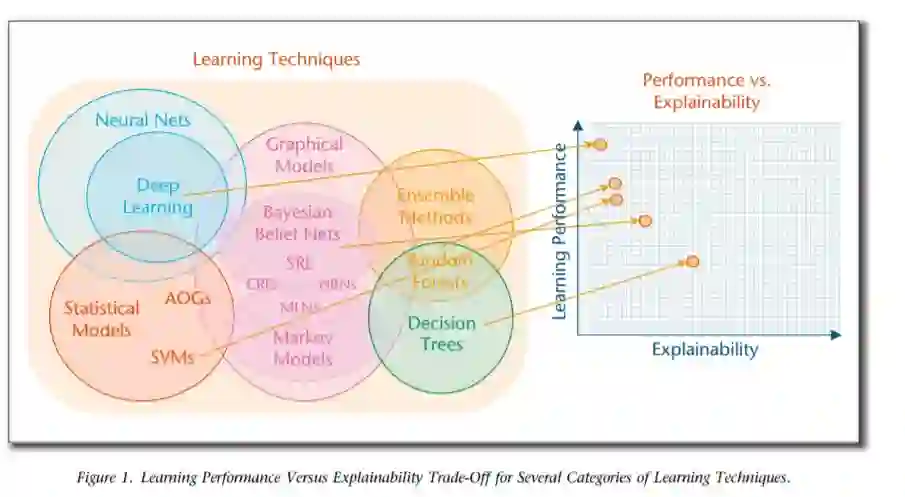

机器学习的巨大成功导致了AI应用的新浪潮(例如,交通、安全、医疗、金融、国防),这些应用提供了巨大的好处,但无法向人类用户解释它们的决定和行动。DARPA的可解释人工智能(XAI)项目致力于创建人工智能系统,其学习的模型和决策可以被最终用户理解并适当信任。实现这一目标需要学习更多可解释的模型、设计有效的解释界面和理解有效解释的心理要求的方法。XAI开发团队正在通过创建ML技术和开发原理、策略和人机交互技术来解决前两个挑战,以生成有效的解释。XAI的另一个团队正在通过总结、扩展和应用心理解释理论来解决第三个挑战,以帮助XAI评估人员定义一个合适的评估框架,开发团队将使用这个框架来测试他们的系统。XAI团队于2018年5月完成了第一个为期4年的项目。在一系列正在进行的评估中,开发人员团队正在评估他们的XAM系统的解释在多大程度上改善了用户理解、用户信任和用户任务性能。

成为VIP会员查看完整内容

相关内容

Arxiv

3+阅读 · 2019年9月3日