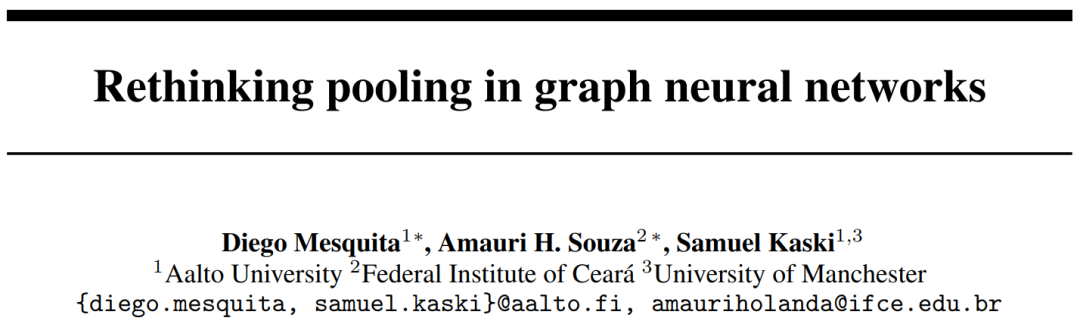

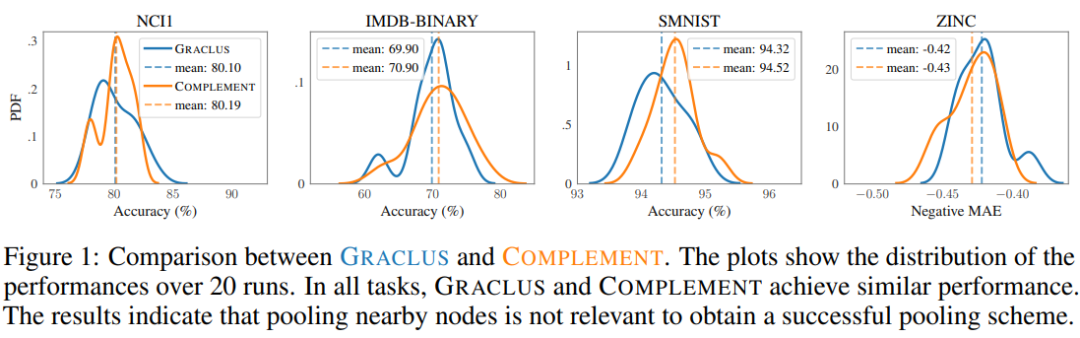

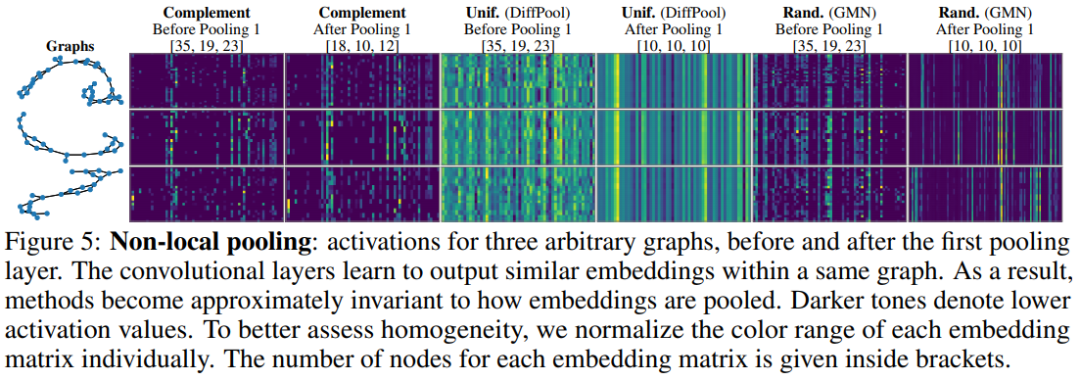

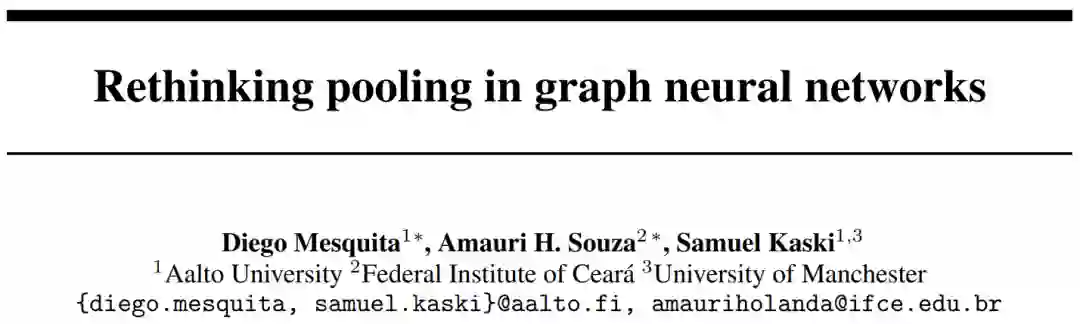

图池化是众多图神经网络(GNN)架构的核心组件。由于继承了传统的CNNs,大多数方法将图池化为一个聚类分配问题,将规则网格中的局部patch的思想扩展到图中。尽管广泛遵循了这种设计选择,但没有任何工作严格评估过它对GNNs成功的影响。我们以代表性的GNN为基础,并引入了一些变体,这些变体挑战了在补充图上使用随机化或聚类的局部保持表示的需要。引人注目的是,我们的实验表明,使用这些变体不会导致任何性能下降。为了理解这一现象,我们研究了卷积层和随后的池层之间的相互作用。我们证明了卷积在学习的表示法中起着主导作用。与通常的看法相反,局部池化不是GNNs在相关和广泛使用的基准测试中成功的原因。

成为VIP会员查看完整内容