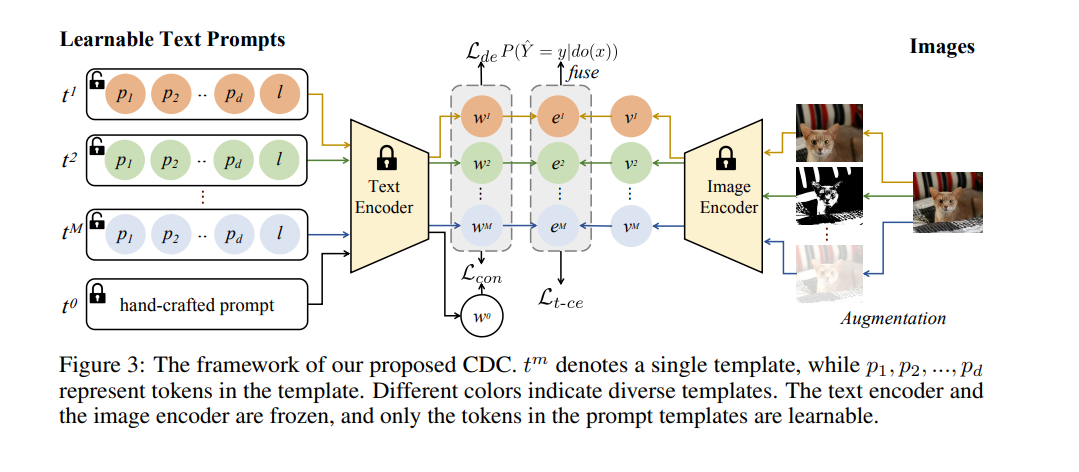

基础视觉-语言模型(如CLIP)在下游任务中展示了出色的泛化能力。然而,CLIP在适应特定任务时存在两个层次的失配问题,即任务失配和数据失配。虽然软提示调优在一定程度上缓解了任务失配,但数据失配仍然是一个挑战。为分析数据失配的影响,我们重新审视了CLIP的预训练和适应过程,并构建了一个结构化因果模型。我们发现,尽管期望精确捕捉下游任务的相关信息,但与任务无关的知识影响了预测结果,并阻碍了真实图像与预测类别之间关系的建模。由于任务无关的知识是不可观察的,我们利用前门调整并提出因果引导的语义解耦与分类方法(CDC)来减少任务无关知识的干扰。具体而言,我们对下游任务数据中包含的语义进行解耦,并基于每个语义执行分类。此外,我们采用Dempster-Shafer证据理论来评估由不同语义生成的每个预测的不确定性。在多种不同设置下进行的实验一致证明了CDC的有效性。

成为VIP会员查看完整内容

相关内容

Arxiv

42+阅读 · 2023年4月19日