摘要

在分类、跟踪、检测等高等级计算机视觉任务中,Dropout操作被广泛用于降低模型在训练集上过拟合的风险,但这一操作在图像超分辨等底层视觉任务中仍未得到充分的探索。作为一种经典的回归问题,图像超分辨任务不仅值域连续,其性能也与Dropout的利用息息相关。本文的核心思想是Dropout同样可以适用于底层计算机视觉任务,只是对于dropout的加入方式需要进行细微的调整,合理的应用dropout能够带来网络性能的提升。因此,本文作者进行了细致的实验与分析,证实合理使用dropout有益于超分模型性能提升,并改善其泛化性能 。

动机

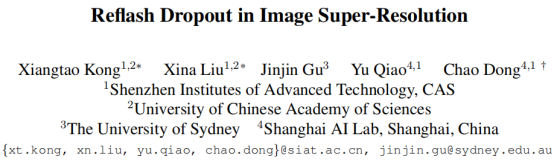

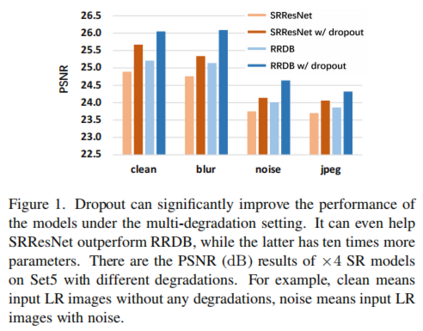

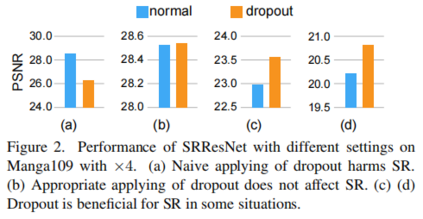

图像超分辨率(SR)是一种典型的底层计算机视觉任务,旨在从低分辨率输入恢复高分辨率图像。近年来,得益于强大的深度学习网络,深度SR模型可以轻松地拟合训练数据并在合成数据集上取得较好的性能。然而,当这些模型被应用于真实图像时,过拟合问题逐渐得到了研究人员的关注。 直观来看,针对过拟合问题提出的Dropout操作似乎只适用于分类、跟踪、检测等高等级计算机视觉任务,在图像超分辨模型中使用Dropout操作会使得输出中的部分表观像素缺失。然而,本文作者通过两种方法:通道显著图(channel saliency map)与深度退化表观(deep degradation representation)进行分析,结果证明引入dropout可以大幅提升模型的泛化性能 ,甚至可以将SRResNet的提升到优于RRDB的程度(如下图)。在此基础上,作者讨论了两个重点:一是如何加入dropout以提高超分网络性能,二是如何对dropout带来网络性能的提升。

方法

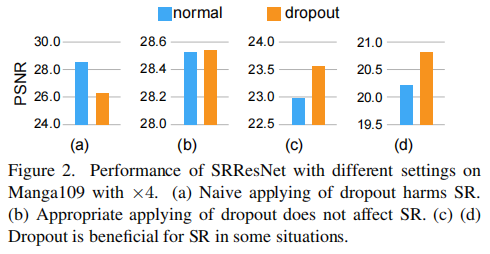

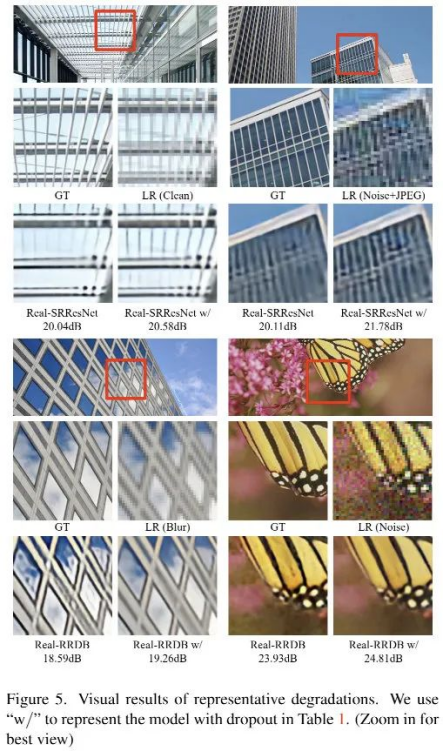

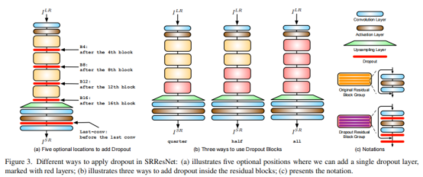

作者使用SRResNet作为基准模型探索如何进入Dropout操作,共考虑了三个因素:加入的位置,加入的比例,加入的方式。下图给出了dropout加入位置的示意图: * dropout before the last-conv ,见下图a,这也是本文最终的发现与结论; * dropout at middle of network ,见下图a; * dropout in residual network ,见下图c与b。

dropout的比例设置为0.1,0.2,0.3,其方式分为element-wise对元素进行drop,以及channel-wise对特征通道进行drop。

实验结果 如何加入Dropout

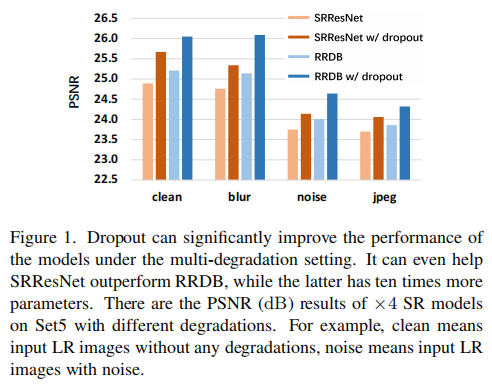

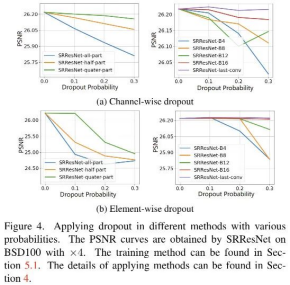

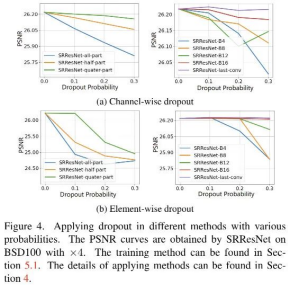

本文作者在双线性退化图像(bicubic)上探索Dropout的使用方式。下图给出了关于dropout使用位置、概率以及形式的实验结果对比,从中可以看到: 不同的dropout位置具有完全不同的性能,a方案last-conv性能最佳 。 channel-wise的dropout比Element-wise的dropout具有更好的性能; 更大的dropout比例会带来负面影响,10%是一个不错的选择。 last-conv+channel的实用组合可以带来有效且鲁棒的模型性能。

复合退化设定

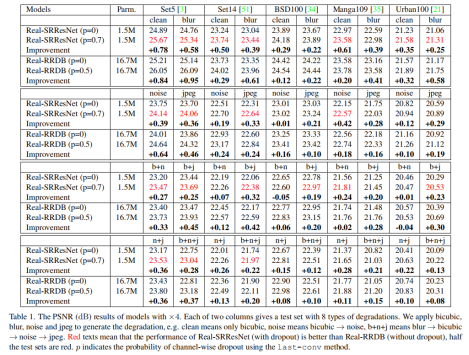

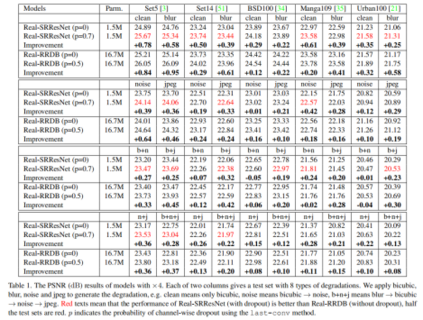

下表给出了不同配置下使用dropout前后的性能对比,从中可以看到:引入dropout可以大幅改善模型在多退化配置下的性能。

Dropout导致性能提升的原因

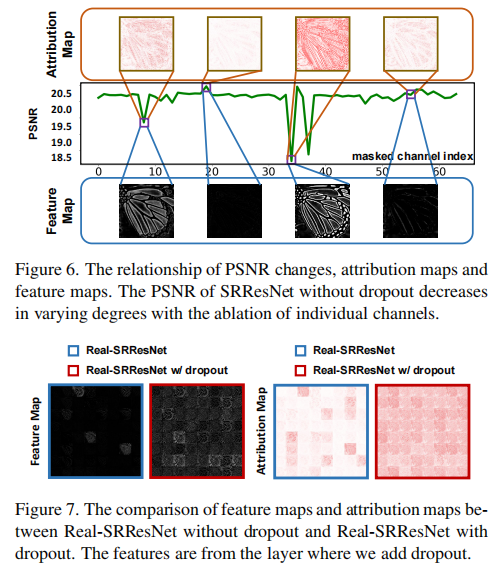

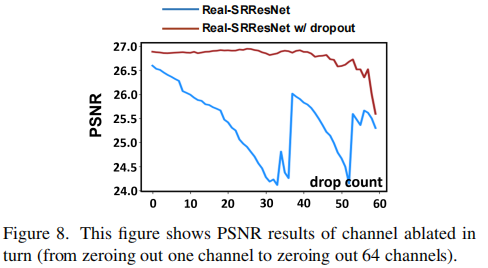

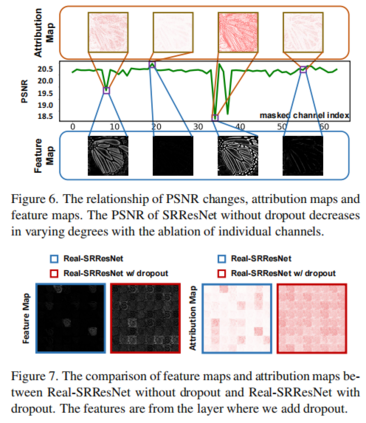

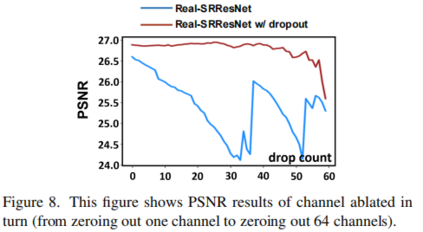

通过实验,作者给出了PSNR与显著性图之间的相关性。当对某些特征进行mask后,我们可以得到不同的PSNR值,低PSNR对应了更亮的显著性图,更亮的只意味着对超分结果的更大影响。很明显:不同特征对于最终的结果影响程度是不一样的 。

从上述实验结果可以发现,Dropout操作能够平衡特征之间的信息量:

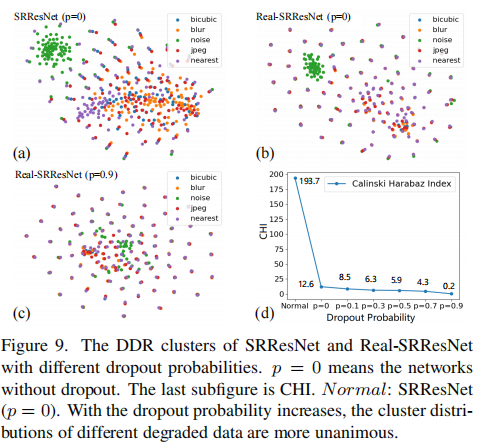

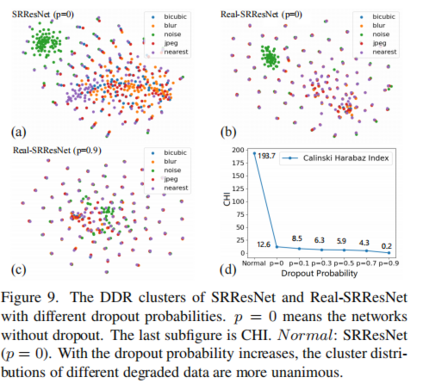

而引入Dropout后,本文采用DDR工具进行了泛化性分析。下图每一个点都代表对应不同退化方式的一张图,网络如果有较好的泛化性能,那么对于同一张高分辨率图,基于不同退化方式生成的low-resolution图,网络都能进行较好地超分。反映在下面的聚类图上,由于有5种退化方式,如果每个退化方式的点都非常靠近,聚成一类,表明网络更有专门解决这种退化方式的能力,例如(a)(b)图中的绿色点。

结论 在本研究中,作者探讨了在SR任务中dropout的用法和工作机理。具体地说,本文发现使用last-conv方法添加dropout可以有效地提高在多退化设置下的SR网络性能。在工作机制上,本文发现dropout确实提高了信道的表示能力和网络的泛化能力。 https://arxiv.org/pdf/2112.12089.pdf